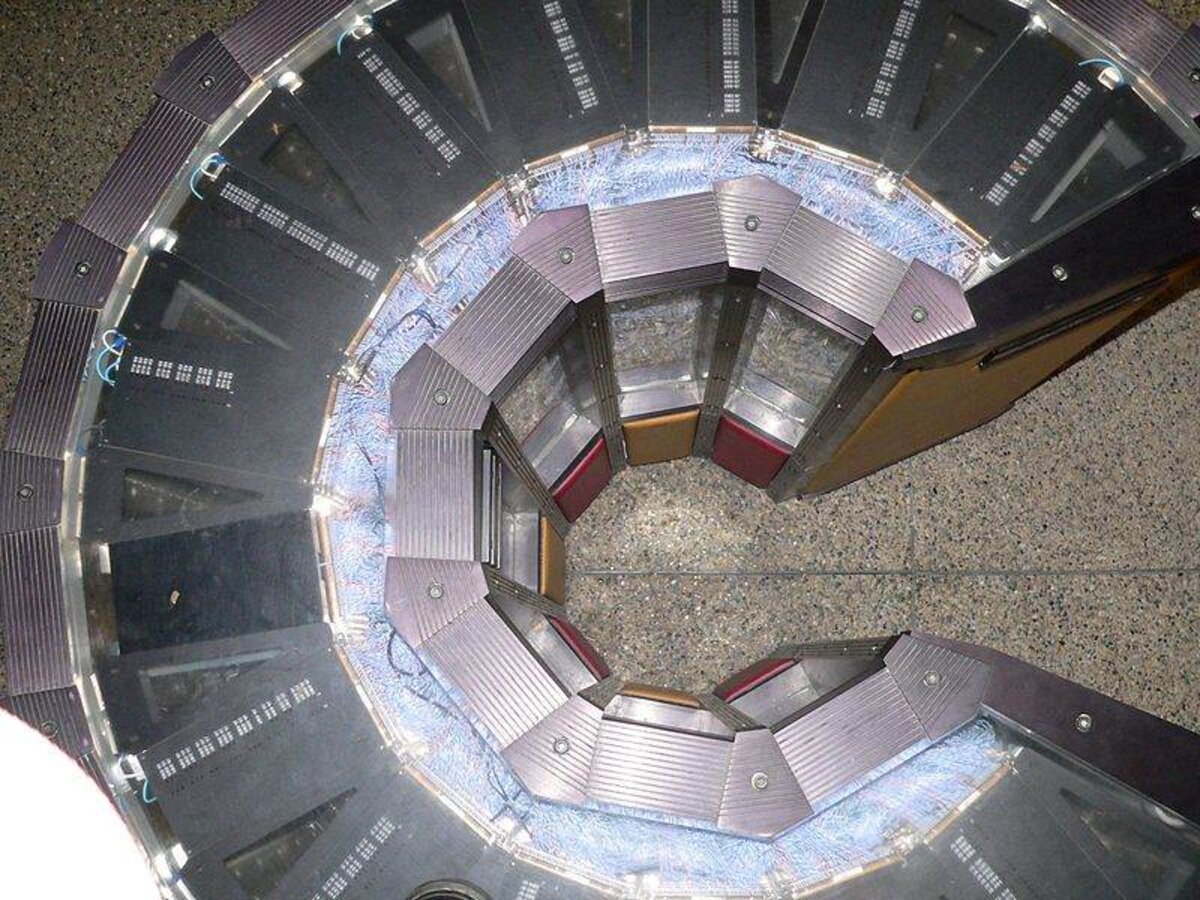

Agrandissement : Illustration 1

L’un des obstacles auxquels se heurte le développement des ordinateurs est le « mur de la chaleur » : les circuits de plus en plus miniaturisés et concentrés dans un espace restreint, rayonnent une énergie thermique qu’il faut évacuer, faute de quoi la machine tombe en panne. Le cerveau humain effectue des opérations d’une extrême complexité tout en se maintenant à la température du corps, sans avoir besoin d’un ventilateur, par sa seule capacité naturelle de régulation thermique. Le cerveau électronique, lui, s’échauffe en permanence et sa température s’élèverait excessivement sans le secours d’un dispositif de refroidissement.

Le problème n’est pas nouveau : le premier ordinateur, l’Eniac, construit à la fin de la deuxième guerre mondiale, pesait trente tonnes, et utilisait près de 18.000 tubes à vide, qu’il fallait refroidir avec une rangée de ventilateurs. Le recours au silicium, puis à la technologie CMOS dans les années 1990, ont réduit la quantité d’énergie thermique dissipée par les circuits intégrés.

Mais même si, individuellement, les circuits produisent moins de chaleur, leur miniaturisation et leur densité croissantes entraîne un échauffement de plus en plus important. Selon un article de Philip Ball dans la revue britannique Nature (lien payant), le flux de chaleur produit aujourd’hui par l’ensemble des microprocesseurs en fonctionnement est grosso modo comparable à celui qui circule à la surface du Soleil !

Le ventilateur d’un ordinateur de bureau permet de maintenir la température intérieure des circuits aux alentours de 75° C, faute de quoi elle grimperait rapidement et ferait griller les processeurs. Le « SuperMUC » d’IBM, l’un des ordinateurs les plus puissants du monde, installé au centre de calcul Leibniz, à Garching, près de Munich, possède des circuits de refroidissement par fluide caloporteur, en l’occurrence de l’eau à 45°C qui permet de chauffer une partie du bâtiment et d’économiser de l’énergie.

Pour les superordinateurs, le recours à un refroidissement liquide est imposé par des contraintes physiques, explique dans Nature Bruno Michel, du centre de recherches d’IBM à Rüschlikon, près de Zurich : « Un superordinateur de pointe nécessiterait plusieurs kilomètres cube d’air par jour pour être refroidi ».

Les chercheurs d’IBM projettent d’utiliser l’eau non seulement pour extraire la chaleur, mais aussi pour fournir de l’énergie aux circuits, par l’intermédiaire d’ions dissous dans le liquide. Ces ions peuvent avoir des réactions électrochimiques au niveau d’électrodes spéciales. Dans un tel système, le liquide refroidisseur joue en même temps le rôle d’électrolyte, qui fournit du courant électrique aux circuits de l’ordinateur.

Toutefois, ce type de procédé n’a pas permis jusqu’ici de résoudre le problème de la chaleur des circuits électroniques, qui vient principalement de la résistance des câblages qui transportent le signal d’un processeur à un autre. Autrement dit, même si l'on découvre des composants qui chauffent moins, on se heurtera encore au problème du transport du signal, qui est responsable de plus des neuf dixièmes de l’énergie dissipée. Certes, on pourrait aussi améliorer les câblages, mais on n'a pas encore trouvé de matériau commodément utilisable qui puisse transporter le courant sans résistance à une température ordinaire.

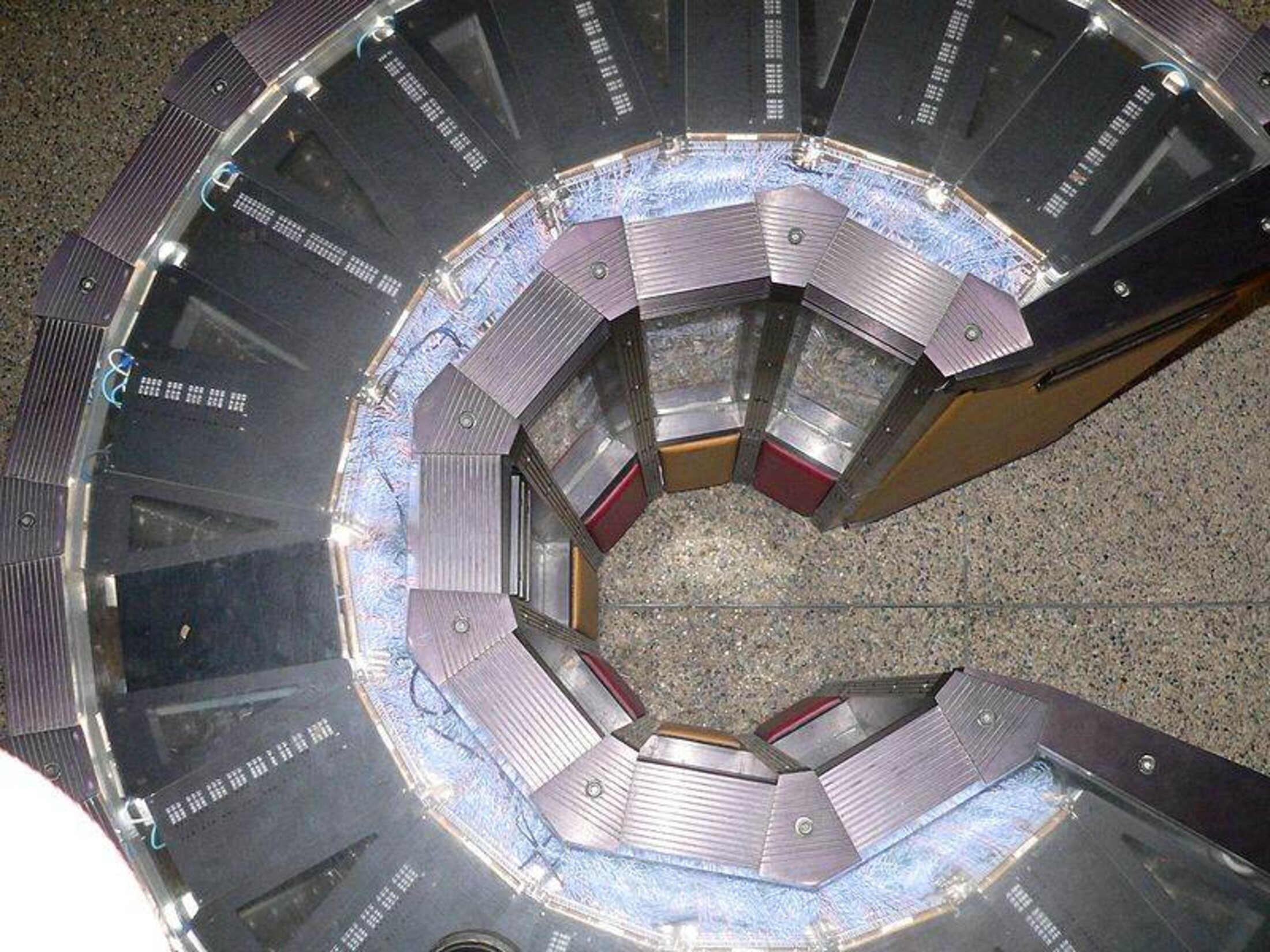

Agrandissement : Illustration 2

A moins qu'on ne mette au point un tel matériau, la seule possibilité qui reste est de réduire la distance entre les circuits. Une solution possible consisterait à construire des puces en trois dimensions, et non en deux dimensions comme aujourd’hui.

Avec une architecture adaptée, une puce en trois dimensions permettrait de réduire considérablement les distances entre les composants. Ce qui rendrait la puce à la fois plus rapide, car le signal aurait moins de distance à parcourir, et moins productrice de chaleur, puisqu’il y aurait moins de câblage.

Pour développer de telle puces, Bruno Michel estime qu’il faudra s’inspirer du cerveau humain, qui est extraordinairement performant comparé aux ordinateurs. Notre cerveau consomme environ 20% de l’énergie totale du corps, alors qu’il représente 2% de son volume. Mais il est beaucoup plus sobre que les machines électroniques : il est capable d’accomplir 100.000 à un million de fois plus de calculs par unité d’énergie consommée qu’un ordinateur. Cette efficacité est, au moins en partie, due à l’architecture des neurones, qui est en trois dimensions, et non en deux comme dans les puces actuelles.

Autre comparaison frappante : dans un ordinateur, jusqu’à 96% du volume de la machine sert à transporter la chaleur, 1% à transporter l’information, et seulement un millionième de pourcent du volume total est occupé par les circuits logiques qui effectuent les opérations. Dans le cerveau humain, 10% du volume servent au transport d’énergie thermique, 70% à la communication et 20% au calcul logique. Qui plus est, dans le cerveau, les neuronnes contenant des données mémorisées et ceux qui « calculent » sont proches les uns des autres, alors que dans un ordinateur la mémoire et le calcul sont séparés.

Les chercheurs en informatique peuvent donc espérer de grands progrès en s’inspirant de la nature. Le « mur de la chaleur » n’est pas une simple contrainte physique, il illustre l’avance que la biologie conserve sur la technologie. SuperMUC a une puissance de 3 pétaflops, c’est-à-dire qu’il peut effectuer 3 millions de milliards d’opérations par seconde. C’est beaucoup, mais pas assez pour surpasser le cerveau humain. Les informaticiens visent la barre du zetaflop (10 puissance 21, soit 1000 milliards de milliards d’opérations par seconde). Mais avec les architectures actuelles, une machine de cette puissance aurait la taille de l’Everest et consommerait plus d’énergie que la planète entière aujourd’hui.

L’équipe de Bruno Michel estime pourtant possible que des ordinateurs puissent égaler le cerveau – en efficacité, sinon en capacité – d’ici 2060. Mais pour réaliser ce pronostic, il faudra garder la tête froide.