Agrandissement : Illustration 1

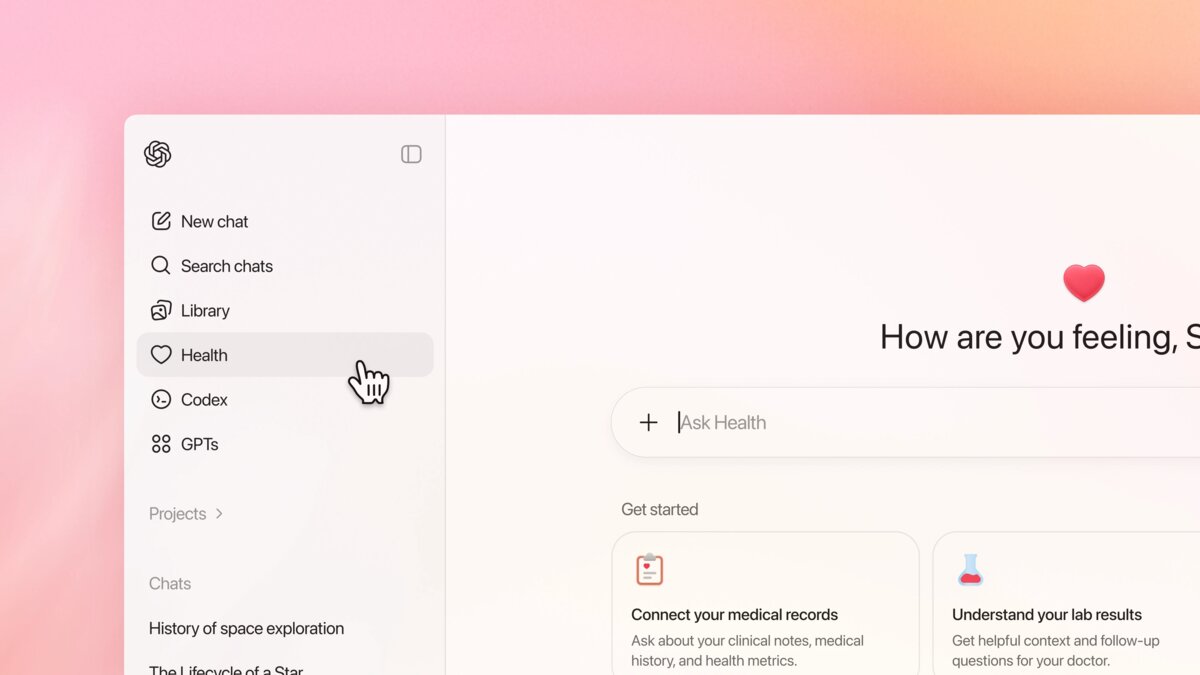

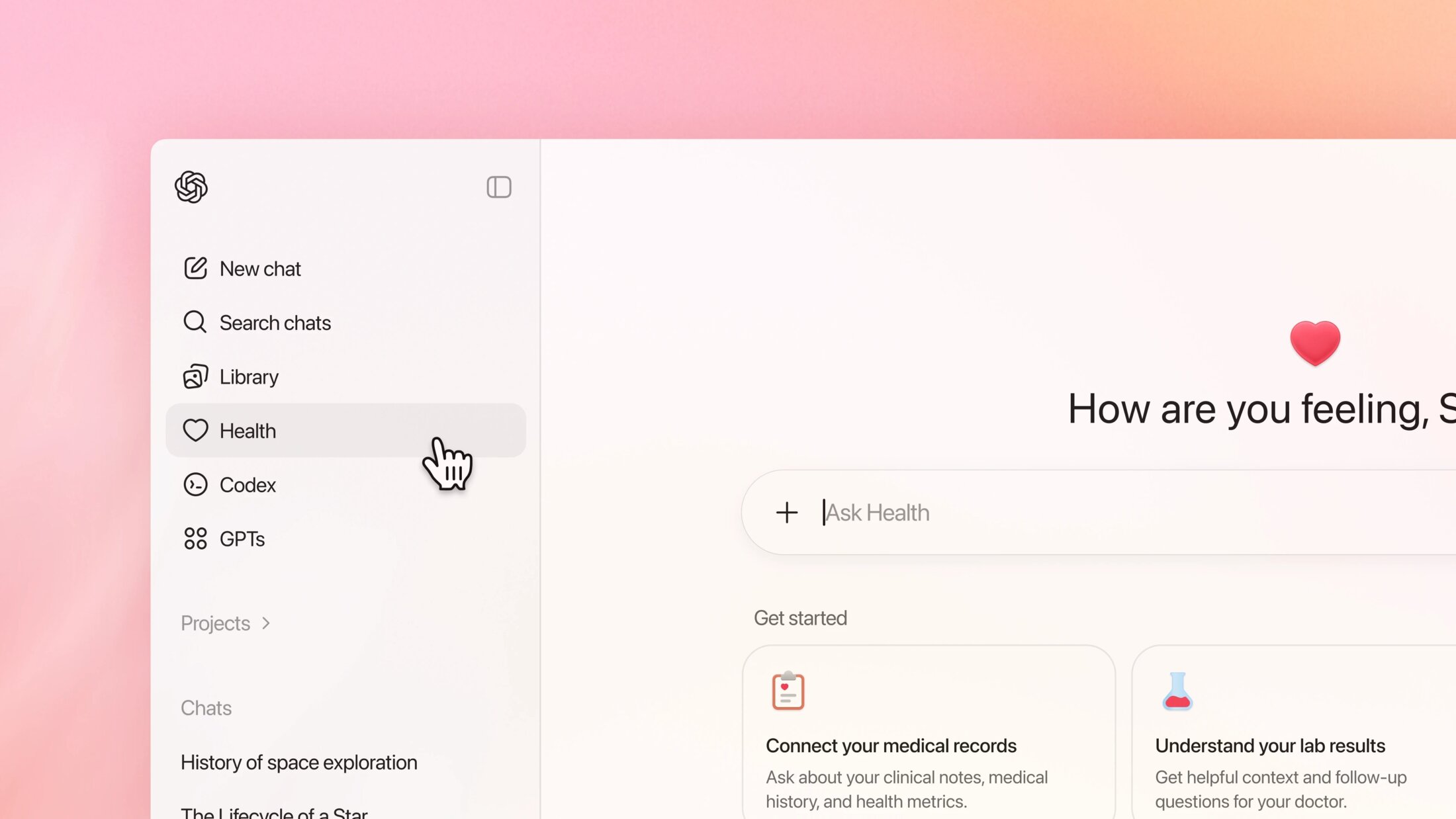

L'appétit d'OpenAI pour nos données personnelles semble insatiable et ne connaît désormais plus de limites, pas même celles de notre intégrité physique. Hier, l'entreprise a dévoilé ChatGPT Santé, un nouveau segment de son chatbot dédié à la santé. Sous couvert d'aider les utilisateurs à comprendre des résultats d'analyse ou à préparer des rendez-vous médicaux, elle tente de s'immiscer au cœur de la relation patient-médecin, un domaine où l'erreur de calcul ne se solde pas par une phrase maladroite, mais par des conséquences potentiellement vitales.

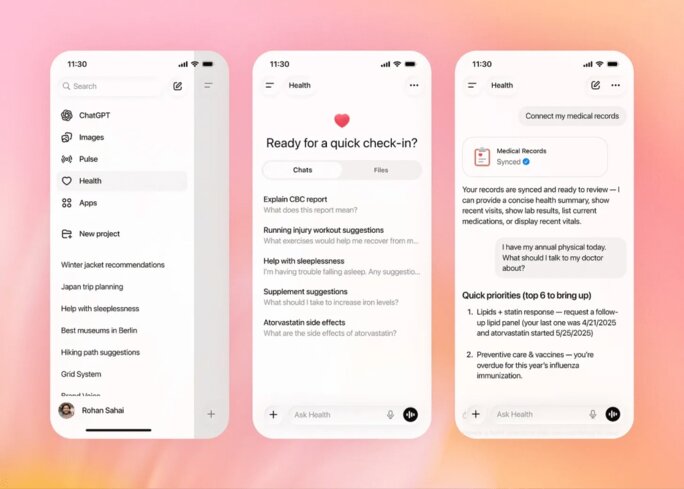

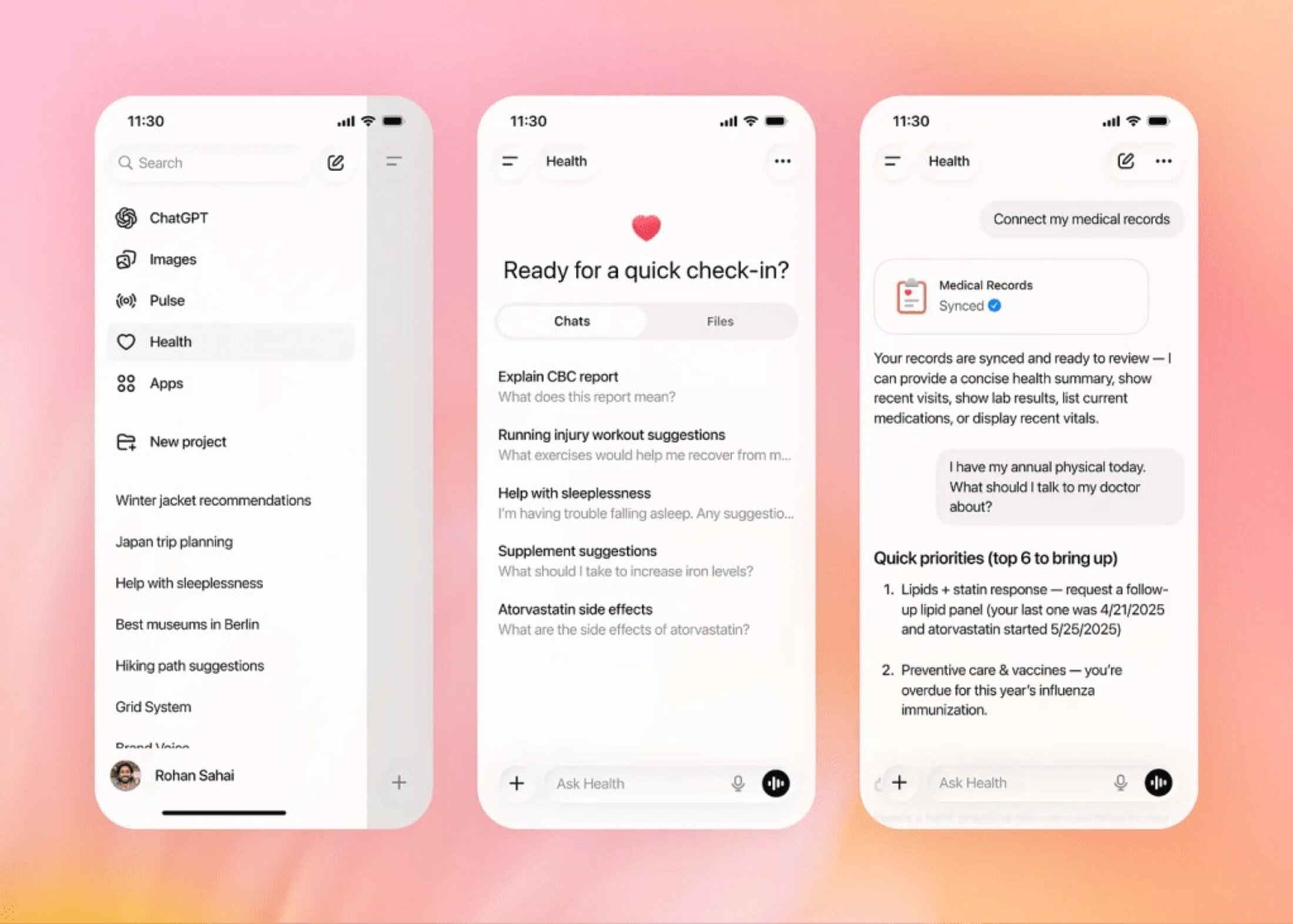

La promesse est séduisante sur le papier. Une IA capable de se connecter à vos dossiers médicaux, vos applications de bien-être et vos appareils connectés. Mais regardons la réalité en face. OpenAI vous invite à connecter Apple Santé à son système. L'objectif affiché est de vous fournir des conseils nutritionnels ou des listes de courses basées sur un régime généré par l'IA. Le but réel ressemble davantage à une collecte massive de données comportementales et biologiques.

L'entreprise affirme avoir travaillé avec plus de 260 médecins, mais cela ne change pas la nature fondamentale du produit qui demeure être un modèle de langage probabiliste qui prédit le mot suivant, sans aucune compréhension réelle de la physiologie humaine. Le fait que cette fonctionnalité ne soit pas encore disponible en Union Européenne, en Suisse ou au Royaume-Uni est un aveu silencieux mais assourdissant. Nous disposons de lois strictes sur la confidentialité numérique (RGPD).

Agrandissement : Illustration 2

OpenAI tente de rassurer en parlant de “chiffrement sur mesure” et de mémoires séparées. Les conversations dans le module Santé ne seraient prétendument pas utilisées pour entraîner les modèles de base. L'étanchéité de cette cloison est pourtant à sens unique. S’il est censé être isolé, il peut néanmoins accéder aux informations glanées dans vos conversations “standards”. Si vous mentionnez être un coureur dans le chat principal, le module le saura. Cette porosité soulève des questions inquiétantes sur le profilage des utilisateurs.

De plus, l'historique de l’entreprise américaine en matière de sécurité est loin d'être immaculé. On se souvient des failles de conception ayant rendu publics des historiques de conversation. Confier des données aussi sensibles que des dossiers médicaux à une entité qui a peiné à sécuriser de simples requêtes textuelles relève de l'imprudence, voire de la naïveté.

Le danger le plus pressant reste la fiabilité. Les LLM sont connus pour leurs hallucinations, inventant des faits avec une assurance déconcertante. Dans le domaine médical, une hallucination n'est pas un bug amusant, c'est un danger public. OpenAI se protège derrière des conditions d'utilisation stipulant que l'outil n'est pas destiné au diagnostic ou au traitement. C'est une hypocrisie flagrante, on construit une technologie conçue spécifiquement pour analyser des symptômes et des données médicales, tout en se lavant les mains des conséquences juridiques si l'utilisateur suit les conseils prodigués.

Cette stratégie de déresponsabilisation est d'autant plus choquante que ChatGPT a déjà été impliqué dans des incidents dramatiques, accusé d'avoir exacerbé des crises de santé mentale, parfois avec une issue fatale, faute de garde-fous adéquats. Pourtant, l'industrie semble fermer les yeux, encouragée par un vent de dérégulation, illustré par la volonté de l’institution américaine chargée de la surveillance des denrées alimentaires et des médicaments d'appliquer une touche légère tant que les produits ne se prétendent pas de qualité médicale.

En fin de compte, le lancement de ChatGPT Santé, piloté par des recrutements de haut vol comme Fidji Simo et des partenariats calculés, ne vise pas à soigner le monde, mais à dominer un marché lucratif. En incitant 40 millions d'utilisateurs quotidiens à déverser leurs angoisses médicales dans une boîte noire algorithmique, OpenAI joue aux apprentis sorciers. La technologie est impressionnante, mais l'éthique est restée au vestiaire. Nous ne sommes pas des patients pour l’entreprise, nous sommes des points de données dans leur prochaine grande conquête financière.