La version originale et complète de notre article que nous éditons ici sous forme condensée est parue dans la revue Zilsel. Science, technique et société, no. 8, 2021, p. 144-174.

L’évaluation de la recherche est aujourd’hui caractérisée par le recours de plus en plus systématique à des méthodes quantitatives, s’appuyant surtout sur la mesure du nombre de publications et de citations reçues par les chercheurs.

Ces méthodes reposent sur l’usage d’indicateurs bibliométriques souvent mal construits ou mal utilisés (Gingras, 2014), tels que « l’indice h » et les « facteurs d’impacts » des revues. Elles ont été accueillies avec enthousiasme par certains chercheurs et gestionnaires qui croient en leur plus grande « objectivité ». La plupart des chercheurs en début de carrière les considèrent désormais comme faisant partie des « règles du jeu » académique (Nicholas et al., 2018, 2020).

Les critiques répétées envers ces évaluations de type comptable ont cependant eu quelques effets, puisque certains organismes de recherche interdisent désormais l’usage par les comités d’évaluation des indicateurs les plus simplistes, comme le facteur d’impact des revues et « l’indice h » des chercheurs, et insistent plutôt sur l’analyse de la qualité des projets et des publications, en accord avec des déclarations internationales comme celle dite « de San Francisco » (Déclaration sur l’évaluation de la recherche, https://sfdora.org/read/). La Chine, par exemple, a finalement décidé d’abandonner ce système de primes, tant il a engendré de comportements déviants.

La controverse récente entourant le nombre de publications jugé anormalement élevé du Dr. Didier Raoult (Gingras et Khelfaoui, 2020), et l’attention médiatique portée au financement de son Institut, a eu pour conséquence de faire remonter à la surface les effets indésirables d’un système de financement de la recherche implanté dans les établissements de soins français en 2008, le Système d’Interrogation, de Gestion et d’Analyse des Publications Scientifiques.

Plus connu sous l’acronyme de SIGAPS, ce système inconnu du grand public (avec très peu de références dans la presse française) a été développé au Centre hospitalier universitaire (CHU) de Lille en 2002. En 2006, le ministère de la Santé lui a confié pour mission de l’implanter dans 70 autres institutions hospitalières. En 2016, 116 institutions de santé de différents types, dont les CHU, d’autres centres hospitaliers, des Centres de lutte contre le cancer, des établissements privés à but non lucratif, étaient inclus dans le système.

L’adoption de SIGAPS par le ministère de la Santé visait notamment à accompagner la réforme des modalités de financement des missions d’enseignement, de recherche, de référence et d’innovation (MERRI), adoptée en 2007. Cette réforme divisait le financement de l’enseignement et de la recherche médicale en trois parts : une part fixe, une part variable et une part modulable dans laquelle fut inclus un financement fondé sur les données générées par SIGAPS. Alors que les budgets de recherche, pour les CHU notamment, étaient auparavant alloués sur une base forfaitaire et proportionnelle à la taille de l’établissement, l’instauration du nouveau système SIGAPS a profondément changé la donne, en introduisant un financement basé sur la « performance », modèle qualifié par certains chercheurs de « tarification à l’acte bibliométrique » (Mancini et. al., 2009).

Le déploiement du système SIGAPS à l’échelle nationale s’est accompagné d’une transformation importante de son utilisation et de sa finalité.

D’outil de cartographie, de gestion et d’analyse des publications à l’échelle des établissements, il a été transformé en outil de gestion administrative de l’enveloppe budgétaire dédiée à la recherche et la formation.

Le financement de la recherche étant de plus en plus lié à des critères quantitatifs de « performance », SIGAPS est, de fait, également devenu indirectement un système d’évaluation des chercheurs et des institutions, car les budgets SIGAPS alloués dépendent de la cotation des articles signés par des chercheurs.

Le signe le plus visible du glissement de l’outil vers l’évaluation individuelle des chercheurs universitaires, qui sera documenté plus loin dans l’article, est que plusieurs CHU ainsi que des sections médicales du Conseil National des Universités utilisent désormais les données de publication individuelles compilées par SIGAPS dans les processus d’embauche ou de promotion des personnels hospitalo-universitaires.

L’objet de cet article est de mettre en évidence les effets pervers générés par un tel système.

Le système de financement SIGAPS

Le système de financement SIGAPS permet d’attribuer un score aux chercheurs et aux institutions hospitalières françaises en fonction de leurs publications savantes. Le nombre de points accordés est une fonction de la « qualité » de la revue où est parue la publication et de la position du chercheur sur la liste de ses co-auteurs. Les revues sont elles-mêmes classées (A, B, C, D, E, NC) sur la base de leur « facteur d’impact », un indicateur qui reflète le nombre de leurs citations. La sixième catégorie de revues, dite « NC » pour non classé comprend certaines revues indexées dans la base de données médicale PubMed, mais qui ne sont pas incluses dans la base de données Web of Science (WoS).

Le facteur d’impact constitue une moyenne qui caractérise la revue et non pas les articles eux-mêmes, lesquels peuvent être plus ou moins cités que la moyenne des articles de la revue. De plus, cette moyenne est calculée sur deux ans alors que l’impact des publications savantes se fait généralement sentir sur une durée de 5 à 6 ans en sciences médicales et de 7 à 8 ans en sciences naturelles et en ingénierie (Larivière et Sugimoto, 2018, p. 112).

La mesure retenue pour évaluer la « qualité » des publications dans le système SIGAPS n’est donc pas basée sur la publication elle-même, évaluée en termes de citations réellement obtenues, mais sur la notoriété de la revue dans laquelle l’article est publié. En fait, le facteur d’impact ne mesure que la probabilité qu’un article soit cité dans le futur, sachant la revue dans laquelle il est publié. Ainsi, un article paru dans une revue classée « C » peut s’avérer être plus cité qu’un autre paru dans une revue classée « B ».

Le problème posé par la classification disciplinaire des revues en fonction de leur facteur d’impact prend une ampleur supplémentaire dans le cas des revues à caractère multidisciplinaire.

En effet, le nombre de citations reçues par un article peut varier grandement en fonction des spécialités : une excellente revue associée à une spécialité où les chercheurs sont peu nombreux et les rythmes de publications lents aura nécessairement un facteur d’impact inférieur à une revue de même calibre, mais associée à une spécialité où les chercheurs sont beaucoup plus nombreux. Ce problème se règle normalement par la classification disciplinaire des revues, ce que fait SIGAPS, mais il demeure dans le cas des revues multidisciplinaires, qui sont associées à plusieurs spécialités.

Le classement global des revues est complété en attribuant, de manière arbitraire, un pointage à chaque catégorie : 8 points pour une revue classée « A », 6 points pour une revue classée « B », 4 points pour une revue classée « C », 3 points pour une revue classée « D », 2 points pour une revue classée « E » et 1 point pour une revue classée « NC ». En plus de la valeur attribuée à la revue et, par extension, à l’article, SIGAPS tient également compte de la position des chercheurs dans la liste des co-auteurs. Les manières de décider de l’ordre des noms varie beaucoup selon les disciplines (Pontille, 2016). Nous savons en effet que, dans le domaine des sciences biomédicales, les articles ont souvent un très grand nombre d’auteurs.

Dans le système le SIGAPS, défini pour les sciences biomédicales, il a ainsi été fixé qu’occuper la première ou la dernière position de la liste des co-auteurs d’un article vaut 4 points, la seconde position vaut 3 points, la troisième ou l’avant-dernière position valent 2 points, toute autre position valant 1 point. Même si l’ordre des noms peut faire consensus, il demeure que le simple fait de quantifier ces positions, risque de renforcer la course au « premier auteur » – le dernier étant le plus souvent le responsable du laboratoire – et donc les tensions, sinon les conflits ouverts, entre collaborateurs.

Le score SIGAPS final d’une publication est donc le produit de deux variables, l’une liée à la position de l’auteur et l’autre à la catégorie de la revue.

Pour donner un exemple simple, occuper la première ou la dernière position des co-auteurs d’un article publié dans une revue classée « A », comme Nature ou The Lancet, rapporte 4 points pour la position de l’auteur, multipliés par 8 points pour le classement de la revue, soit 32 points dans SIGAPS. Par contre, occuper la première ou la dernière position d’un article publié dans une revue à faible impact, classée dans la dernière catégorie dite « NC » (non classée), ne rapporte « que » 4 points (position de l’auteur) multipliés par 1 point (valeur de la revue), soit 4 points.

Les points accumulés par une institution sont alors la somme des points associés aux articles des chercheurs qui lui sont affiliés. Finalement, ces points sont ensuite convertis en valeur monétaire.

La valeur d’un point SIGAPS peut changer d’année en année. En 2017, par exemple, un point SIGAPS valait 648 euros. Un article dans une revue de catégorie « A » pouvait ainsi rapporter jusqu’à près de 21 000 euros en fonction de la position de l’auteur de cette institution sur la liste des co-auteurs, lesquels peuvent appartenir à différentes institutions. Une fois fixée, cette somme est versée, dans le cadre de la dotation MERRI du ministère de la Santé, à l’institution de rattachement du chercheur de façon récurrente durant quatre années consécutives, soit un total de 84 000 euros.

L’institution bénéficiaire peut ensuite utiliser cet argent pour mener sa politique de recherche: acheter des équipements ou financer des projets de recherche. Mais elle peut aussi décider, à sa discrétion, de reverser une partie de la somme reçue à ses laboratoires de recherche, au prorata de leurs contributions en points SIGAPS. Comme le rapporte une récente enquête du magazine l’Express (Garcia, 2020), certains établissements hospitaliers privés, qui sont de plus en plus nombreux à pouvoir bénéficier des financements SIGAPS, vont même jusqu’à les reverser directement à leurs médecins sous forme d’honoraires.

Les effets du système de financement SIGAPS

Analysons maintenant les effets prévisibles d’un tel système de financement de la recherche, qui est aussi de facto une forme d’évaluation, sur le comportement des chercheurs et des gestionnaires des institutions de recherche.

La multiplication des publications

Tout établissement de santé éligible au système SIGAPS a intérêt à « booster » son nombre de publications afin d’augmenter sa part de revenus dans l’enveloppe annuelle globale des MERRI actuellement fixée à 1.6 milliard d’euros, dont 60% sont distribués selon les données de SIGAPS.

L’effet de l’introduction de systèmes d’évaluation comptables sur l’augmentation de la production des chercheurs est connu et a déjà été documenté. Par exemple, l’Australie, qui avait introduit un tel système au début des années 1990, avait vu son nombre de publications augmenter de 25% en l’espace de quelques années seulement. Par contre, le gouvernement n’avait pas prévu ce qui était pourtant probable, à savoir que l’impact de ces nombreuses publications, mesuré en termes de citations relatives reçues, allait décliner, ce que des études bibliométriques ont d’ailleurs plus tard montré (Butler, 2003).

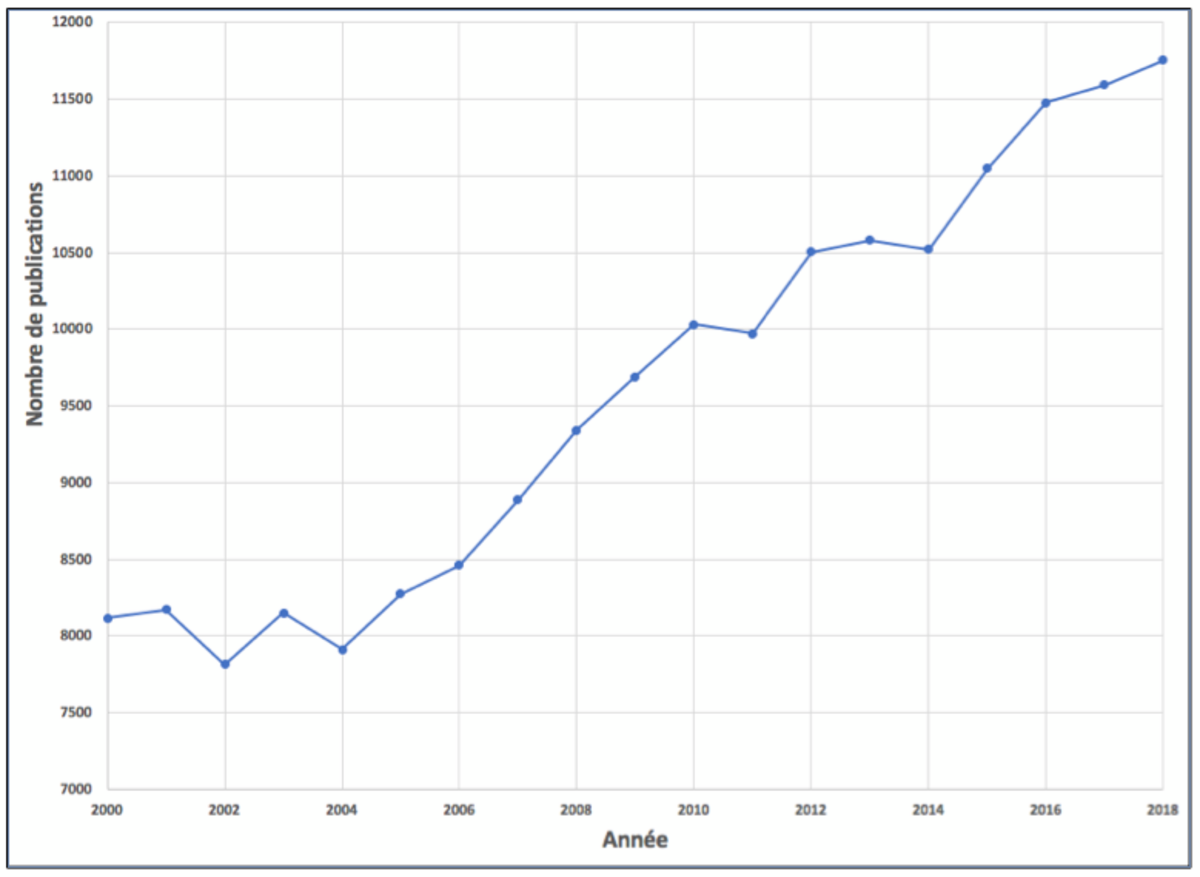

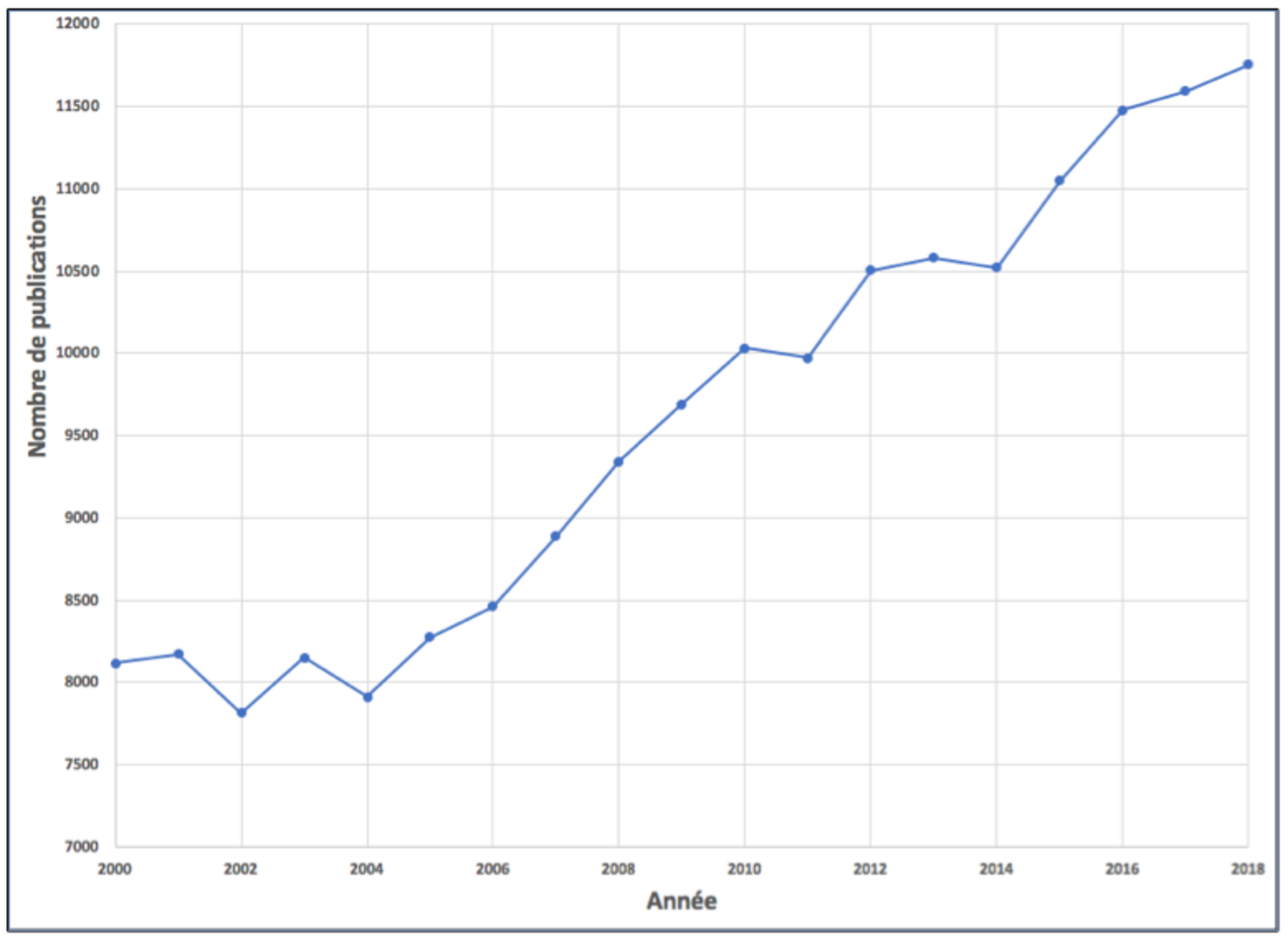

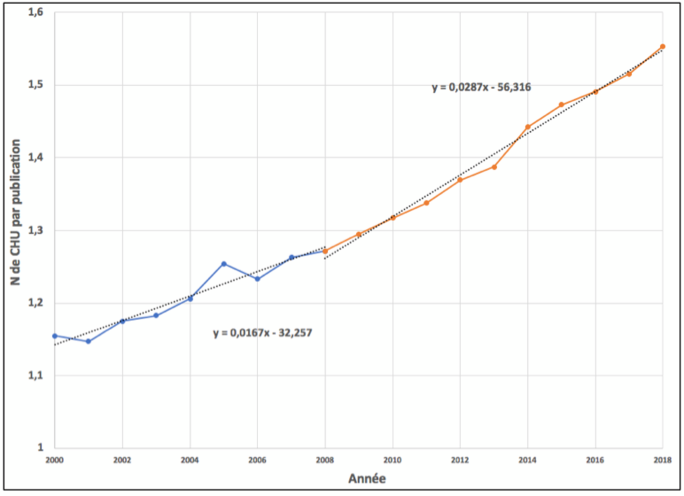

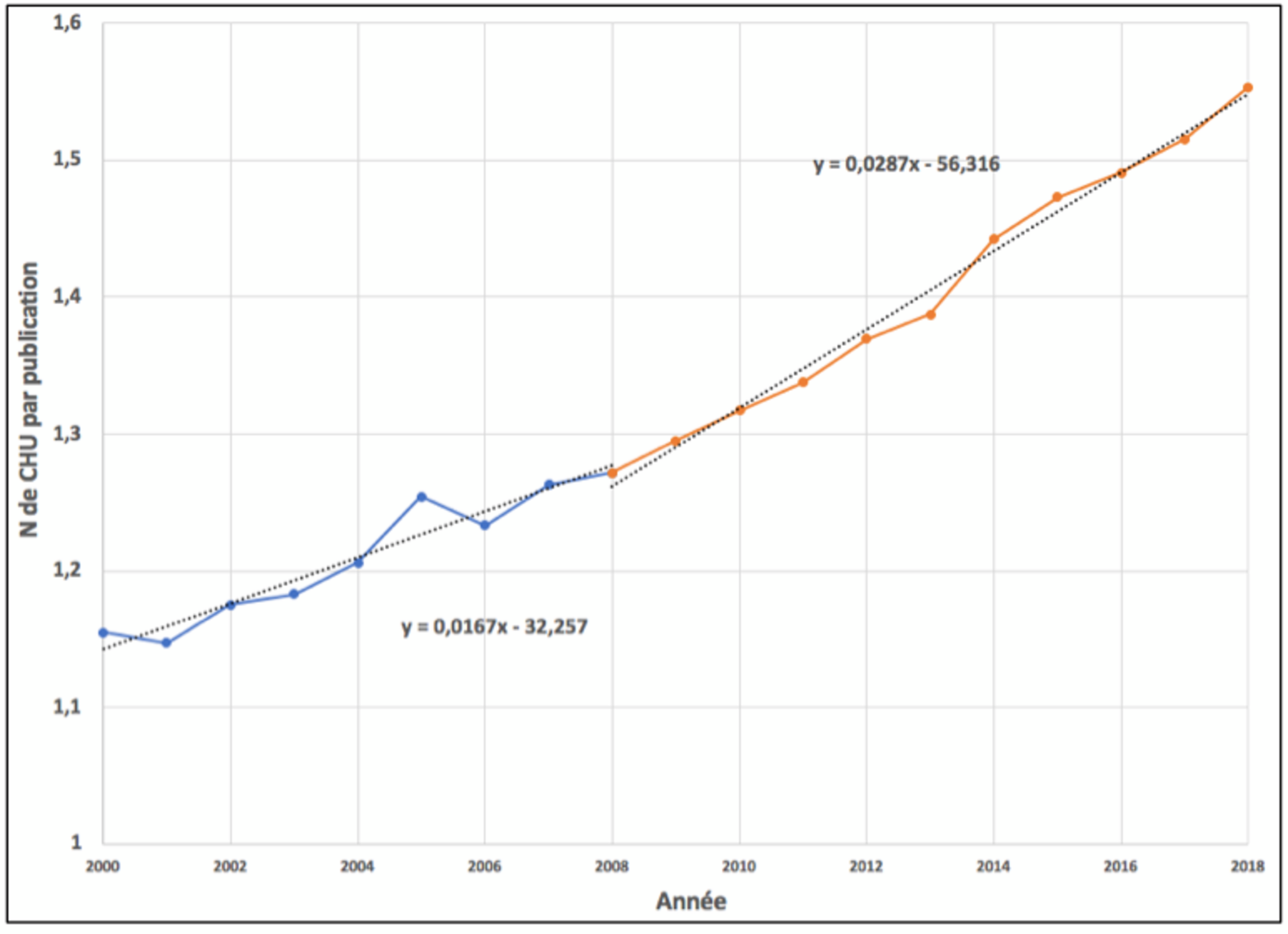

La Figure 1 montre l’évolution du nombre de publications en médecine clinique, sciences biomédicales et biologie des CHU (qui reçoivent 80% de l’enveloppe MERRI) entre 2000 et 2018, à l’exception de celles de catégories « NC » non indexées dans le WoS. De plus, un pourcentage non négligeable de chercheurs de CHU signe leurs articles en indiquant d’autres affiliations institutionnelles, une université ou l’INSERM par exemple.

Ces publications ne sont donc pas recensées comme des publications de CHU dans le WoS, alors qu’elles le sont dans SIGAPS, puisque les chercheurs valident personnellement leurs publications dans ce système et peuvent donc inclure même celles qu’ils ont signées avec d’autres adresses institutionnelles. Malgré ces limites, nos données suffisent pour observer l’effet de SIGAPS sur les publications : entre 2000 et 2018 on observe une augmentation de 45%. La croissance de l’ensemble des publications françaises dans les mêmes disciplines et pour la même période est de 47% et suit la même tendance.

La plupart des CHU ont cependant vu leurs publications augmenter de façon beaucoup plus importante. Par exemple, les CHU des grandes villes comme Toulouse, Bordeaux, Montpellier, Lyon, Lille ou Rennes ont au moins doublé leurs nombres de publications entre 2000 et 2018, tandis que l’Assistance Publique - Hôpitaux de Paris (AP-HP) et l’Assistance Publique - Hôpitaux de Marseille (AP-HM), les plus importants producteurs de publications, ont connu des croissances respectives moindres de 23% et 85%. La courbe montre bien que la croissance des publications des CHU s’accélère à partir de 2006, lorsque le système SIGAPS commence à se diffuser graduellement dans les CHU[1].

Agrandissement : Illustration 1

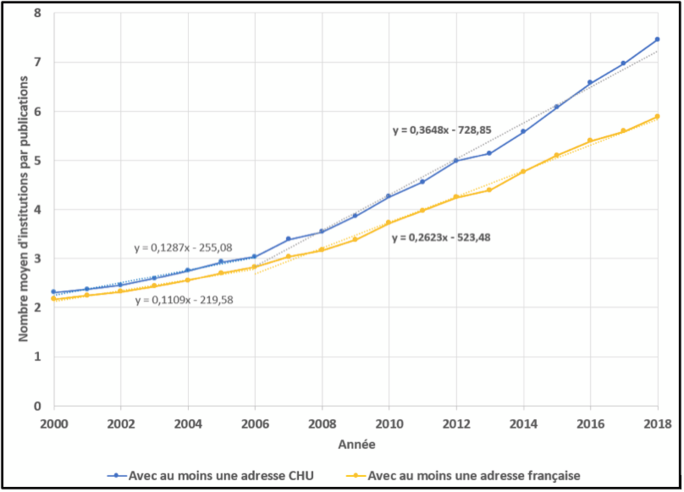

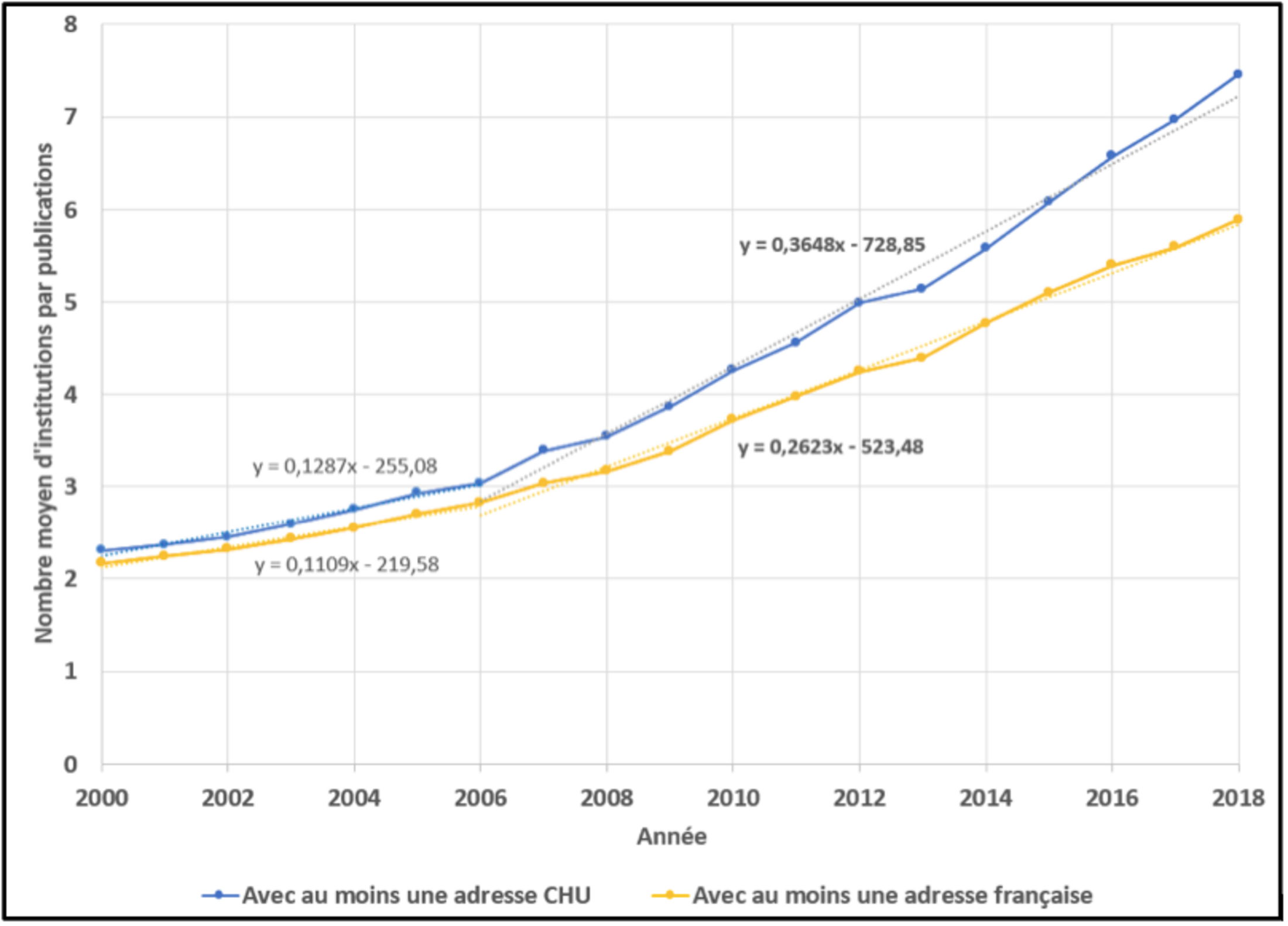

L’écart constaté entre la croissance globale du nombre de publications et la croissance des contributions individuelles de chaque CHU suggère que le nombre de publications des CHU en collaboration avec d’autres institutions, françaises ou étrangères, n’a cessé d’augmenter entre 2000 et 2018. Comme le montre la Figure 2, le nombre moyen d’institutions cosignataires de publications où figure au moins une adresse de CHU est passé de 2.31 en 2000 à 7.45 en 2018 (courbe bleue).

Sur la même période, l’ensemble des publications en biologie, médecine clinique et recherche biomédicale contenant au moins une adresse institutionnelle française, on voit que le nombre moyen d’institutions cosignataires est passé de 2.17 en 2000 à 5.90 en 2018 (courbe jaune). L’écart entre ces deux courbes se creuse plus rapidement depuis la mise en place du système SIGAPS. Cela va dans le sens de l’hypothèse d’un effet de ce système sur les pratiques de publication.

Agrandissement : Illustration 2

Les collaborations entre CHU n’ont pas cessé elles aussi d’augmenter depuis la mise en place du système. Cela est confirmé par l’évolution du nombre moyen de signatures d’établissements par publication, qui est passé de 1.15 à 1.55 entre 2000 et 2018. La Figure 2 montre bien que le taux de collaborations entre CHU s’est accéléré vers 2006, année du début de l’implantation de SIGAPS.

On ne peut bien sûr écarter l’idée que d’autres réformes appliquées à cette époque (comme les « Plan hôpital » de 2007 et 2012) aient pu également contribuer à ces changements.

Les collaborations sont l’occasion pour chaque participant éligible de produire davantage de publications qui lui permettront d’augmenter ou de maintenir son score SIGAPS. Cela confirme la suggestion de Fanelli (2020) voulant que la pression à publier soit plus visible dans la croissance des collaborations que dans le nombre d’articles produit par chaque auteur. C

ependant, l’enveloppe MERRI étant plafonnée, et les établissements éligibles hors CHU étant de plus en plus nombreux, il s’ensuit nécessairement « une baisse régulière de la part des CHU dans les scores SIGAPS » et ce, même quand leurs scores en valeur absolue continuent d’augmenter ou demeurent stables (Milon, 2018, p. 12). Comme l’enveloppe MERRI est plafonnée, pour maintenir leurs financements les CHU doivent compenser cette dilution par l’augmentation de leur nombre total de publications.

Agrandissement : Illustration 3

Les revues ne rapportant pas toutes le même nombre de points, on devrait s’attendre à des changements de stratégies de publication suite à la mise en place du système SIGAPS. C’est ce que l’on constate justement avec la revue multidisciplinaire en libre accès PLoS ONE, lancée en 2006.

On remarque que durant la période 2005-2009 cette revue est peu prisée par les chercheurs et se classe en 440e place avec seulement 22 publications. Cependant, dès la période suivante, 2010-2014, elle connaît une ascension fulgurante vers la première position avec 1487 publications et maintient ce rang au cours de la période 2015-2018 avec un total de 1222 publications.

Or, dans le cadre du système SIGAPS, publier dans PLoS ONE comporte un avantage stratégique, car elle est classée au rang « B » et peut donc rapporter un nombre de points élevé (jusqu’à 24 points pour une position de premier ou de dernier auteur). Un autre avantage de cette revue est que son taux d’acceptation d’environ 70% est très élevé. Cela s’explique par la politique de la revue qui privilégie la validité des résultats, plutôt que leur originalité.

Si l’on raisonne dans les termes purement comptables de SIGAPS, il devient donc plus intéressant pour un chercheur de publier un article dans PLoS ONE, plutôt que dans une revue disciplinaire de même rang, voire même de rang inférieur, mais qui applique des critères de sélectivité plus élevés.

Par exemple, publier un article en oncologie dans PLoS ONE rapporte autant de points SIGAPS que publier le même article dans la revue European Journal of Cancer qui a un taux d’acceptation 5 fois inférieur (14%), et le publier dans la revue Journal of Oncology, plus sélective que PLoS ONE avec un taux d’acceptation de 31% mais classée « C », ne rapporte que 18 points. La montée des « méga-revues », en particulier PLoS ONE mais aussi Scientific Reports, comme lieu privilégié de publication des CHU avait déjà été notée par le rapport du Comité national de coordination de la recherche, qui indiquait également une croissance de 26% par année du nombre de publications de CHU dans des revues en accès libre, entre 2005 et 2014 (Baudoin et Devos, 2016, p. 15).

Le rapport du CNCR relevait également que « le recours plus fréquent des chercheurs aux revues nouvellement créées, souvent moins sélectives et plus faciles d’accès, entraine une augmentation de la part NC dans la répartition des revues par catégorie » (Baudoin et Devos, 2016, p. 17). Dans ce rapport, on observe, en effet, une croissance de la part des publications des CHU dans les revues classées « NC » de 7 à 11% entre 2005 et 2014. On note également une croissance de la part des publications et dans les revues classées « B », de 18 à 23% dans la même période.

Par ailleurs, de 2005 à 2014, la part des publications dans les revues classées « A » est restée stable autour de 19 %, tandis que la part des publications dans les revues classées « C » est passée de de 17 à 20%, et dans les revues classées « D » de 11 à 13%. Finalement, la part des publications dans les revues classées « E » a connu une baisse importante de 30 à 14%.

Cette baisse s’explique notamment par la chute du nombre de publications en langue française des CHU. En effet, une grande partie des revues médicales françaises sont classées « E », étant donné leur faible visibilité internationale.

Le système SIGAPS a donc pour effet de précipiter le déclin des revues médicales françaises à caractère national, alors que le rapport du CNCR note pourtant que celles-ci « servent régulièrement de terrain d’entraînement aux premières publications des jeunes médecins, en même temps qu’elles constituent une source importante de la mise à jour des connaissances des soignants en France » (Baudoin et Devos, 2016, p. 14).

Une autre revue ayant attiré notre attention est Oncotarget, qui, avec 274 articles, arrive à la 9e position des revues dans lesquelles les CHU ont le plus publié dans la période 2015-2018. Cette revue, également en libre accès, a été créée en 2010 par un éditeur obscur, Rapamycin Press. Dès 2015, elle a été classée sur la célèbre liste des revues dites « prédatrices » établie par le bibliothécaire américain Jeffrey Beall (2012, 2017). En 2018, Clarivate Analytics, la compagnie qui produit les facteurs d’impacts des revues indexées dans le WoS, a décidé de désindexer la revue de sa base de données. Bien que les raisons justifiant ce retrait n’aient pas été clairement explicitées par Clarivate Analytics, ce genre de mesure est généralement pris à l’encontre des revues qui se rendent coupables de cas de fraudes ou d’autres pratiques contraires à l’éthique scientifique, comme des taux d’autocitations élevées (citation stacking) qui visent à « booster » la valeur du facteur d’impact de la revue.

Le médecin français Hervé Maisonneuve a par ailleurs noté l’impressionnant rythme de publication de la revue, qui avoisinait en 2017 les deux numéros par semaine (soit près de 7400 articles selon nos calculs), ce qui n’est jamais un gage de qualité.[2]

Le retrait de Oncotarget de la base du WoS signifie que celle-ci n’a désormais plus de facteur d’impact qui permette au système SIGAPS de la classer. Le dernier facteur d’impact calculé par Clarivate Analytics pour cette revue en 2016 était de 5.168, ce qui la classait au rang « B ». Une publication en tant que premier auteur y rapportait donc 24 points, soit 15.500 euros versés à l’institution de rattachement du chercheur durant quatre années consécutives.

L’exemple de la revue Oncotarget montre qu’une revue bien classée dans SIGAPS n’est pas nécessairement une revue de qualité selon les standards scientifiques. Elle montre également les limites d’un système qui permet d’octroyer plus de 60.000 euros à une institution, pour la « récompenser » d’une publication dans une revue de qualité douteuse.

Les fluctuations du facteur d’impact

Le rang attribué à chaque revue est fondé sur le facteur d’impact de la revue. Or, comme l’a démontré une récente étude bibliométrique (Antonoyiannakis, 2020), les valeurs des facteurs d’impacts des revues sont très volatiles : en 2017, 10% de 11639 revues indexées dans le WoS devaient 50% de la valeur de leur facteur d’impact uniquement à leurs trois publications les plus citées.

Ceci prouve que le facteur d’impact d’une revue ne reflète pas la qualité de l’ensemble de ses publications, mais est déterminé en grande partie par un faible nombre de publications qui reçoivent l’essentiel des citations de la revue et qui peuvent grandement faire varier la valeur du facteur d’impact d’une année à l’autre.

Sur les 258 revues qui définissent la spécialité « oncologie » dans SIGAPS, 126 revues, soit 53%, ont changé au moins une fois de rang entre 2014 et 2018, parmi lesquelles 10 revues ont changé de deux rangs.

Ces changements sont souvent associés à des variations très faibles des facteurs d’impact des revues d’une année à l’autre, variations parfois inférieures à 5%. C’est le cas, par exemple, de Bone Marrow and Transplantation Research qui est passée du rang « B » au rang « C » entre 2017 et 2018, pour une variation de son facteur d’impact de 4.497 à 4.674.

Or, il devrait être évident que cette variation infime n’est qu’un effet statistique aléatoire et nullement le signe d’une modification tendancielle de la « qualité » de la revue. Ces fluctuations reflètent aussi la fausse précision d’un indicateur curieusement calculé avec trois chiffres significatifs, ce que très peu de mesures en sciences biomédicales peuvent atteindre.

Nonobstant ces problèmes de fluctuation, il faut rappeler que l’utilisation du facteur d’impact des revues pour évaluer les publications des chercheurs constitue une erreur de méthode, car cet indicateur ne caractérise pas directement l’article, mais bien la revue.

Ainsi le système SIGAPS n’évalue pas la qualité réelle de chacune des publications des chercheurs, mais s’appuie uniquement sur la visibilité moyenne des revues dans lesquelles elles sont publiées.

Or, les distributions des citations aux revues, tout comme d’ailleurs celles des publications des chercheurs et des octrois de recherche, suivent une courbe de type Pareto ou Lotka. Elles sont donc très concentrées, suivant à peu près la règle du 20/80 à l’effet que 80% des citations d’une revue proviennent de seulement 20% des articles qu’elle contient (Larivière et al., 2010).

Une conséquence de ce fait général est que le facteur d’impact d’une revue, qui est une valeur moyenne, surestime le nombre réel de citations des articles des chercheurs dans cette revue. Surtout, il pénalise ceux dont les citations réelles reçues, et donc l’impact scientifique, sont largement supérieures à cette moyenne.

La question se pose donc : pourquoi prendre le facteur d’impact de la revue et non pas les citations réelles obtenues par les articles ?

La réponse est simple : mesurer l’impact réel des publications nécessite d’attendre qu’elles soient citées pendant 3 ou 4 ans, alors que le facteur d’impact calculé chaque année permet une évaluation immédiate, au principe qu’une publication dans une revue bien classée a une plus grande probabilité d’être citée qu’un article publié dans une revue moins bien classée.

On évalue donc indirectement les chercheurs non pas sur l’impact effectif, mais sur l’impact présumé de leurs publications, ce qui est problématique au plan éthique quand on sait qu’en vertu de la loi de Lotka, les citations réelles obtenues par une publication dans une revue bien classée peuvent en fait être inférieures à celles reçues par article paru dans une revue moins bien classée dans SIGAPS.

La langue de publication

Le système SIGAPS a eu un effet majeur sur l’évolution du nombre de publications en langue française des CHU au cours des 20 dernières années.

On sait que, dans toutes les disciplines, la tendance à publier en anglais s’est accentuée depuis les années 1970 (Gingras, 1984, 2008), mais SIGAPS semble avoir accéléré cette tendance dans la recherche médicale française en milieu hospitalier, dont les revues médicales de langue françaises sont pourtant un lieu de publication privilégié.

En effet, après être demeurée relativement stable entre 25 et 30% de 2000 à 2008, la part des publications de langue française des CHU a rapidement chuté par la suite pour atteindre 9% en 2018. Ce phénomène s’explique par le simple fait que la plupart des revues médicales ou biomédicales francophones, bénéficiant de peu de visibilité internationale, ont un facteur d’impact faible et sont donc le plus souvent classées dans les catégories « E » ou « D » par SIGAPS.

Cela pousse naturellement les chercheurs des CHU à privilégier les revues de langue anglaise qui monopolisent les catégories supérieures de SIGAPS. Une étude menée sur les données de publications du CHU de Rouen, entre 2007 et 2010, concluait d’ailleurs que « plus les auteurs sont prolifiques (score SIGAPS élevé), moins ils ont tendance à publier en français » (Griffon et al., 2012).

Or, les données de téléchargements institutionnels d’articles au sein de l’AP-HP, le plus grand CHU de France, indiquaient que sur les 15 revues les plus consultées en 2010 par les chercheurs, les praticiens et les étudiants, 8 étaient de langue française. Un rapport de la Haute autorité de la santé (HAS) concluait à ce sujet que: « les auteurs d’articles scientifiques et de formation sont peu nombreux et s’orientent vers des publications en langue anglaise, tandis que la plupart des 200 000 médecins français ont besoin de publications en langue française pour s’informer et se former ». Il ajoutait que « la diminution des publications originales dans des revues françaises est un frein à la diffusion de l’information et de la connaissance médicales » (HAS, 2013, p. 28).

Choix des co-auteurs

Une autre façon d’accroitre la « productivité » d’un organisme de recherche est de lui adjoindre des chercheurs extérieurs sous forme de contrat spécifique.

Selon cette stratégie, les CHU et autres institutions éligibles ont largement augmenté leur volume de publications depuis la mise en place du système SIGAPS. En effet, un rapport de la Cour des comptes portant sur le rôle des CHU dans l’enseignement supérieur et la recherche médicale notait en 2018 que : « certains établissements de santé contournent le modèle en salariant pour quelques vacations, parfois une seule, des praticiens attachés, par ailleurs auteurs de publications dans le cadre de l’activité de recherche menée auprès de leur employeur principal […] L’indicateur obtenu de cette manière est déconnecté de l’établissement où se déroule effectivement la recherche en question » (Milon, 2018, p. 88). Moyennant rémunération, un établissement peut ainsi s’attacher les services d’un chercheur pour peu qu’il rajoute le nom du CHU aux papiers qu’il signe dans le cadre des recherches qu’il mène dans sa véritable institution de rattachement.

Le rapport de la Cour des comptes confirme d’ailleurs cela en soulignant que les CHU peuvent s’attribuer les publications « des chercheurs INSERM et CNRS qui disposent d’un contrat d’interface, à partir du moment où ceux-ci sont salariés de l’établissement de santé » (Milon, 2018, p. 88).

Les dérives du système SIGAPS

Un système d’évaluation de la recherche adossé à des indicateurs inadéquats, et associés à des octrois budgétaires, risque fort d’engendrer des comportements déviants et des manipulations.

On peut en effet se demander si la recherche scientifique garde son caractère éthique quand des chercheurs ou des laboratoires visent consciemment à publier un grand nombre d’articles dans des revues de faible qualité, afin d’accumuler rapidement des points, plutôt que de viser une seule publication originale et de grande qualité dans une revue plus sélective, démarche cependant plus longue et au succès plus aléatoire, au vu du fort taux de refus de ces revues. La critique du « publish or perish » est bien sûr ancienne, mais elle est exacerbée par les nouvelles méthodes d’évaluation.

Par exemple, le Dr Didier Raoult a beaucoup publié avec son équipe dans la revue New Microbes and New Infections contrôlée par des chercheurs de son institution (Gingras et Khelfaoui, 2020), et classée au plus bas dans SIGAPS (« NC »). On y retrouve 77 articles pour la seule année 2017, soit un rythme d’une publication tous les 5 jours environ.

Ces articles valent ainsi, selon SIGAPS, 308 points, soit près de 200 000 euros qui, versés durant 4 ans à l’AP-HM, rapporteront au total 800 000 euros à l’institution. Par comparaison, cela correspond au nombre de points que rapporterait la publication, en une seule année, de près de 10 articles dans des revues classées « A », comme Nature, Science, Journal of the American Medical Association ou The Lancet. Cela étant impossible, même pour les meilleurs chercheurs, on comprend facilement que la stratégie optimale est bien de multiplier les publications dans des revues qui publient rapidement n’importe quel résultat.

La Cour des comptes ne s’y est pas trompée en notant que : « L’indicateur SIGAPS n’apparait pas suffisamment discriminant vis-à-vis de la qualité des revues de publication […]. Cette situation peut conduire à un dévoiement du modèle par des pratiques contestables » (Milon, 2018, p. 89). D’ailleurs, dès 2008, une revue médicale à faible impact avait flairé le bon filon. L’un de ses éditoriaux affirmait ainsi qu’« un article publié dans notre revue peut donc rapporter entre cinq et deux points en fonction du rang de signataire de l’auteur : c’est donc bien le moment de publier dans les Annales de pathologie ! » (Sabourin et Darmoni, 2008).

Une autre dérive prévisible générée par SIGAPS est le fait que les CHU commencent à utiliser ce système pour évaluer individuellement leur personnel hospitalo-universitaire, en particulier dans les processus d’embauche et de promotion.

Ainsi, en 2016, le responsable de la Délégation à la Recherche Clinique et à l’Innovation du CHU de Clermont-Ferrand, Patrick Lacarin, indiquait que pour prétendre à la position de professeur des universités-praticien hospitalier (PU-PH) dans son institution, un chercheur devait avoir accumulé au moins 500 points SIGAPS lors des dix années précédentes, critère validé par une recommandation de la sous-section santé du CNU, Conseil National des Universités[3].

Le rapport de la Cour des comptes notait de son côté que : « l’université Paris-Sud procède à des auditions des PU-PH tous les cinq ans en prenant en compte pour la recherche le score SIGAPS » (Milon, 2018, p. 131). En 2016, le Collège national des universitaires de psychiatrie a également recommandé l’intégration de critères liés au score SIGAPS et à l’« indice h » dans les processus de nomination aux postes de PU-PH et de maître de conférence des universités-praticien hospitalier (MCU-PH) en psychiatrie adulte.[4] Ces cas sont loin d’être anecdotiques, puisqu’en 2016, un article de la revue Bulletin du Cancer présentait les critères minimaux, incluant les scores SIGAPS, requis par la sous-section cancérologie du CNU pour candidater aux postes de PU ou de MCU dans cette spécialité. Pour les postes de PU-PH, il fallait, au cours des 5 dernières années, avoir au moins 10 publications dans une revue à facteur d’impact supérieur à 3, dont 5 articles originaux en tant que premier, deuxième ou dernier auteur dans une revue à facteur d’impact élevé (supérieur à 5 pour l’oncologie médicale, à 4 pour l’oncologie radiothérapie, à 3 pour la chirurgie ou la biologie).

En plus de cela, les candidats devaient « démontrer une dynamique croissante de publications » et un score SIGAPS supérieur à 400 (Soria et al. 2016, p. 726). Des critères de nature semblable, mais avec des seuils minimaux inférieurs, étaient exigés pour les postes de MCU-PH.

En 2018, le CHU de Dijon est allé jusqu’à afficher sur son site le classement de ses chercheurs selon leurs scores SIGAPS accumulés durant la période 2013-2016.

En plus d’instaurer un climat de compétition malsain entre les chercheurs, le système SIGAPS crée également une fausse compétition au sein et entre les institutions hospitalières. Par exemple, le même CHU de Dijon a instauré depuis 2016, un système d’« intéressement » qui reverse 300 000 euros sur les sommes reçues par l’intermédiaire du financement SIGAPS à ses laboratoires, au prorata de leurs contributions en termes de points.[5]

Autre exemple de compétition induite entre institutions, une revue interne du CHU de Nantes notait en 2014 que : « pour rejoindre le score du CHU de Toulouse, il faudrait augmenter le nombre de publications de plus d’une centaine d’articles par an et augmenter également le taux de publications de rang A » (Brisson, 2014, p. 4). Ainsi, la politique de recherche des établissements est définie, en partie du moins, en fonction d’une course à l’accumulation de « points » qui visent à augmenter des « scores » qui ne disent eux-mêmes pas grand-chose de la qualité et de l’originalité réelle de la production scientifique des CHU.

Les points attribués étant liés à la position des auteurs dans la liste des cosignataires, on peut également prédire que des tensions et conflits seront générés entre collaborateurs par un tel système, surtout pour les jeunes chercheurs qui doivent cumuler des points pour pouvoir candidater sur des postes. Mais seuls des entretiens avec ces chercheurs pourraient confirmer cette hypothèse. La rapide intériorisation de ces normes, imposées sans débat collectif, s’observe déjà dans les CV des chercheurs qui indiquent non seulement le facteur d’impact des revues dans lesquelles ils ont publié, mais aussi leur score SIGAPS qui, contrairement au facteur d’impact, n’a d’existence qu’en France.

Conclusion : Éthique et dérive systémique

Au-delà du cas particulier du système SIGAPS, les partisans de l’application généralisée de l’évaluation bibliométrique aux chercheurs font généralement valoir que celle-ci constitue un critère de jugement impartial, qui élimine les dérives liées au clientélisme et au copinage. Or, force est de constater que l’instauration de ces méthodes d’évaluation basées sur des critères comptables supposément objectifs, loin de régler ces problèmes, peut en fait les amplifier, et même en créer de nouveaux, comme nous l’avons montré dans cette étude.

Par ailleurs, les problèmes générés par le logiciel SIGAPS évoqués récemment dans les médias français (Korda et Simon, 2020; Roy, 2020; Larousserie, 2020) semblent être analysés au seul prisme de l’éthique individuelle des chercheurs qui n’ont pourtant fait que s’adapter aux « règles du jeu ».

Un tel raisonnement fait oublier que les éventuels écarts individuels à l’éthique, qu’il ne s’agit pas ici de cautionner, ne sont en fait que le symptôme du fonctionnement même d’un système de financement de la recherche qui contient en lui les germes du problème. Pointer vers les dérives individuelles ne mettra malheureusement pas fin aux tentatives de certains chercheurs de détourner le système à leur profit, tant que celui-ci leur permettra de le faire en toute légalité.

On peut également se demander, en terminant, s’il est éthique d’évaluer des chercheurs, même de façon indirecte, sur la base d’un système aussi problématique. En effet, on peut penser qu’il est injuste d’évaluer des personnes sur la base d’indicateurs qui ne mesurent pas directement l’objet à évaluer. On peut aussi se questionner sur le caractère éthique d’un système qui amène, consciemment ou non, les chercheurs et les gestionnaires de la recherche à adapter leurs pratiques pour optimiser les points SIGAPS plutôt que la recherche de qualité. De ce point de vue, on peut trouver curieux que ce soit la Cour des comptes et non pas les chercheurs, leurs associations savantes ou les Conseils scientifiques de leurs établissements qui aient le mieux décrit les problèmes systémiques de ce système d’évaluation.

Enfin, il faut souligner que la pression engendrée par ce système comptable s’exerce sur de jeunes chercheurs qui n’ont d’autre choix que de se plier à ses exigences pour pouvoir ne serait-ce qu’espérer obtenir un poste. Ce faisant, ils se voient forcés de troquer l’objectif de produire des connaissances pour celui, bureaucratique, de produire des « unités comptables » (Gingras, 2018) au service des budgets de leurs centres de recherches et peut-être parfois de quelques primes à la « productivité » venant compenser de maigres salaires.

Bibliographie

Baudoin, L. et P. Devos. (2016). Analyse bibliométrique des publications des CHU, 2005-2014, Rapport du Comité national de coordination de la recherche, 40 p.

Beall, J. (2012). « Predatory Publishers are Corrupting Open Access », Nature, vol. 489, p. 179.

Beall, J. (2017). « What I learned from Predatory Publishers », BioechemiaMedica, vol. 27, no. 2, p. 273-279.

Butler, L. (2003). « Explaining Australia’s increased share of ISI publications—the effects of a funding formula based on publication counts», Research Policy, vol. 32, no. 1, p. 143-155.

Brisson, I. (2014). « Le CHU de Nantes dans le paysage SIGAPS national», R de recherche, no. 16, p. 3-5.

Fanelli, D. (2020). « Pressure to Publish: What Effects Do We See? », dans Biagioli et Lippman (dirs.), Gaming the Metrics. Misconduct and Manipulation in Academic Research, Cambridge (Mass.), MIT Press, p.111-122.

Garcia, V. (2020). « L’astuce du Pr. Raoult pour publier massivement des études et décrocher des financements », L’Express, 30 juin.

Gingras, Y. (1984). « La valeur d'une langue dans un champ scientifique », Recherches sociographiques, vol. 25, no. 2, p. 286-296.

Gingras, Y. (2008). « Les langues de la science: Le française et la diffusion de la connaissance », dans Jacques Mauret et al. (dirs.), L’avenir du français, Paris, Éditions des archives contemporaines, p. 95-97.

Gingras, Y. (2014). Les dérives de l’évaluation de la recherche. Du bon usage de la bibliométrie, Paris, Raisons d’Agir.

Gingras, Y. (2018). « Les transformations de la production du savoir: de l’unité de connaissance à l’unité comptable », Zilsel. Science, technique, société, vol. 2, no. 4, p. 139-152.

Gingras, Y. et M. Khelfaoui. (2020). « Être juge et partie, ou comment contrôler une revue scientifique », The Conversation, 26 juin.

https://theconversation.com/etre-juge-et-partie-ou-comment-controler-une-revue-scientifique-140595.

Griffon, N., Devos, P., Gehanno, J.-F., et J.S. Darmoni. (2012). « Existe-t-il une corrélation entre le score SIGAPS et les publications en français ? », La Presse Médicale, vol. 41, no. 9, p. e432-e435.

Larivière, V., Macaluso, B., Archambault, E., et Y. Gingras (2010). «Which scientific elites? On the concentration of research funds, publications and citations», Research Evaluation, vol. 19, no 1, pp. 45-53

Larivière, V. et C. Sugimoto. (2018). Mesurer la science, Montréal, Presses de l’Université de Montréal.

Larousserie, D. (2020). « ‘Lancetgate’ : publier beaucoup dans des revues scientifiques peut rapporter gros », Le Monde, 15 juin.

https://www.lemonde.fr/sciences/article/2020/06/15/lancetgate-publier-beaucoup-dans-des-revues-scientifiques-peut-rapporter-gros_6042952_1650684.html

Haute autorité de santé (2013). Bonnes pratiques et critères de qualité des revues et journaux de la presse médicale française, 237 p.

Korda, R. et C. Simon (2020). « Didier Raoult, une frénésie de publications et des pratiques en question », Le Parisien, 12 juin. https://www.leparisien.fr/societe/didier-raoult-une-frenesie-de-publications-et-des-pratiques-en-question-12-06-2020-8334405.php

Mancini, J., Darmoni, S., Chaudet, H. et M. Fieschi (2009). « Le paradoxe de la ‘T2A bibliométrique’ SIGAPS : un risque d’effet délétère sur la recherche française ? », Presse Médicale, vol. 38, no. 2, p. 174-176.

Milon, A. (2018). « Rapport d’information fait au nom de la commission des affaires sociales (1) sur l'enquête de la Cour des comptes relative au rôle des centres hospitaliers universitaires dans l’enseignement supérieur et la recherche médicale ». https://www.senat.fr/rap/r17-228/r17-2281.pdf

Nicholas, D., et. al. (2020). « Millenial researchers in a metric-driven scholarly world: An international study », Research Evaluation, vol. 29, no. 3, p. 263-274.

Nicholas, D., et. al. (2018). « Early Carerr Researcher’s Quest for reputation in the digital age », Journal of Scholarly Publishing, vol. 49, no. 4, p. 375-396.

Pontille, D. (2016). Signer ensemble. Contribution et évaluation en sciences, Paris, Economica.

Roy, S. (2020). « Revues scientifiques: quand publier rapporte des budgets derecherche », Le Figaro, 16 juin. https://www.lefigaro.fr/sciences/revues-scientifiques-quand-publier-rapporte-des-budgets-de-recherche-20200616

Sabourin, J.-C. et S. Darmoni (2008). « Avec le score SIGAPS : c’est le moment de publierdans les Annales de pathologie ! », Annales de Pathologie, vol. 78, no. 2, p. 77-78.

Soria, J.-C. et al. (2016). « Le Conseil national des universités en cancérologie-radiothérapie : missions et critères de sélection présentés aux lecteurs du Bulletin du Cancer », Bulletin du Cancer, vol. 103, no. 9, p. 719-729.

Notes

[1] Comme indiqué plus haut, les nombres de publications que nous obtenons sont inférieurs à ceux établis en 2016 par la cellule bibliométrique du Comité national de coordination de la recherche (CNCR), sur la base de données fournie par SIGAPS. Selon cette dernière, le nombre de publications des CHU, comptabilisant uniquement les articles de recherche hors revues classées « NC », est passé de 10203 à 12874, entre 2005 et 2014, pour une croissance de 26% (Baudoin et Devos, 2016, p. 8). En comparaison, nous obtenons dans la même période, une croissance de 24%, ce qui est très proche comme tendance. La robustesse de notre échantillon est confirmée par la comparaison de notre liste des 20 revues dans lesquelles les chercheurs des CHU publient le plus, avec celles établies dans le rapport du CNCR pour les périodes 2005-2009 et 2010-2014. Dans les deux périodes, nous avons respectivement 18 et 17 revues en commun sur 20. Comme pour le CNCR, les revues du top-20 de notre échantillon incluent environ 25% du total des publications.

[2] Voir sur le blogue d’Hervé Maisonneuve : https://www.h2mw.eu/redactionmedicale/2018/03/oncotarget-nest-plus-index%C3%A9-dans-medline-et-web-of-science-sans-raisons-ce-serait-une-revue-pr%C3%A9datri.html

[3] https://alambic.hypotheses.org/tag/sigaps

[4] https://cnup.unistra.fr/fileadmin/upload/DUN/cnup/Documents/CRITERES_de_CANDIDATURE_A_LA_NOMINATION.pdf

[5]https://www.chu-dijon.fr/fr/actualites/2018/02/16/publication-points-sigaps-chercheurs-chu