Beaucoup d’exercices proposés aux élèves paraissent inadaptés et inconséquents y compris au regard des objectifs affichés. En effet, beaucoup de critiques et d’analyses ont été faites qui pointaient les biais des choix effectués concernant les compétences évaluées ainsi que l’exploitation des résultats. Mais ce qu’on devrait mettre à jour également est le fait que ces évaluations sont construites de façon très inconséquente y compris vis-à-vis de ses propres objectifs affichés.

Dans la présentation (assez pompeuse, mais le problème n’est pas là) des évaluations sur le site Eduscol, on peut y lire les trois objectifs principaux :

- « donner des repères aux enseignants pour aider les élèves à progresser,

- permettre d'avoir localement des éléments pour aider les inspecteurs dans le pilotage de proximité,

- ajuster les plans nationaux et académiques de formation et proposer des ressources pertinentes. »

Puis, on peut aussi y trouver la mention de la caution scientifique :

« À l'appui des travaux de la recherche, il est acquis que certaines compétences sont au cœur des apprentissages. Il est donc essentiel d'identifier les objectifs de progression de chaque élève dans l'acquisition de ces compétences. »

Puisqu’il est « acquis » que ce sont ces compétences-là qu’il s’agit d’évaluer en priorité, faisons un exercice de pensée et imaginons un instant que toutes ces instances ne sont au service que de la réussite de tous et ne cherchent qu’à « mieux répondre aux besoins des élèves » (Eduscol, encore).

Observons donc ces évaluations de cette manière-là.

Commençons tout d’abord par pointer quelques incohérences évidentes faciles à comprendre et qu’il serait tout aussi facile de corriger.

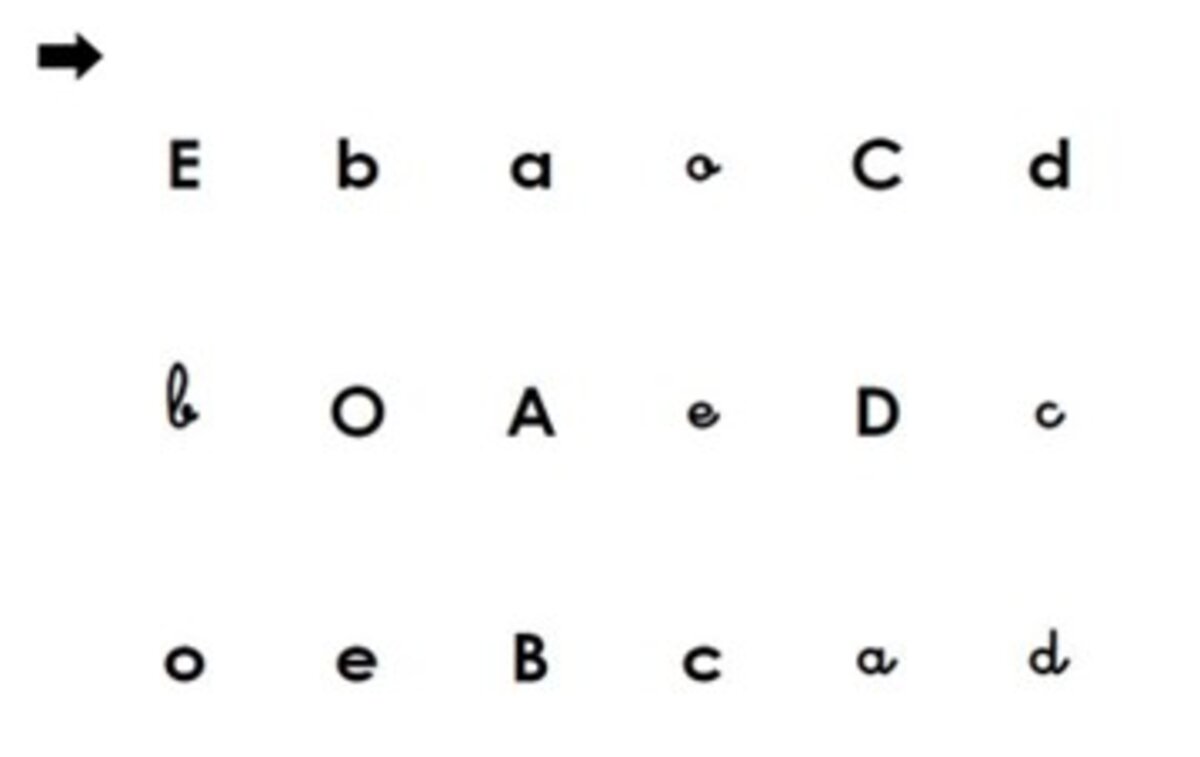

Tout d'abord, en français, l'exercice 2 évalue la compétence « Reconnaitre les différentes écritures d’une lettre ».

Ainsi, par exemple, dans l’exemple ci-dessous, les élèves doivent entourer les différentes écritures de la lettre d.

Comme à ce moment de l’année la confusion b/d fait partie des plus fréquentes (avec entre autres p/q, t/f, I/l etc.) cet exercice permet, sans toutefois être exhaustif, de vérifier la reconnaissance des différentes écritures des lettres, y compris donc celles qui présentent une forte probabilité de confusion.

Jusqu’ici tout va bien ou presque. Mais l’incohérence surgit plus loin, avec l’exercice 16. On demande là aux élèves d'entourer la lettre qui correspond au son qui se trouve au début d'un mot dicté. Par exemple, dans l’exemple ci-dessous, on demande aux élèves d’entourer la lettre qui "correspond au son qu'on entend au début du mot dent" :

On voit bien ici que les élèves qui n'ont pas réussi à identifier la lettre d dans l'exercice 2 ne pourront pas réussir l'exercice 16 alors même qu'ils arrivent à identifier la lettre D et à entendre le son qu'elle produit dans le mot "dent". Le choix qui est fait dans cet exercice 16 de présenter les lettres dans l’écriture minuscule (scripte) nous empêche, nous les enseignants, de savoir si un élève qui a entouré b au lieu de d (pour le mot "dent") l'a fait parce qu'il ne connait pas le son que produit la lettre d ou simplement parce qu'il ne reconnait pas cette lettre dans cette écriture-là. Il en est de même dans la suite de l’exercice avec le mot "bon" et le choix entre b/d, "lune" et le l, « tard » et le choix entre t/f.

De toute évidence, le choix de lettres majuscules aurait pu éviter certaines confusions les plus fréquentes et nous aurait permis une meilleure exploitation des réponses des élèves dans cet exercice. L’exercice 2 permettrait toujours de repérer les difficultés concernant les noms des lettres de même que leurs différentes écritures et l’exercice 16 ainsi modifié limiterait le risque de télescopage d’objectifs dévolus à chaque exercice et rendrait son exploitation d’autant plus… optimale (pour reprendre un mot en vogue).

Mais nous n’en sommes qu’au début de nos étonnements.

Les exercices 18 et 19 présentent des risques similaires en introduisant, par les choix qui y sont effectués, un fort risque de confusion quant à l’origine des éventuelles erreurs. Ce faisant, l’exploitation des résultats de ces évaluations s’en trouve, encore une fois, fortement biaisée. Voyons ce qu’il en est et comment on pourrait y remédier.

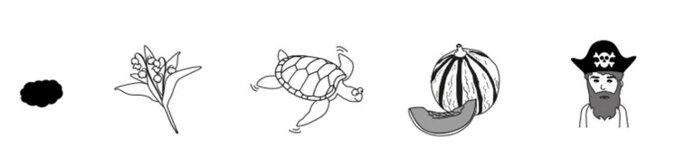

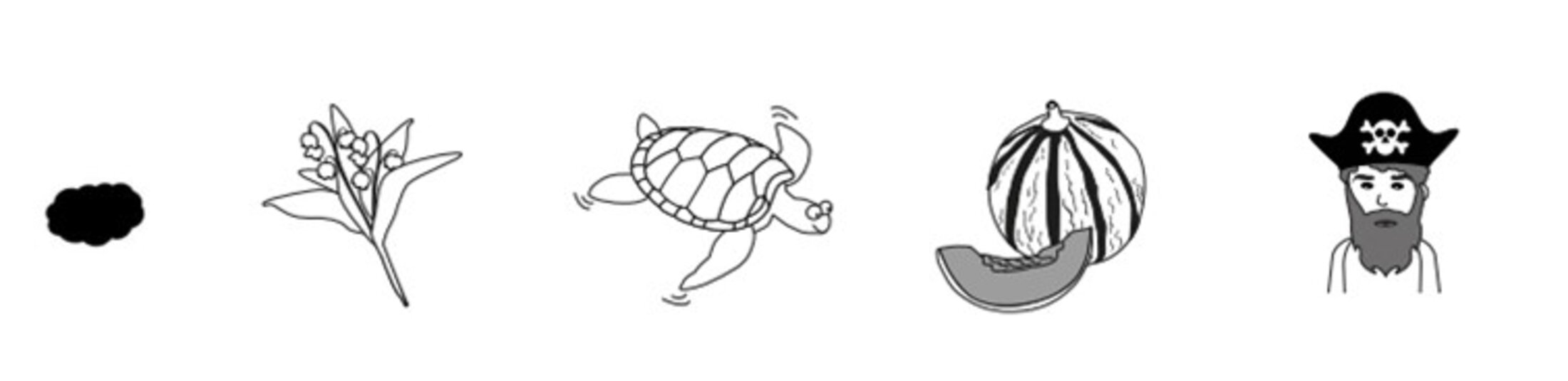

La compétence évaluée dans ces deux exercices est « manipuler des phonèmes ». La tâche des élèves dans l’exercice 18 est le repérage des mots qui débutent par le même phonème que les mots cibles dictés par l’enseignant. A l’inverse, dans l’exercice 19 il s’agit de repérer les mots qui se terminent par le même phonème que les mots cibles dictés.

Or, voici quel biais introduit le choix de certaines images/mots parmi les propositions de réponses. Dans l’exercice 18, on demande aux élèves d’« entourer l’image du mot qui commence comme tulipe ». On dit ensuite les quatre propositions aux élèves : muguet – tortue – melon – pirate. Et voici les dessins qu’ont les élèves sous les yeux :

Agrandissement : Illustration 3

La présence du dessin du muguet risque ici fortement d’être source de confusion lors de l’exploitation des réponses. En effet, un bon nombre d’élèves peut, à ce moment de l’année, ne pas connaitre la différence entre les tulipes et les muguets. Ainsi, il peut s’en suivre une confusion quant au respect de la consigne. Certains élèves peuvent, plutôt que d’analyser les phonèmes d’attaque des mots, se contenter d’entourer le dessin de ce qu’ils considèrent être des tulipes. Dans cet exemple, la connaissance de l’appartenance des mots « tulipe » et « muguet » au champ lexical des fleurs représente même un obstacle supplémentaire par rapport à l’absence de cette connaissance. Et surtout, nous ne pourrons savoir si l’élève a choisi d’entourer le muguet parce qu’il n’a pas réussi à identifier le phonème qui se trouve au début du mot « tulipe » ou bien parce qu’il a cru que ce dessin représentait des tulipes elles-mêmes !

Nous trouvons le même risque de confusion surtout dans l’exercice 19 avec le mot « bille » et le dessin d’une balle ; le mot « maison » et le dessin d’un palais ; le mot « pirate » et le dessin d’un bateau ; le mot « bateau » et le dessin d’un navire ; le mot « message » et le dessin d’un courrier et enfin le mot « petit » et le dessin d’un papa avec une poussette mais aussi celui d’un bébé alors que le dessin qu’il s’agit d’entourer est celui d’un kiwi.

Cette proximité sémantique et visuelle entre le bateau et le navire, la maison et le palais, le petit et le bébé etc. brouille là aussi la lecture des résultats. L'élève s'est-il trompé et a entouré le navire parce qu'il n'entend pas le phonème [o] ou bien simplement parce qu'il a vu un bateau là où le maître/la maitresse a lu navire?

L’exercice 3 contient les mêmes choix présentant des proximités problématiques (couleur/peinture ; binocle/lunettes ; monture/cheval ; tangram/puzzle ; bouton/chemise ; chanteur/micro ; pirogue/bateau) alors que la compétence censément évaluée est la « manipulation des phonèmes » et que les élèves sont invités à repérer les syllabes d’attaque des mots proposés.

Ce choix d'introduire des mots dont le visuel proche et/ou l'appartenance à un champ lexical commun ne permettent pas une exploitation optimale de ces évaluations est malvenu. On pourrait facilement les remplacer par d’autres pour rendre la lecture et l’interprétation des résultats beaucoup plus certaine et centrée sur la compétence évaluée.

Si nous souhaitons nous rapprocher un tant soit peu d’une démarche scientifique, pourtant revendiquée et même déniée à tant d’autres par les technocrates du ministère, pour évaluer la capacité d’un élève à « manipuler des phonèmes » on se serait efforcée de créer un environnement le plus neutre possible pour pouvoir repérer des difficultés dans ce domaine bien précis. Ici, on lui demande d’entendre le [o] de bateau et on lui pose sous les yeux une image de navire. En plus de la compétence affichée ici on évalue aussi sa capacité à trier les informations selon un critère de pertinence bien précis, à savoir qu’ici on doit se focaliser sur le son final des mots plutôt que leur similarité, voire pour certains élèves leur équivalence. Poser leurs bureaux au milieu d’un parc d’attractions pour les y évaluer serait une démarche qui ne s’en différencierait qu’en degrés, pas en nature.

Mais les problèmes que pose cette évaluation ne s’arrêtent pas là. Nous sommes toujours pleins de bonne volonté et c’est encore une fois pour cette raison-là que nous déchanterons.

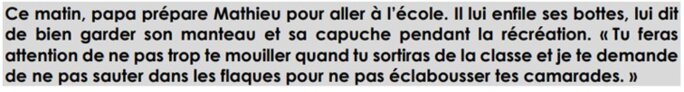

Dans l’exercice 1 qui évalue la compétence « comprendre des textes à l’oral », le choix des questions et des réponses/illustrations proposées aux élèves est lui aussi potentiellement source de confusion.

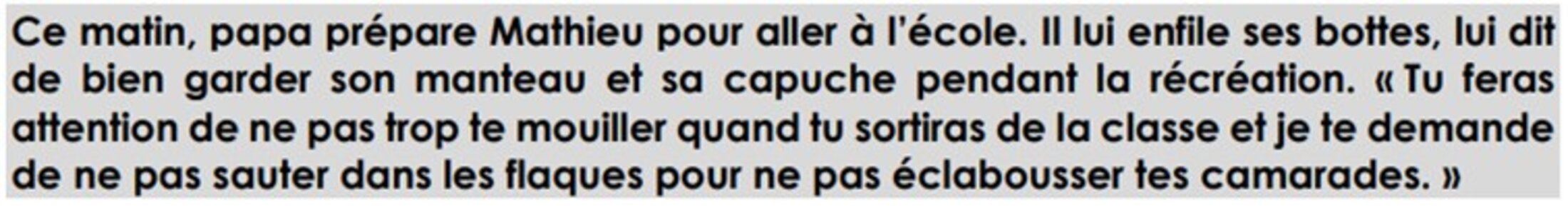

Premièrement, nous pourrions regretter le fait que les deux premières questions appartiennent à la même catégorie, celle de l’implicite. En effet, après avoir lu aux élèves le texte suivant :

Agrandissement : Illustration 4

on pose les deux questions suivantes aux élèves :

Où se passe l’histoire ?

puis

Quel temps fait-il dans cette histoire ?

Pour répondre à ces deux questions les élèves doivent établir un lien entre ce que raconte le texte et leurs connaissances personnelles. En effet, les mots « maison » et « pluie », qui sont les bonnes réponses attendues , ne figurent pas dans le texte lu.

L’unique question à laquelle la réponse se trouve explicitement dans le texte (même si le mot « interdit » n’y figure pas ce qui rend même cet explicite-là quelque peu dépendant des connaissances lexicales de l’élève) est la troisième :

Entoure ce que le papa interdit de faire à Mathieu.

La réponse attendue est « de sauter dans les flaques ». En effet, le papa de Mathieu lui interdit cela explicitement dans le texte. Sauf que ce qui est aussi dit explicitement est la raison de cette interdiction. Cette interdiction n’étant pas une fin en soi, elle est conditionnée par une autre interdiction qui l’englobe : celle de ne pas éclabousser ses camarades.

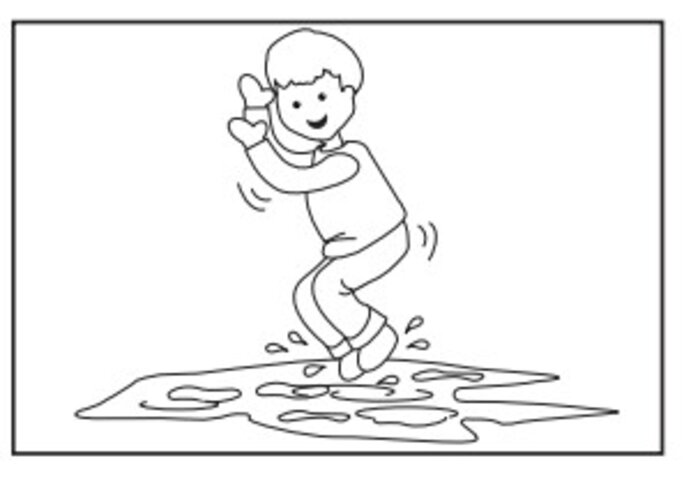

Tout ceci pourrait passer pour des détails sans importance si le choix des réponses proposées aux élèves ne créait là aussi de la confusion. Voyez les deux illustrations correspondant aux interdictions respectives de « sauter dans les flaques » :

et celle d’ « éclabousser ses camarades avec son vélo » :

Cette dernière réponse est la seule qui évoque dans sa formulation et son illustration l’interdiction principale : celle de ne pas éclabousser ses camarades. La « bonne » réponse se limite à l’interdiction strictement explicite : ne pas sauter dans les flaques. Dans cette réponse, à aucun moment, ni dans sa formulation orale, ni dans l’illustration (l’enfant est seul et n’éclabousse personne) il n’est fait mention de sa raison d’être pourtant explicitée par le texte.

Il aurait été indiscutablement plus judicieux, et plus proche d’une démarche scientifique digne de ce nom, que la mention des camarades éclaboussés soit présente dans toutes les réponses ou bien aucune. Ici, on ne peut savoir d’après la seule réponse de l’élève, si celui-ci a commis une erreur parce qu’il n’a pas compris l’interdiction explicite du papa ou bien parce qu’il s’est davantage attaché à la raison d’être de cette interdiction, elle-même présente explicitement dans le texte. Une autre solution serait donc de retirer cette référence aux camarades éclaboussés du texte lu aux élèves et de placer le point final après le mot « flaques ».

En l’état, cet exercice est simplement inexploitable, malgré toute la bonne volonté du monde. Pourtant, depuis le début, nous n’en manquons point.

Concernant les mathématiques, le choix des problèmes des exercices 6 et 14 n’est pas cohérent avec l’objectif affiché d’aider les enseignants à apporter un « enseignement personnalisé adapté aux besoins de chaque élève ». La compétence évaluée étant « Résoudre des problèmes relevant de structures additives », nous ne pouvons qu’être surpris par l’uniformité des problèmes proposés. En effet, sur 8 problèmes proposés aux élèves, 6 relèvent de la même structure. Il s’agit à chaque fois d’une comparaison d’états avec la recherche de la comparaison.

Tous ces problèmes ont exactement la même structure : « Il y a 5 chiens et seulement 3 os. Combien faudrait-il ajouter d’os pour que chaque chien en ait un ? »

Qu’on ait 5 chiens et seulement 3 os ; 6 poules et seulement 3 œufs ; 8 élèves et seulement 2 vélos ; 7 enfants et seulement 1 bonnet ; 4 chiens et seulement 1 collier ; 5 lapins et seulement 3 carottes, il s’agit à chaque fois d’un seul et même problème.

Cette compétence aurait mérité d’être évaluée de façon plus fine avec une variété beaucoup plus grande de problèmes proposés. Ici, un élève en difficulté dans ce type de problèmes particulier sera signalé comme un élève à besoin quelle que soit sa maitrise des autres types de problèmes. Et surtout, ce choix nous empêche, tout comme les précédents évoqués ici, à proposer un enseignement « personnalisé et adapté aux besoins de chaque élève ».

Concernant l’exercice 8 dont l’objectif affiché est d’évaluer la compétence « comparer des nombres », il est construit d’une telle manière qu’on se demande si le ministère n’avait pas lancé un défi aux concepteurs de ces évaluations avec comme critère de réussite la mise en difficulté et en stress des élèves.

Voyons de quoi il s’agit.

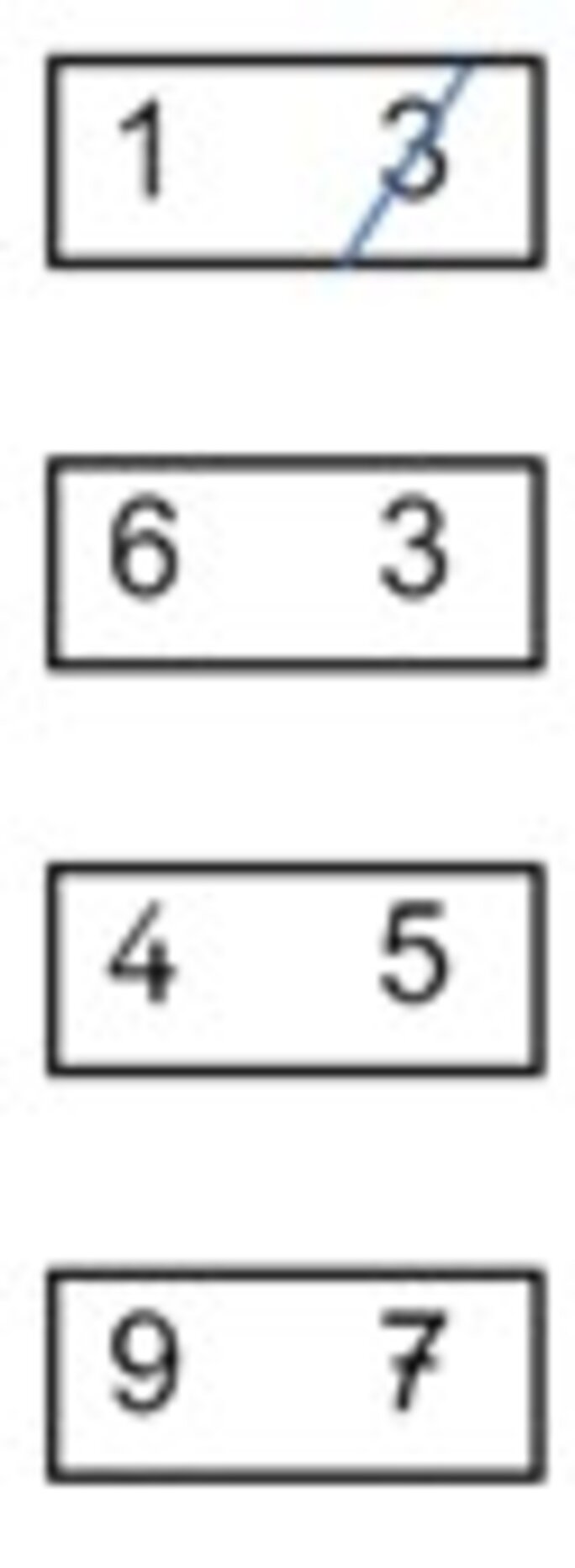

Les élèves doivent barrer le plus grand des deux nombres se trouvant dans chaque case :

Mais il s’agit d’un exercice de vitesse. Ceci est annoncé et mis en scène. Nous sommes invités à expliquer aux élèves : « C’est un exercice de vitesse. Il dure seulement 1 minute. Vous n’aurez sûrement pas fini. »

Pis, nous sommes censés mettre en scène cette tension engendrée par le chronométrage :

« Je vais mettre en route le chronomètre. Pendant ce temps-là tout le monde lève le crayon, bras en l’air. […] Quand je dirai : ALLEZ, vous pourrez commencer et quand je dirai : STOP, vous devrez arrêter, lever le crayon et tourner la page du cahier. »

Et sur la page en question se trouvent pas moins de… 40 cases !

On peut imaginer que certains concepteurs et, pourquoi pas, même certains élèves, trouvent ce dispositif amusant. Cette ambiance de compétition et de course contre la montre peut plaire. Mais il y a tout de même une sacrée différence entre évaluer de façon efficace la compétence « comparer des nombres » et ce dispositif qui aurait toute sa place dans la mallette d’un animateur de centre de loisirs. Là où nous aurions besoin encore une fois d’un environnement le plus neutre possible pour évaluer une compétence précise, on pollue l’environnement des élèves avec un chronomètre.

De plus, ce faisant, on risque de consolider une notion de nombre erronée chez un bon nombre d’élèves, les incitant à effectuer un simple numérotage.

D’autres faiblesses existent dans ces évaluations. On pourrait évoquer justement par exemple la possible réduction des mathématiques aux procédures de comptage-numérotage et une trop faible place accordée au dénombrement (les exercices de comparaison et de frise numérique sont de ce point de vue assez inintéressants) ainsi que la procédure opaque de « correction » par remontée numérique des résultats, réduisant les enseignants à une fonction purement instrumentale.

L’exercice chronométré décrit ci-dessus est assez emblématique de ce que vit le monde de l’éducation mais aussi plus largement notre société. Cette façon de faire semble tout droit sortie de ce récit néolibéral et méritocratique selon lequel nous ne donnerions le meilleur de nous-mêmes que lorsqu’on est placés au pied du mur et mis sous pression. Récit que le métier d’enseignant du service public de l’éducation dément jour après jour. Protégés par notre statut nous travaillons pourtant tous, d’après toutes les études, y compris les ministérielles, plus de 43 heures par semaine. Alors que d’après ce récit nous ne devrions en faire même pas 30.

C’est d’ailleurs peut-être pour cette raison même que notre statut est devenu une cible. Ces évaluations représentent en miniature l’évolution de notre métier : L'enseignant ne serait plus chargé de construire lui-même la structure de son enseignement. La didactique serait une affaire déléguée à la machine savante qui établirait un protocole dont l'élève aurait besoin et l'enseignant se chargerait de l'accompagner. L’enseignant se contentera dorénavant de transmettre des contenus pensés par d'autres.

Ici, nous avons fait l’expérience de bonne volonté et le résultat est sans appel. Ça fait 6 ans que ça dure.

L’analyse que nous avons tenté de faire ici-même montre bien une chose : pour le moment, la machine mérite qu’on lui résiste.

Alors, qu’attendons-nous ?

Au nom de nos élèves, de notre attachement à un service public de l’éducation digne de ce nom, de l’honnêteté intellectuelle et de notre refus d’être des pions effectuant des tâches que l’on sait parfaitement inutiles, inadaptées et même nocives pour beaucoup de nos élèves, nous devrions cesser de courber l’échine. Cesser de subir pour cesser de faire subir. La passation de ces évaluations et la remontée des résultats pourraient être une occasion pour nous tous de commencer à relever la tête et de dire enfin STOP.