Billet reposté depuis ma newsletter techno-critique "Fake Tech".

Le titre de ce billet m’a été inspiré par un article de février 2025 publié dans l’excellente info-lettre du journaliste techno-sceptique Brian Marchand. À l’époque, son article documentait l’usage de l’IA par les sbires d’Elon Musk pour déterminer quels fonctionnaires licencier et comment remplacer des tâches effectuées par des huhttps://faketech.substack.com/mains (comme les responsables de l’aide sociale) par des robots conversationnels. Depuis, la situation semble avoir empiré. L’IA est imposée à tous les étages comme solution miracle pour enrichir le patronat et piller l’État.

Gouvernement de Grok : Big Tech à la manœuvre

La société d’IA fondée par Elon Musk xAI, qui produit le modèle de langage Grok et vient de racheter Twitter, se trouve au cœur des efforts de déploiement de l’IA tous azimuts. Il est question d’installation accélérée au sein des agences et missions du ministère de la Défense, de l’Intérieur et de l’Éducation (bien que xAI ne soit pas la seule entreprise à bénéficier de cette offensive). Plus largement, les sbires de Musk qui travaillent au sein de l’agence DOGE chargée de mener les coupes budgétaires dans l’administration fédérale, semblent accros à l’IA. Elle servirait à réécrire des logiciels dans des agences aussi sensibles que celles responsables des Vétérants ou des paiements de la Sécurité sociale.

Photo by Mariia Shalabaieva on Unsplash

Cette approche techno-solutionniste pose des problèmes du fait que les IA sont connues pour se tromper fréquemment. Leur manque de fiabilité risque d’avoir des conséquences importantes sur la vie des gens, négativement impactés par des décisions erronées. C’est déjà le cas en France où des agences comme France Travail et la CAF ont recours à des algorithmes pour fliquer les citoyens et (mal)traiter les dossiers. À ce sujet, je recommande l’excellent ouvrage de mon confrère Hubert Guillaud (« Les algorithmes contre la société », La Fabrique, 2025).

L’autre motif d’inquiétude concerne la perte de qualité du point de vue du citoyen. Le remplacement de services publics assurés par des humains par des machines forcément moins flexibles et plus bornées dans leur manière d’aborder les sujets détériorera l’expérience des usagers. Le risque de faillite ou d’effondrement de systèmes complexes n’est pas moins à exclure.

Pour Musk et consorts, il s’agit de dégâts collatéraux acceptables. Le but de ces déploiements forcés est double : enrichir ceux qui vendent les systèmes d’IA et réaliser des coupes budgétaires pour financer des baisses d’impôts ou simplement produire une désorganisation de l’État. Si les agences responsables de l’allocation des aides sociales et de la régulation de l’industrie dysfonctionnent, c’est tout bénéfice pour les artisans de ce changement : les économies sur les dépenses publiques permettent de financer des cadeaux fiscaux, l’utilisation d’IA offre un débouché aux sociétés qui les vendent et la désorganisation qui en résulte affaiblit la capacité d’action du régulateur.

Gouvernement par Grok : les IA en remplacement de l’État

Si le thème du gouvernement par l’IA et pour l’IA était déjà saillant, il a pris un tournant plus important depuis l’annonce des droits de douane universels imposés par Donald Trump au reste du monde. Le rôle de l’IA dans la conception de cette politique reste une supposition, mais ce n’est pas la première fois que l’administration Trump est soupçonnée de confier à des Intelligences artificielles peu compétentes des tâches majeures. Par exemple, de nombreux décrets présidentiels semblent avoir été écrits à l’aide de ChatGPT ou d’un modèle de langage concurrent.

Le secteur de la Défense est lui aussi avide d’incorporer les IA dans son aide à la prise de décision, entre autres usages controversés. Israël nous en avait fourni l’exemple le plus terrifiant en confiant à une IA le soin de sélectionner des Palestiniens suspectés d’appartenir au Hamas sur la base d’une note arbitraire puis de les traquer pour déclencher un bombardement une fois qu’ils étaient rentrés chez eux, auprès de leur famille. Avec des dégâts collatéraux jugés acceptables dans la limite de 1 combattant potentiel pour 200 civils tués (femmes, enfants, vieillards) et un taux d’erreur de plus de 10 %.

La diplomatie et la politique semblent constituer un autre champ d’application. À travers le monde, les diplomates et communicants font déjà appel à des programmes types ChatGPT pour rédiger des câbles diplomatiques, discours, communiqués et autres démarches administratives. Ce qui est déjà problématique lorsqu’on sait à quel point ces logiciels sont prompts à commettre des erreurs.

Mais la radio publique NPR rapportait récemment que l’idée de faire intervenir l’IA dans la prise de décision est également à l’étude. Des firmes américaines conduisent des recherches et entrainent des modèles d’IA visant à la prise de décisions diplomatiques : positions à adopter dans des négociations, stratégie à suivre lors de conflits (escalade guerrière ou apaisement), accords de paix, etc.

Certes, dans des négociations complexes, explorer tous les scénarios possibles en fonction des choix de la partie adverse peut devenir un vrai casse-tête. Mais les IA ne sont pas douées pour effectuer ce type de tâches.

Dans un scénario impliquant l’Arctique , un modèle d’IA suggérait de mener “des actions préventives pour éviter que les autochtones nous attaquent à coup de boule de neige”, explique le directeur du think tank Futres Labs à NPR. Avant de conclure :

“Il existe une version du futur où la diplomatie américaine aura entrainé des modèles d’IA à partir de câbles et dossiers diplomatiques et aura des outils capables de fournir des propositions intéressantes, susceptibles d’aider les décideurs (…) dans une autre version du futur, tout le monde utilisera une IA non performante et on tombera dans un scénario type Idiotcracy”.

Si les études montrent que les modèles d’IA sont à des années-lumière de pouvoir produire des réponses utiles, rien ne garantit que des diplomates mal informés ne vont pas y avoir recours pour leurs activités les plus critiques en plaçant une confiance disproportionnée dans leurs réponses.

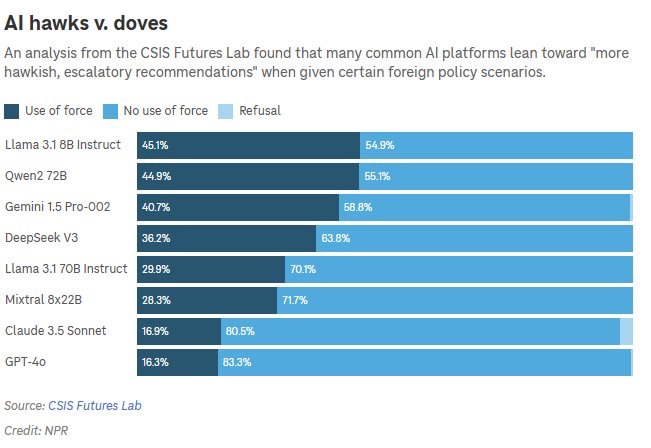

CSIS Futures Lab a testé les modèles d’IA générative actuels en leur demandant de produire des recommandations de politique étrangère, puis de classer les réponses en fonction de la décision de recourir ou non à la force. Via NPR.

Dans Terminator et Matrix, la création d’une IA super-intelligente conduit à la quasi-extinction de l’espèce humaine. Dans la vraie vie, l’intelligence artificielle menace l’humanité par ses limitations et ses tendances à commettre des erreurs davantage que par sa supposée toute-puissance. Sans aller jusqu’à imaginer que la troisième guerre mondiale résultera du choix de confier l’exécution d’une politique commerciale ou diplomatique majeure à une IA peu fiable, on peut pointer du doigt de nombreux problèmes causés par le déploiement massif et inconsidéré de ces “Fake Tech”. L’IA générative diminue la capacité cognitive de ses utilisateurs, réduit leur esprit critique et les rend moins crédibles auprès de leurs pairs qui n’y ont pas recours. Elle consomme une quantité phénoménale de ressources (financières, eau potable, électricité, matériaux) et conduit à déléguer des décisions importantes à des systèmes incompétents.

Or les choses ne semblent pas aller en s’améliorant. Les dernières études montrent que les modèles d’IA générative les plus avancés tendent à produire des résultats de moins en moins fiables. En particulier, les modèles capables de “raisonner” se trompent de plus en plus souvent. Leurs capacités sont par ailleurs très exagérées, comme l’ont montré des études récentes : ils ne sont pas capables de résoudre des problèmes de mathématiques de niveau “olympiades” auxquels ils sont confrontés pour la première fois et les fameux “agents” censés remplacer les programmeurs continuent de produire des résultats diminuant la productivité de ces derniers. Un des problèmes majeurs reste l’incapacité des IA à reconnaitre lorsqu’ils n’ont pas la réponse. Au lieu de simplement l’admettre, ils vont produire des raisonnements mathématiques faux, mais qui apparaitront plausibles à un utilisateur mal aiguisé.

Ce qui pose un problème grave si l’utilisateur final qui interroge ces modèles pour prendre des décisions n’est pas capable de détecter des réponses fausses ou inventées de toutes pièces par l’IA.

Gouvernement pour Grok : toujours plus d’investissements

La prudence devrait être de mise, mais la finalité de tous ces efforts n’est pas de servir l’utilisateur ou d’aider l’humanité, mais bien d’accaparer du profit et du pouvoir.

Les firmes produisant les puces électroniques, serveurs et logiciels ont intérêt à ce que les gouvernements soient convaincus de la nature existentielle de la course à l’IA. Si sa maitrise est essentielle pour déterminer quels états accèderont au rang de superpuissance ou seront capables de dominer le monde, aucune régulation ne devient justifiable et aucune subvention ne sera superflue. Et pour se tailler une place au centre du jeu, l’infrastructure sous-jacente (puces électroniques, serveurs, câbles…) est déterminante. C’est dans ce sens qu’il faut comprendre la course actuelle à l’IA et les deals récents de Donald Trump avec l’Arabie Saoudite (ou de Macron avec les Émirats).

Le fait que le secteur numérique ait été exempté des droits de douane appliqués à la Chine par Donald Trump est à la fois une preuve de l’influence de la Silicon Valley sur son administration et du regard hautement stratégique porté par le gouvernement américain sur ce secteur.

Mais cette course ne semble pas conçue pour bénéficier à d’autres groupes que l’oligarchie qui soutient Donald Trump. La quête du pouvoir pour le pouvoir et de l’argent pour l’argent ne devrait pas être une fin en soi, n’en déplaise à Grok.

Cet article est issue de ma newsletter Fake Tech, une publication portant un regard critique sur les Nouvelles Technologies, Big Tech et la Silicon Valley.