Article original publié en anglais le 18 novembre 2020 par Richard Van Noorden sur le site de Nature. Pour accéder à la version originale :https://www.nature.com/articles/d41586-020-03187-3?fbclid=IwAR1jVIxPCm6tV4qzaUvBXvSKiK8SE2JrjJ_bTBKclH0TwrHWy91jTHyV1LY

Agrandissement : Illustration 1

En septembre 2019, quatre chercheurs ont écrit à l'éditeur Wiley pour «lui demander respectueusement» de retirer immédiatement un article scientifique. L'étude, publiée en 2018, avait entraîné des algorithmes pour distinguer les visages du peuple ouïghour, une minorité ethnique majoritairement musulmane en Chine, de ceux d'origine coréenne et tibétaine. La Chine avait déjà été condamnée internationalement pour sa surveillance intensive et ses détentions massives d'Ouïghours dans des camps de la province du nord-ouest du Xinjiang - qui, selon le gouvernement, sont des centres de rééducation visant à étouffer un mouvement terroriste. Selon les médias, les autorités du Xinjiang ont utilisé des caméras de surveillance équipées de logiciels adaptés aux visages ouïghours. En conséquence, de nombreux chercheurs ont trouvé inquiétant que des universitaires aient essayé de construire de tels algorithmes - et qu'un journal américain ait publié un article de recherche sur le sujet. Et l'étude de 2018 n'était pas la seule: des revues d'éditeurs tels que Springer Nature, Elsevier et l'Institute of Electrical and Electronics Engineers (IEEE) avaient également publié des articles évalués par des pairs décrivant l'utilisation de la reconnaissance faciale pour identifier les Ouïghours et les membres d'autres Chinois de groupes minoritaires. (L'équipe des actualités de Nature est indépendante de son éditeur, Springer Nature.)

Cette plainte, qui a donné lieu à une enquête en cours, s'inscrit dans le cadre des efforts croissants déployés par certains scientifiques et militants des droits de l'homme pour amener la communauté scientifique à adopter une position plus ferme à l'égard des recherches sur la reconnaissance faciale, qui sont contraires à l'éthique. Il est important de dénoncer les utilisations controversées de cette technologie, mais cela ne suffit pas, disent les éthiciens. Les scientifiques devraient également reconnaître les fondements moralement douteux d'une grande partie des travaux universitaires dans ce domaine - y compris les études qui ont permis de recueillir d'énormes ensembles de données d'images de visages de personnes sans leur consentement, dont beaucoup ont contribué à affiner les algorithmes de surveillance commerciale ou militaire.

Un nombre croissant de scientifiques demandent instamment aux chercheurs d'éviter de travailler avec des entreprises ou des universités liées à des projets non éthiques, de réévaluer la manière dont ils collectent et distribuent les ensembles de données de reconnaissance faciale et de repenser l'éthique de leurs propres études. Certaines institutions prennent déjà des mesures dans ce sens. L'année dernière, plusieurs revues et une conférence universitaire ont annoncé des contrôles éthiques supplémentaires sur les études.

"Beaucoup de gens se demandent maintenant pourquoi la communauté de la vision par ordinateur consacre autant d'énergie au travail de reconnaissance faciale alors qu'il est si difficile de le faire de manière éthique", explique Deborah Raji, une chercheuse d'Ottawa qui travaille à la fondation Internet Mozilla, à but non lucratif. "Je vois une coalition croissante qui s'oppose à toute cette entreprise".

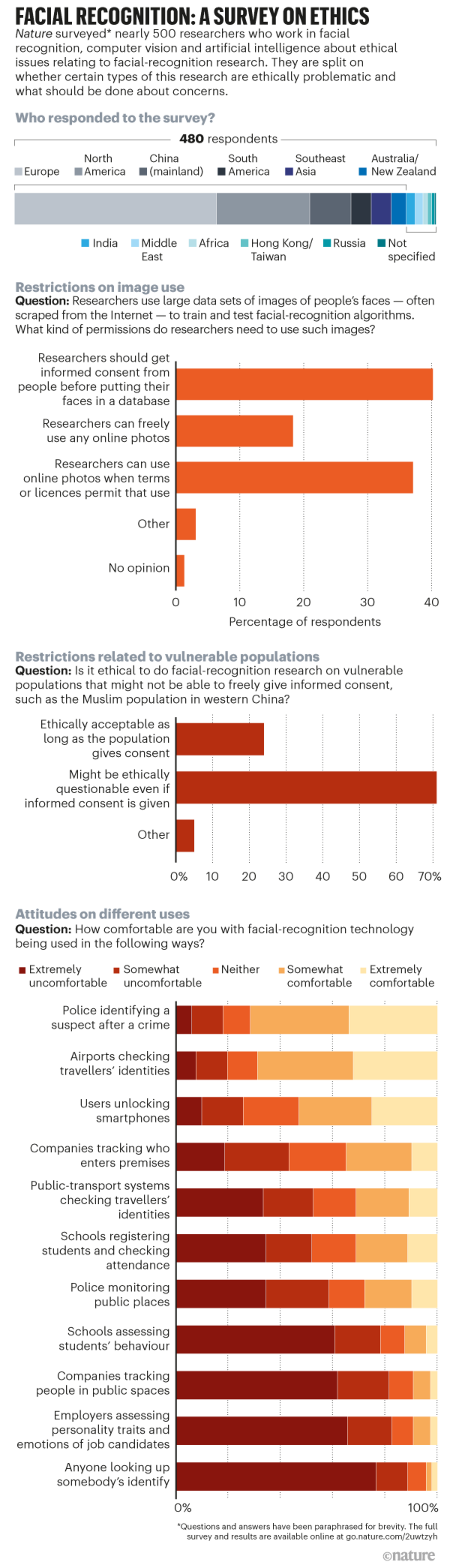

Cette année, Nature a demandé à 480 chercheurs du monde entier travaillant dans le domaine de la reconnaissance faciale, de la vision par ordinateur et de l'intelligence artificielle (IA) de donner leur avis sur d'épineuses questions éthiques concernant la recherche sur la reconnaissance faciale. Les résultats de cette enquête, première du genre, suggèrent que certains scientifiques sont préoccupés par l'éthique du travail dans ce domaine - mais d'autres ne considèrent toujours pas les études universitaires comme problématiques.

Données sans consentement

Pour que les algorithmes de reconnaissance faciale fonctionnent bien, ils doivent être formés et testés sur de grands ensembles de données d'images, idéalement capturées plusieurs fois dans différentes conditions d'éclairage et sous différents angles. Dans les années 1990 et 2000, les scientifiques ont généralement fait appel à des volontaires pour poser pour ces photos - mais la plupart d'entre eux recueillent aujourd'hui des images faciales sans demander la permission.

Par exemple, en 2015, des scientifiques de l'université de Stanford en Californie ont publié un ensemble de 12 000 images provenant d'une webcam installée dans un café de San Francisco, qui avaient été diffusées en direct sur Internet. L'année suivante, des chercheurs de l'université Duke à Durham, en Caroline du Nord, ont publié plus de 2 millions d'images vidéo (85 minutes) d'étudiants marchant sur le campus universitaire.

Agrandissement : Illustration 2

Les plus grandes collections ont été rassemblées en ligne. En 2016, des chercheurs de l'Université de Washington à Seattle ont publié une base de données, appelée MegaFace, de 3,3 millions de photos provenant du site de partage d'images Flickr. Et les scientifiques de Microsoft Research à Redmond, Washington, ont publié le plus grand ensemble de données au monde, MSCeleb, composé de 10 millions d'images de près de 100 000 personnes, dont des journalistes, des musiciens et des universitaires, extraites d'Internet. En 2019, l'artiste berlinois Adam Harvey a créé un site Web appelé MegaPixels qui signalait ces ensembles de données et d'autres. Lui et un autre technicien et programmeur basé à Berlin, Jules LaPlace, ont montré que beaucoup avaient été partagés ouvertement et utilisés pour évaluer et améliorer les produits de surveillance commerciaux. Certains ont été cités, par exemple, par des entreprises qui ont travaillé sur des projets militaires en Chine. «Je voulais découvrir la vérité inconfortable selon laquelle de nombreuses photos publiées en ligne ont une vie après la mort en tant que données d'entraînement», dit Harvey. Au total, il dit avoir cartographié 29 ensembles de données, utilisés dans environ 900 projets de recherche. Les chercheurs utilisent souvent des images Flickr publiques qui ont été téléchargées sous des licences de droits d'auteur qui permettent une réutilisation libérale. Après que le Financial Times a publié un article sur le travail de Harvey en 2019, Microsoft et plusieurs universités ont supprimé leurs ensembles de données. La plupart ont dit à l'époque - et ont réitéré à Nature ce mois-ci - que leurs projets étaient terminés ou que les chercheurs avaient demandé que l'ensemble de données soit supprimé. L'informaticien Carlo Tomasi de l'Université Duke était le seul chercheur à s'excuser pour une erreur. Dans une déclaration deux mois après la suppression de l'ensemble de données, il a déclaré qu'il avait obtenu l'approbation du comité d'examen institutionnel (IRB) pour ses enregistrements - que son équipe a faite pour analyser le mouvement des objets dans la vidéo, pas pour la reconnaissance faciale. Mais selon les directives de l'IRB, il n'aurait pas dû les enregistrer à l'extérieur et n'aurait pas dû rendre les données disponibles sans protection par mot de passe. Tomasi a dit à Nature qu'il avait fait des efforts pour alerter les étudiants en mettant des affiches pour décrire le projet. La suppression des ensembles de données semble avoir un peu freiné leur utilisation, dit Harvey. Mais de grandes collections d'images en ligne telles que MSCeleb sont toujours distribuées parmi les chercheurs, qui continuent de les citer et, dans certains cas, les ont à nouveau téléchargées ou ont téléchargé les ensembles de données qui en découlent. Les scientifiques stipulent parfois que les ensembles de données ne doivent être utilisés que pour la recherche non commerciale - mais une fois qu'ils ont été largement partagés, il est impossible d'empêcher les entreprises de les obtenir et de les utiliser. En octobre, des informaticiens de l'Université de Princeton dans le New Jersey ont signalé avoir identifié 135 articles qui avaient été publiés après la suppression de l'ensemble de données Duke et qui l'avaient utilisé ou des données dérivées (voir go.nature.com/3nlkjre). Les auteurs ont exhorté les chercheurs à imposer davantage de restrictions à l'utilisation des ensembles de données et ont demandé aux revues de cesser d'accepter des articles utilisant des ensembles de données qui avaient été supprimés. Le règlement général sur la protection des données (RPDP) de l'Union européenne, tant vanté, ne fournit pas de base juridique évidente aux chercheurs pour le faire. Mais il n'y a pas eu de directives officielles sur la manière d'interpréter le RPDP sur ce point, et il n'a pas été testé devant les tribunaux. Aux États-Unis, certains États affirment qu'il est illégal pour les entreprises commerciales d'utiliser les données biométriques d'une personne sans son consentement ; l'Illinois est le seul État à permettre aux particuliers d'engager des poursuites à ce sujet. L'Illinois est le seul État à permettre aux particuliers d'intenter des poursuites à ce sujet. En conséquence, plusieurs entreprises ont fait l'objet de recours collectifs. La société américaine de réseaux sociaux Facebook, par exemple, a accepté cette année de verser 650 millions de dollars US pour résoudre un recours collectif en Illinois concernant une collection de photos qui n'était pas accessible au public et qu'elle utilisait pour la reconnaissance faciale (elle permet désormais aux utilisateurs de refuser le marquage de reconnaissance faciale). La société technologique Clearview AI, basée à New York, a également été poursuivie pour avoir violé cette loi dans des affaires en cours. Elle affirme avoir mis au rebut trois milliards de photos en ligne pour un système de reconnaissance faciale. Et les entreprises technologiques américaines IBM, Google, Microsoft, Amazon et FaceFirst ont également été poursuivies en justice dans l'Illinois pour avoir utilisé un ensemble de données de près d'un million de photos en ligne qu'IBM a publié en janvier 2019 ; IBM l'a supprimé à peu près au moment de la poursuite, qui faisait suite à un rapport de NBC News détaillant l'inquiétude des photographes quant au fait que leurs photos se trouvaient dans l'ensemble de données.

Microsoft a déclaré à Nature qu'elle avait déposé une demande de non-lieu, et Clearview affirme qu'elle "ne recherche que des informations accessibles au public, comme Google ou tout autre moteur de recherche". D'autres entreprises n'ont pas répondu aux demandes de commentaires.

Les populations vulnérables

Dans l'étude sur les visages des Ouïghours publiée par Wiley, les chercheurs n'ont pas recueilli de photos en ligne, mais ont déclaré avoir pris des photos de plus de 300 étudiants ouïghours, coréens et tibétains de 18 à 22 ans à l'université Dalian Minzu, dans le nord-est de la Chine, où certains des scientifiques travaillaient. Des mois après la publication de l'étude, les auteurs ont ajouté une note pour dire que les étudiants y avaient consenti. Mais les affirmations des chercheurs n'apaisent pas les inquiétudes éthiques, déclare Yves Moreau, un biologiste informaticien de l'Université catholique de Louvain. Il a envoyé à Wiley une demande de rétractation l'année dernière, en collaboration avec le groupe de défense Tech Inquiry, basé à Toronto.

Il est peu probable que les étudiants aient été suffisamment informés du but de la recherche pour avoir donné un consentement vraiment éclairé, dit Moreau. Mais même s'ils ont donné leur consentement librement, il soutient que les abus des droits de l'homme au Xinjiang signifient que Wiley devrait se rétracter de l'étude pour éviter de donner au travail un crédit académique.

Moreau a catalogué des douzaines d'articles sur les populations ouïghoures, y compris des travaux de reconnaissance faciale et des études qui ont recueilli l'ADN des ouïghoures. En décembre, il a écrit un article d'opinion dans Nature demandant que tous les travaux non éthiques dans le domaine de la recherche biométrique soient annulés.

Sa campagne a eu un certain impact, mais pas tout à fait dans la mesure qu'il espérait. Selon les éditeurs, la question clé est de vérifier si les participants aux études ont donné leur consentement en connaissance de cause. Springer Nature, par exemple, a déclaré en décembre 2019 qu'elle examinerait dans ce sens les documents préoccupants sur les groupes vulnérables, et qu'elle avait exposé ses directives aux éditeurs et aux auteurs sur la nécessité d'obtenir un consentement explicite et éclairé dans les études qui impliquent des données cliniques, biomédicales ou biométriques provenant de personnes. Cette année, l'éditeur a retiré deux articles sur le séquençage de l'ADN parce que les auteurs ont reconnu qu'ils n'avaient pas demandé le consentement des Ouïghours, et il a exprimé ses préoccupations sur 28 autres articles.

Wiley a également mis l'accent sur le consentement éclairé. En novembre dernier, l'éditeur a déclaré à Moreau et à Tech Inquiry qu'il était convaincu que les formulaires de consentement et l'approbation de l'université pour l'étude Dalian étaient disponibles, et il a donc maintenu la recherche, qui, selon lui, pouvait être fermement séparée des actions menées au Xinjiang. "Nous sommes conscients de la persécution des communautés ouïghoures", a déclaré M. Wiley. "Cependant, cet article porte sur une technologie spécifique et non sur une application de cette technologie".

Agrandissement : Illustration 3

En décembre, cependant, l'éditeur a ouvert une enquête officielle, après que l'Université Curtin de Perth, en Australie, où l'un des auteurs est basé, a également demandé une rétractation, affirmant qu'il convenait que le travail était éthiquement indéfendable. Cette année, Wiley a ajouté une note de l'éditeur disant que l'article "semble être conforme aux normes acceptables pour la conduite de recherches sur des sujets humains". En septembre, après que Moreau se soit penché sur les études précédentes des auteurs sur la reconnaissance faciale sur les Ouïghours et ait souligné les incohérences apparentes au cours de l'année où les ensembles de données avaient été collectés, Wiley a exprimé son inquiétude sur l'étude, affirmant qu'il n'était pas clair quand la collecte de données avait eu lieu. L'éditeur a déclaré à Nature qu'il considérait désormais l'affaire close après une enquête approfondie - mais toutes les personnes impliquées ne sont pas satisfaites. "L'Université Curtin soutient que le document devrait être retiré", a déclaré le vice-chancelier adjoint Chris Moran à Nature. Il a dit que l'université enquêtait toujours sur les travaux. Wiley dit qu'après ses conversations avec Moreau, il a mis à jour ses directives d'intégrité pour s'assurer que les normes attendues en matière de consentement éclairé sont respectées et décrites dans des articles. D'autres éditeurs affirment avoir également procédé à des ajustements. L'IEEE déclare qu'en septembre, elle a approuvé une politique en vertu de laquelle les auteurs d'articles sur la recherche impliquant des sujets humains ou des animaux devraient confirmer s'ils avaient l'approbation d'un IRB ou d'un examen local équivalent; les éditeurs déterminent si la recherche (sur la biométrie ou dans d'autres domaines) implique des sujets humains. Mais Moreau dit que l’attention des éditeurs sur les détails du consentement est trop étroite et qu’ils devraient également prendre position sur l’éthique plus large de la recherche. «Nous parlons de violations massives des droits humains», dit-il. "À un moment donné, les éditeurs occidentaux devraient dire qu'il existe des niveaux de référence au-dessus desquels ils ne vont pas." Il suggère que les éditeurs mettent en place des comités d'éthique indépendants qui peuvent donner des avis lorsque de telles questions se posent. (Aucun éditeur interrogé par Nature n'a déclaré avoir franchi cette étape.) Les universités et les chercheurs qui désapprouvent les violations des droits de l'homme pourraient également faire plus pour exprimer cela en abandonnant leurs associations avec des entreprises technologiques douteuses, déclare Kate Crawford, codirectrice du AI Now Institute de l'Université de New York.

Au cours de l’année écoulée, les partenariats entre les universités et les entreprises ou les programmes de recherche liés à la surveillance de masse au Xinjiang ont fait l’objet d’une attention croissante. Le Massachusetts Institute of Technology (MIT) de Cambridge, par exemple, a déclaré qu'il réexaminerait sa relation avec la société de technologie basée à Hong Kong SenseTime après que le gouvernement américain - au milieu d'une guerre commerciale avec la Chine - ait mis la société sur la liste noire avec d'autres entreprises chinoises travaillant sur l’IA, comme Megvii à Pékin, pour leurs contributions présumées aux violations des droits de l'homme au Xinjiang.

En 2018, SenseTime et le MIT ont annoncé qu'ils avaient formé une "alliance sur l'intelligence artificielle" ; le MIT déclare que SenseTime a fourni une somme non divulguée à l'université sans aucune restriction sur la façon dont elle serait utilisée, et que l'université ne la rendra pas.

Megvii et SenseTime contestent tous deux la liste noire américaine. SenseTime affirme que sa technologie "n'a jamais été appliquée à des fins contraires à l'éthique", et Megvii affirme qu'elle exige de ses clients "de ne pas utiliser notre technologie ou nos solutions à des fins illégales ».

Les conférences universitaires ont également été controversées. La conférence chinoise sur la reconnaissance biométrique (CCBR) s'est tenue dans la capitale du Xinjiang, Ürümqi, en 2018. Anil Jain, un informaticien de l'Université d'État du Michigan à East Lansing, a siégé au conseil consultatif de la conférence et s'est rendu sur place pour y prononcer un discours. Certains chercheurs en IA, dont Toby Walsh de l'université de Nouvelle-Galles du Sud à Sydney, en Australie, ont par la suite critiqué Jain pour cela dans des articles du magazine Coda, basé à New York.

Le magazine Coda a également noté que Springer Nature sponsorisait la conférence ; la société a déclaré que son rôle se limitait à publier les actes du CCBR et qu'elle avait renforcé ses exigences pour que les organisateurs de la conférence se conforment aux politiques éditoriales de l'éditeur après que des préoccupations aient été soulevées concernant le contenu passé. Et Jain a contesté la critique en disant à Nature que le fait d'assister à des conférences en Chine "ne signifie pas que ... les participants à des conférences internationales, comme moi, tolèrent ces atrocités contre les minorités". La croissance de la surveillance ne devrait pas être une raison pour "réduire les échanges scientifiques", a-t-il dit.

Jain reste membre du conseil consultatif pour le CCBR 2020-21 ; Springer Nature continue de publier les résumés des conférences. Et les grandes conférences internationales sur la vision par ordinateur ont continué à accepter le parrainage d'entreprises chinoises. Juste après l'inscription sur la liste noire, SenseTime et Megvii ont parrainé la conférence internationale sur la vision par ordinateur de 2019, et Megvii a parrainé la conférence de 2020 sur la vision par ordinateur et la reconnaissance des formes, bien que son logo ait été retiré du site web de la conférence après la réunion. "Les conférences devraient éviter les sponsors qui sont accusés de permettre des abus des droits de l'homme", rappelle M. Walsh. Toutefois, il note que l'année dernière, l'organisation non gouvernementale Human Rights Watch à New York a retiré les allégations initiales selon lesquelles la technologie de reconnaissance faciale Megvii était impliquée dans une application utilisée dans le Xinjiang. Les organisateurs de la conférence n'ont pas répondu à une demande de commentaires.

Points de contrôle éthique

Des projets de recherche douteux ont également vu le jour aux États-Unis. Le 5 mai, l'université de Harrisburg en Pennsylvanie a publié un communiqué de presse déclarant que des chercheurs y avaient développé un logiciel de reconnaissance faciale "capable de prédire si quelqu'un est susceptible de devenir un criminel", avec "une précision de 80 % et sans préjugé racial". Cette annonce a déclenché une vague de critiques, comme l'avaient fait les études précédentes qui renvoient aux travaux discrédités des physionomistes du XIXe siècle. Une étude notoire de 2016 a rapporté qu'un algorithme d'apprentissage automatique pouvait repérer la différence entre les images des non-criminels et celles des criminels condamnés qui étaient fournies par un service de police chinois.

L'université de Harrisburg a retiré son communiqué de presse le 6 mai à la suite du tollé, mais a laissé une question en suspens : le communiqué de presse avait déclaré que l'ouvrage devait être publié par Springer Nature dans une série de livres (ce que l'éditeur a ensuite démenti). Le 22 juin, plus de 2400 universitaires ont signé une lettre d'un groupe appelé Coalition for Critical Technology (CCT), demandant à Springer Nature de ne pas publier l'ouvrage et appelant tous les éditeurs à s'abstenir de publier des études similaires.

La lettre souligne que ces études sont basées sur des données scientifiques non fiables. Elle note également que les outils algorithmiques qui indiquent à la police où ou qui cibler ont tendance à fournir un vernis scientifique pour les méthodes automatisées qui ne font qu'exacerber les préjugés existants dans le système de justice pénale. Trois jours plus tôt, plus de 1 400 mathématiciens américains avaient écrit une lettre demandant à leurs collègues de cesser de collaborer avec la police sur des algorithmes qui prétendent aider à réduire la criminalité, en raison des inquiétudes concernant le racisme systémique au sein des services répressifs américains.

Selon Springer Nature, l'ouvrage n'a jamais été accepté pour publication : il avait été soumis à une conférence et rejeté après examen par les pairs. (Les auteurs, ainsi que l'université de Harrisburg, ont refusé de commenter).

Springer Nature était déjà sous le feu des critiques pour un autre article, publié en janvier dans le Journal of Big Data, sur la détection des "tendances criminelles" dans les photos de criminels et de non-criminels. Après que des chercheurs de l'IEEE aient pris contact avec des préoccupations éthiques, Margeret Hall, co-auteur de l'article à l'université du Nebraska Omaha, a demandé en juin que l'article soit retiré. Selon Hall, le document maintenant retiré était "indéfendable". Selon Springer Nature, la revue a revu ses processus et exige désormais que les auteurs incluent des déclarations sur les approbations éthiques et le consentement lors de la soumission des manuscrits.

Enquête dans Nature

Pour avoir une idée plus précise des opinions des universitaires sur l'éthique de la reconnaissance faciale, Nature a interrogé cette année 480 chercheurs qui ont publié des articles sur la reconnaissance faciale, l'IA et l'informatique. Sur certaines questions, les répondants ont montré une nette préférence. Lorsqu'on leur a demandé leur avis sur les études qui appliquent des méthodes de reconnaissance faciale pour reconnaître ou prédire des caractéristiques personnelles (telles que le sexe, l'identité sexuelle, l'âge ou l'origine ethnique) à partir de l'apparence, environ deux tiers ont répondu que de telles études ne devraient être réalisées qu'avec le consentement éclairé des personnes dont le visage a été utilisé, ou après discussion avec des représentants de groupes susceptibles d'être concernés.

Agrandissement : Illustration 4

Mais sur d'autres questions, les universitaires étaient divisés. Environ 40 % des scientifiques interrogés ont estimé que les chercheurs devraient obtenir le consentement éclairé des personnes avant d'utiliser leur visage dans un ensemble de données de reconnaissance faciale, mais plus de la moitié ont estimé que cela n'était pas nécessaire. Le dilemme des chercheurs est qu'il est difficile de voir comment ils peuvent former des algorithmes de reconnaissance faciale précis sans de vastes ensembles de données de photos, dit Sébastien Marcel, qui dirige un groupe de biométrie à l'Institut de recherche Idiap à Martigny, en Suisse. Il pense que les chercheurs devraient obtenir un consentement éclairé - mais en pratique, ils ne le font pas. Son propre groupe n'explore pas le web pour trouver des images, mais il utilise des ensembles de données d'images en ligne que d'autres ont compilés. "Beaucoup de chercheurs ne veulent pas en entendre parler : ils considèrent que ce n'est pas leur problème", dit-il.

Ed Gerstner, directeur de la politique des revues chez Springer Nature, a déclaré que l'éditeur réfléchissait à ce qu'il pourrait faire pour décourager "l'utilisation continue" de bases de données d'images qui n'ont pas le consentement explicite des personnes figurant sur les images pour leur utilisation dans la recherche.

L'enquête de Nature a également demandé aux chercheurs s'ils pensaient que la recherche sur la reconnaissance faciale des populations vulnérables - comme les réfugiés ou les groupes minoritaires qui font l'objet d'une surveillance intensive - pouvait être éthiquement discutable, même si les scientifiques avaient obtenu un consentement éclairé. Dans l'ensemble, 71 % des personnes interrogées ont répondu par l'affirmative ; certaines ont noté qu'il pourrait être impossible de déterminer si le consentement des populations vulnérables était éclairé, ce qui le rendrait potentiellement sans valeur.

Certains de ceux qui n'étaient pas d'accord ont cependant essayé de faire une distinction entre la recherche universitaire et la manière dont la reconnaissance faciale est utilisée. L'accent devrait être mis sur la condamnation et la restriction des applications non éthiques de la reconnaissance faciale, et non sur la restriction de la recherche, ont-ils déclaré.

Les éthiciens considèrent cette distinction comme naïve. C'est la mentalité du "je ne suis qu'un ingénieur" - et "nous avons largement dépassé ce stade", déclare Karen Levy, sociologue à l'université Cornell d'Ithaca (New York), qui travaille sur l'éthique des technologies.

Certaines personnes interrogées en Chine se sont dites offensées par la question. "Vous ne devriez pas dire qu'au Xinjiang, certains groupes sont détenus dans des camps", a écrit l'un d'entre eux. Un peu moins de la moitié des 47 répondants chinois ont estimé que les études sur les groupes vulnérables pouvaient être éthiquement discutables même si les scientifiques avaient obtenu leur consentement, une proportion inférieure à celle des répondants des États-Unis et d'Europe (tous deux supérieurs à 73 %).

Un chercheur sino-américain en IA qui ne voulait pas être nommé a déclaré qu'un problème était une division culturelle dans ce domaine. "Le nombre de chercheurs chinois participant à des conférences de haut niveau qui soutiennent activement la censure et les camps de concentration du Xinjiang me préoccupe beaucoup. Ces groupes ont un contact minimal avec les médias non censurés et ont tendance à éviter tout contact avec ceux qui ne parlent pas le mandarin, surtout sur des questions sociales comme celle-ci. Je crois que nous devons trouver des moyens de nous engager activement auprès de cette communauté", ont-ils écrit.

Nature a demandé aux chercheurs ce que la communauté scientifique devrait faire à propos des études éthiquement douteuses. La réponse la plus populaire a été que lors de l'examen par les pairs, les auteurs d'articles sur la reconnaissance faciale devraient être interrogés explicitement sur l'éthique de leurs études. L'enquête demandait également si les recherches utilisant des logiciels de reconnaissance faciale devaient être soumises à l'approbation préalable d'organismes d'éthique, tels que les IRB, qui examinent les recherches avec des sujets humains. Près de la moitié des répondants ont estimé que oui, et un autre quart a déclaré que cela dépendait de la recherche.

Réflexion éthique

Les chercheurs qui travaillent sur la technologie qui reconnaît ou analyse les visages soulignent qu'elle a de nombreuses utilisations, par exemple pour retrouver des enfants perdus, traquer des criminels, accéder plus facilement aux smartphones et aux distributeurs automatiques, aider les robots à interagir avec les humains en reconnaissant leur identité et leurs émotions et, dans certaines études médicales, aider à diagnostiquer ou à suivre à distance les participants consentants. "Il existe un certain nombre d'applications légales et légitimes de la reconnaissance faciale et biométrique dont nous avons besoin dans notre société", déclare M. Jain.

Mais les chercheurs doivent également reconnaître qu'une technologie qui permet d'identifier ou de classer des personnes à distance à leur insu est fondamentalement dangereuse - et doivent essayer de résister à l'idée qu'elle soit utilisée pour contrôler ou criminaliser des personnes, affirment certains scientifiques. "La communauté de l'IA souffre de ne pas voir comment son travail s'inscrit dans une longue histoire de science utilisée pour légitimer la violence contre les personnes marginalisées, et pour stratifier et séparer les gens", dit Chelsea Barabas, qui étudie la prise de décision algorithmique au MIT et a contribué à la création du CCT cette année. "Si vous concevez un algorithme de reconnaissance faciale pour la recherche médicale sans réfléchir à la manière dont il pourrait être utilisé par les forces de l'ordre, par exemple, vous faites preuve de négligence", dit-elle.

Certaines organisations commencent à exiger des chercheurs qu'ils soient plus prudents. La conférence NeurIPS (Neural Information Processing Systems), l'une des principales réunions du domaine de l'IA, exige pour la première fois cette année de telles considérations éthiques. Les scientifiques qui soumettent des articles doivent ajouter une déclaration traitant des préoccupations éthiques et des résultats négatifs potentiels de leurs travaux. "Cela ne résoudra pas le problème, mais c'est un pas dans la bonne direction", déclare David Ha, chercheur en IA chez Google à Tokyo. La revue Nature Machine Intelligence teste également une approche dans laquelle elle demande aux auteurs de certains articles sur l'apprentissage machine d'inclure une déclaration prenant en compte les impacts sociétaux plus larges et les préoccupations éthiques, explique Gerstner.

M. Levy espère que les universitaires spécialisés dans la reconnaissance faciale prennent conscience des implications de leurs travaux - et de ce que cela pourrait signifier pour leur réputation s'ils n'éliminent pas les problèmes éthiques dans ce domaine. "C'est comme un véritable réveil dans la communauté scientifique", dit-elle. "Les gens sont plus conscients de la façon dont les technologies sur lesquelles ils travaillent peuvent être utilisées politiquement - et ils le ressentent viscéralement".