Depuis une dizaine d'années, un outil est régulièrement mobilisé durant les périodes électorales : le test électoral. Basé sur une série de questions inspirées des programmes des partis politiques en lice, le test électoral vous indique de quel(s) parti(s) vous êtes le plus proche. Il permet, en un temps court, d’explorer des différences idéologiques, de découvrir des convergences inattendues, ou d’approfondir certains enjeux. Une manière interactive de parcourir, en quelques clics, toute l’offre politique.

Les promoteurs et développeurs de ces outils, à l'instar de la RTBF en Belgique, les décrivent comme des "outils démocratiques" et des "boussoles électorales" dont le but est pédagogique et instructif. Ils viseraient à clarifier les positions des partis, à prioriser les enjeux importants, à réduire l'impact médiatique et à faciliter une prise de décision éclairée. De son côté, pour son test électoral de la présidentielle française de 2022, le Monde rappelle qu'un test "n'est destiné qu'à donner un ordre de grandeur des points d'accord ou de désaccord avec les différents candidats, il ne doit pas être surinterprété.".

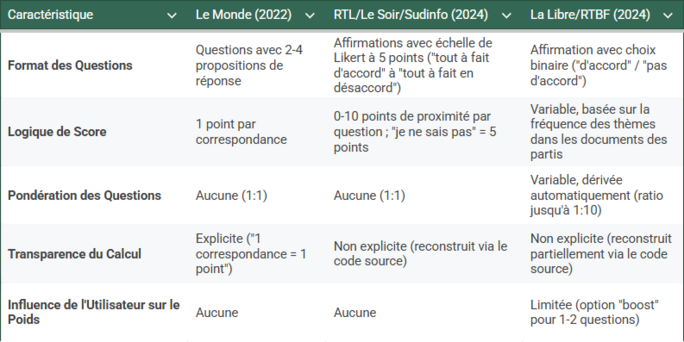

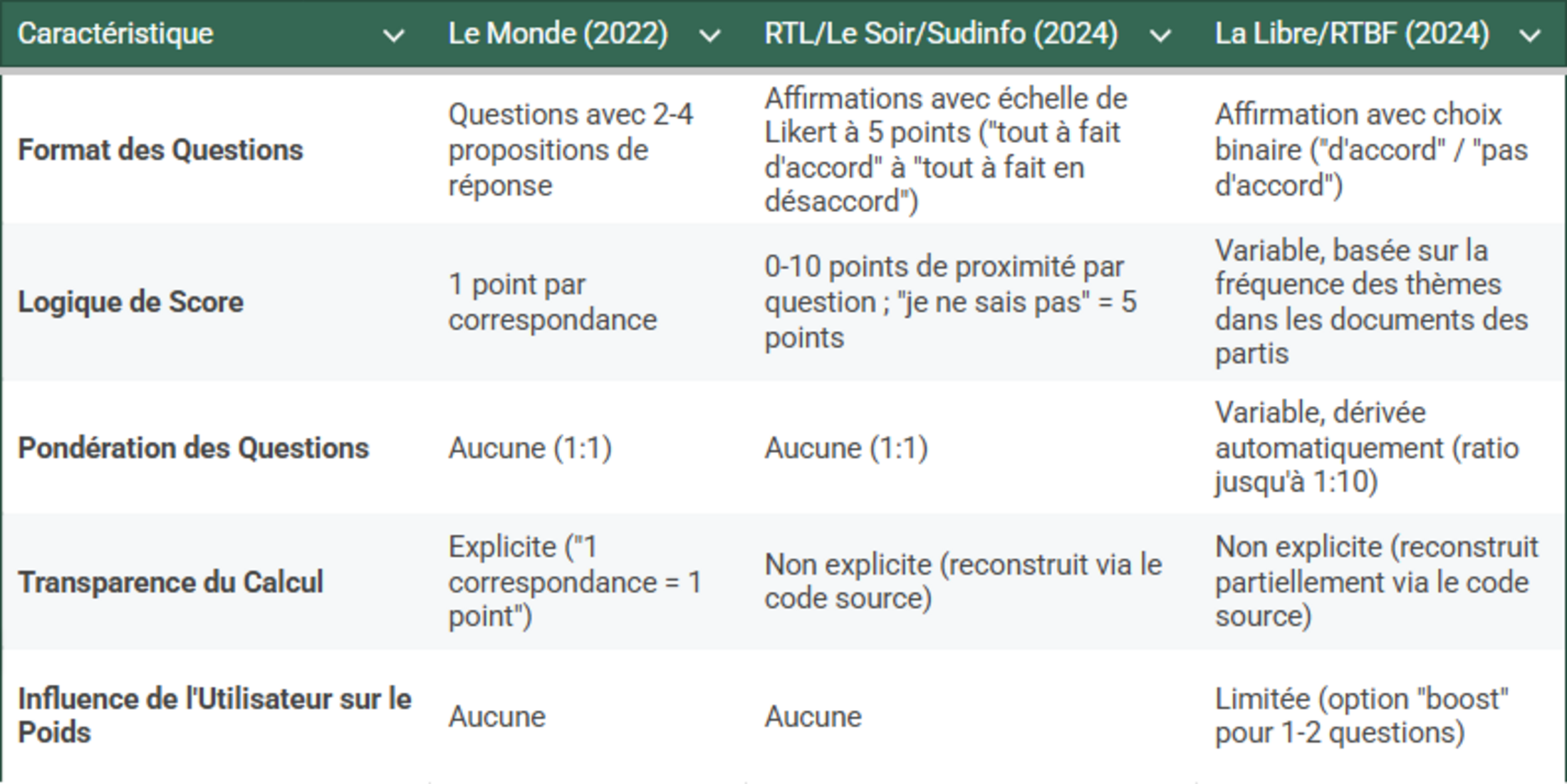

À première vue, cette démarche semble à la fois utile et en dehors du champ habituel de ce blog. Il ne s’agit pas d'un sondage, mais d'un outil personnel, d'une aide à la décision. Alors, pourquoi en parler ici ? Parce que des détails méthodologiques méritent que l’on s’y attarde : le choix, la formulation et surtout la pondération des questions. Comme souvent en méthodologie, ces détails peuvent changer beaucoup de choses. Ce billet défend une idée simple : la transparence est une des conditions de la légitimité des tests électoraux. Pour étudier cela, nous allons effectuer un retour dans le temps pour redécouvrir trois tests électoraux avec trois méthodologies différentes :

- Le Monde (2022) : Ce test concerne les élections présidentielles françaises de 2022 et adopte une méthode minimaliste où chaque correspondance entre la réponse de l'utilisateur et la position d'un candidat vaut un point, sans aucune pondération ;

- RTL / Le Soir / Sudinfo (2024) : Ce test concerne les élections fédérales belges de 2024 et utilise une échelle de cinq propositions pour saisir les nuances d'accord des utilisateurs avec des affirmations politiques ;

- La Libre / RTBF (2024) : Toujours concernant les élections fédérales belges de 2024, ce test utilise une méthode de pondération variable et sophistiquée, où chaque question est pondérée en fonction de la fréquence de mots-clefs dans les documents transmis par les partis.

Une réponse = un point (Le Monde)

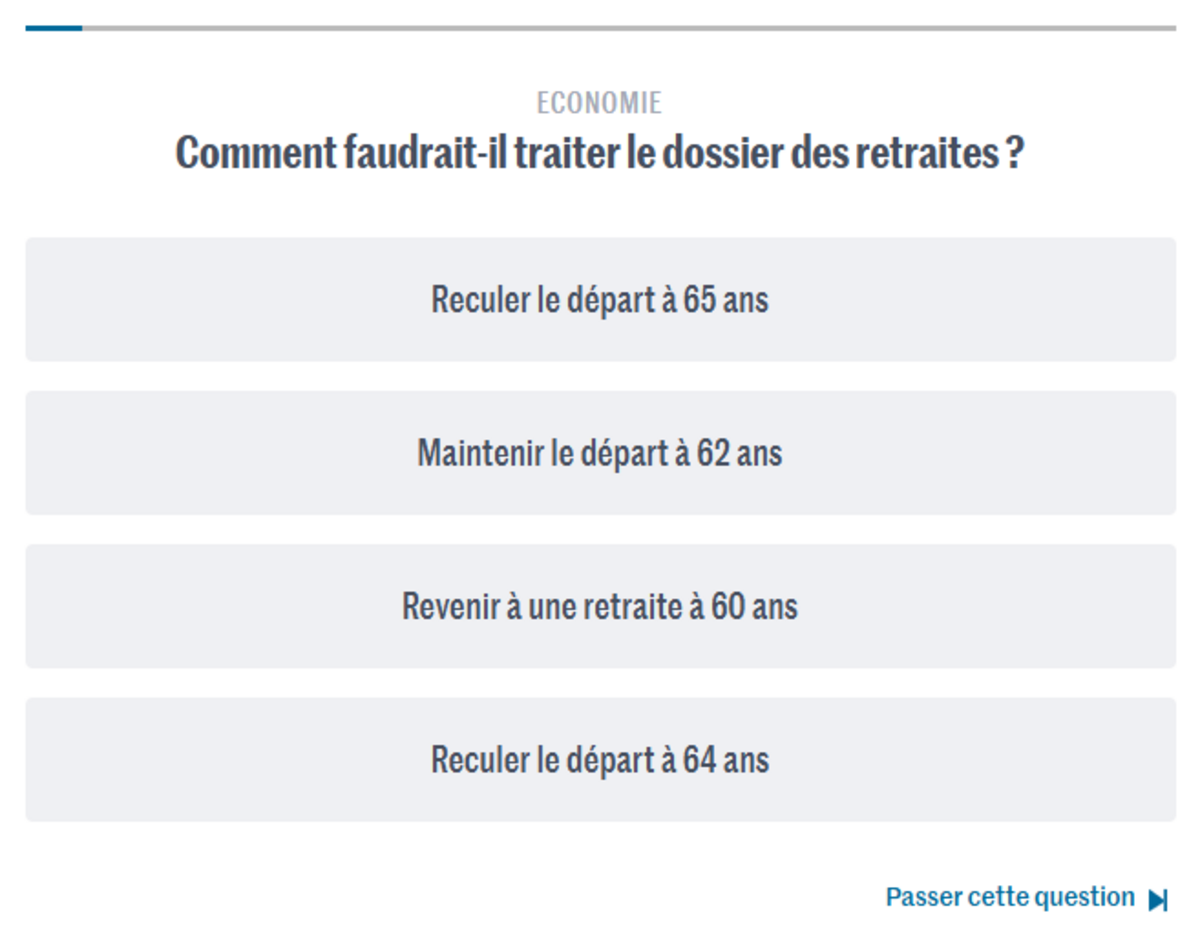

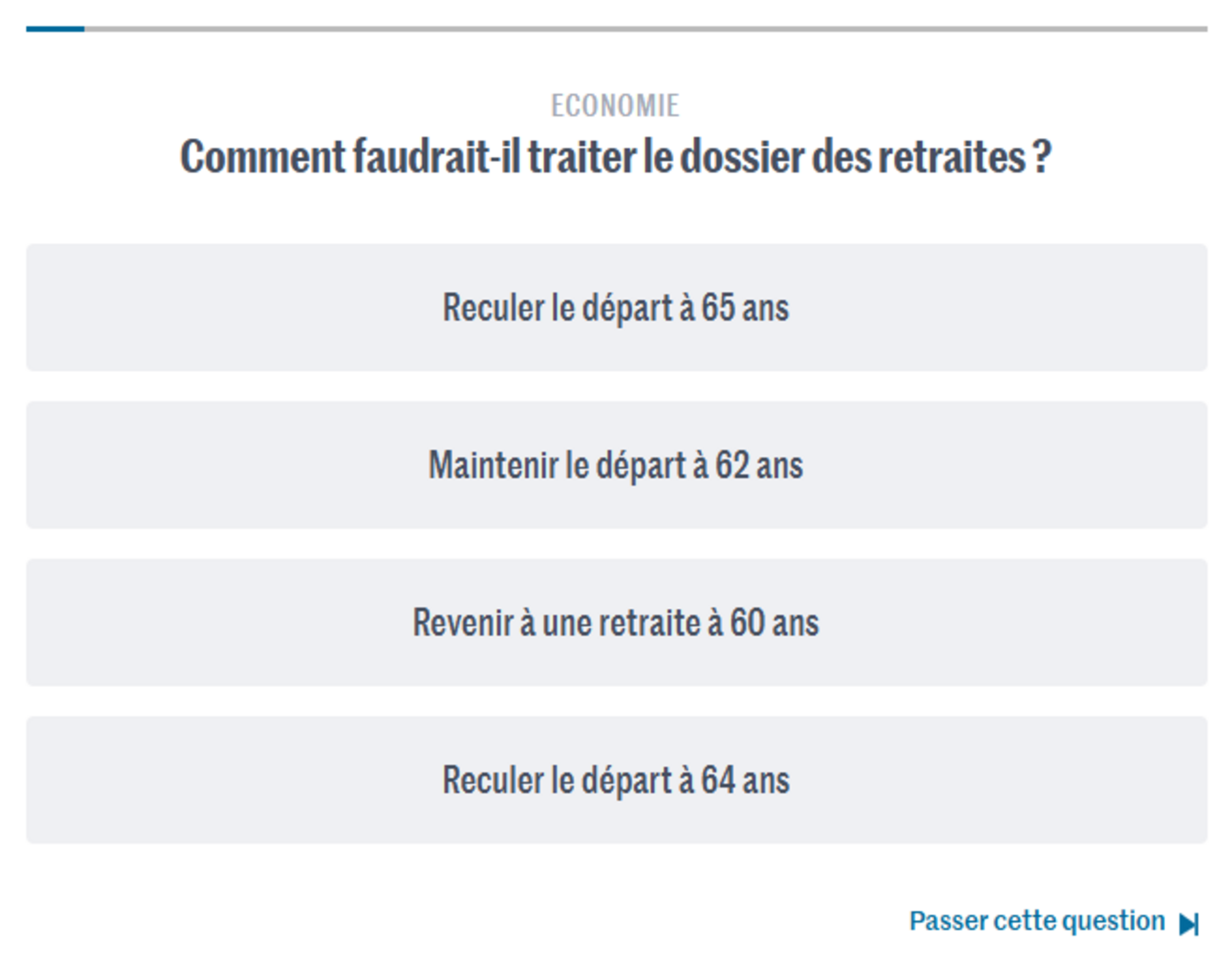

Agrandissement : Illustration 1

Le test proposé par Le Monde lors de l’élection présidentielle de 2022 adopte une approche volontairement minimaliste. Sur la base de son comparateur de programmes, l’utilisateur·rice peut répondre à 20 ou 40 questions, chacune associée à deux à quatre propositions. Chaque réponse est ensuite comparée à celles des candidat·es. Le score final correspond tout simplement au nombre de fois où vos réponses correspondent à celles d’un·e candidat·e. Pas de pondération, pas de calcul opaque : une correspondance = un point. Ce système présente l’avantage d’une parfaite lisibilité. Il est même possible de revoir ensuite vos réponses et comprendre les positions défendues par chaque parti politique.

Mais cette simplicité est aussi sa limite. Une question sur l’âge de la retraite est traitée avec le même poids qu’une question sur la durée du mandat présidentiel. Et aucune place n’est laissée à l’importance relative que vous, citoyen·ne, pourriez accorder à une thématique plutôt qu’à une autre, ni à l'importance relative que le parti politique accorde lui-même à ce sujet. Quant à la sélection des questions, même si le comparateur est public, elle reste un choix éditorial. Certaines thématiques peuvent être sur ou sous-représentées, ce qui influence mécaniquement le résultat final.

Des quelques recherches que j'ai pu effectuer pour l'écriture de ce billet, cette critique semble en accord avec les discussions académiques sur la "saillance des enjeux", c'est à dire l'importance qu'un individu accorde à un enjeu politique particulier. Les papiers de recherche sur les Applications d'Aide au Vote (AAV) traitent souvent de ce problème, et cela ne semble pas aisé à résoudre. Ici, le système "une réponse = un point" ignore fondamentalement cette dimension cruciale, traitant toutes les questions comme si elles avaient une importance égale pour tous les individus et tous les partis.

Vos préférences et celles des candidat·es (RTL / Le Soir / Sudinfo)

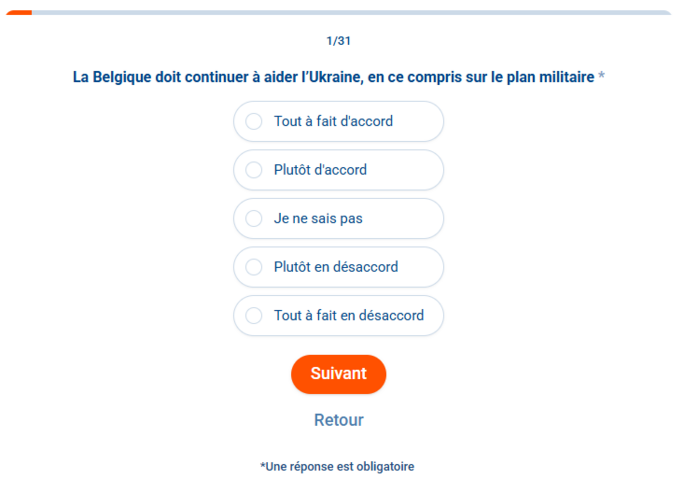

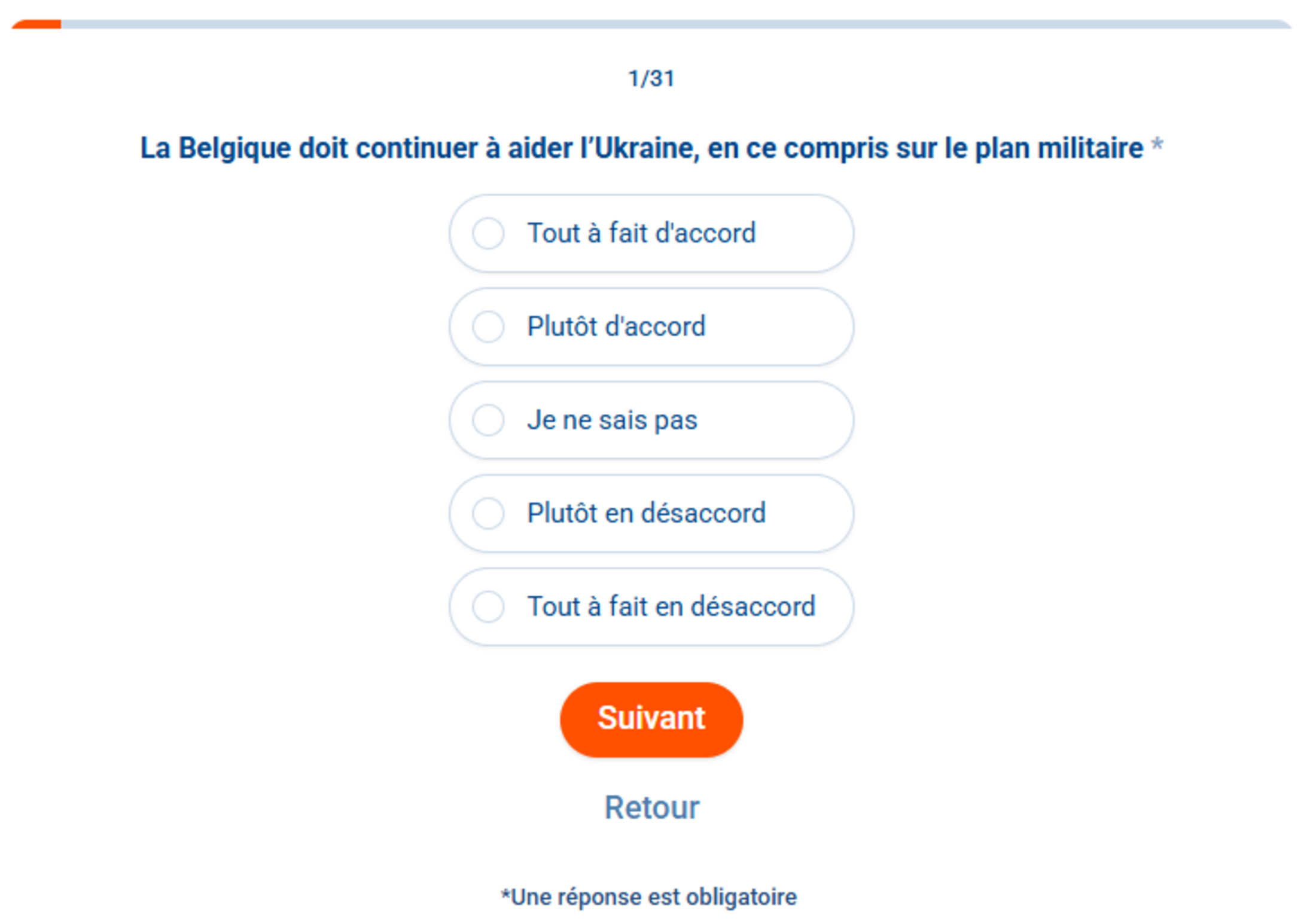

Agrandissement : Illustration 2

Le test développé par RTL Info, Le Soir et Sudinfo pour les élections fédérales de 2024 adopte une approche plus complexe. Ici, nous avons des affirmations auxquelles il faut répondre avec une échelle de cinq propositions allant de « tout à fait d’accord » à « tout à fait en désaccord ». Contrairement au Monde, les positionnements des partis politiques ne sont pas explicités pour ce test électoral. Je suppose que, sur le même format que le Monde, un questionnaire a été envoyé aux partis politiques, et c'est leur positionnement affirmé qui est repris.

La formule de score n’était pas indiqué dans la FAQ du test, mais était accessible en explorant le code source. Chaque réponse donnait entre 0 et 10 points de proximité avec chaque parti, selon un barème dépendant du positionnement du parti. Une réponse "je ne sais pas" rapportait systématiquement 5 points à tous les partis. Les scores à chaque question sont disponibles ici. Vous pouvez refaire le test ici vous-même en voyant la matrice de pondération à chaque question.

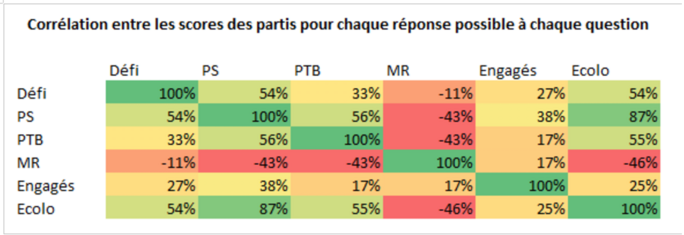

Ce système a le mérite de capter des degrés d’accord, et les partis sont évalués sur la base de leur proximité avec votre position sur chaque affirmation. Certains partis apparaissent plus centristes qu’ils ne le sont (comme le MR), et d'autres ont régulièrement les mêmes réponses (comme le PS et Écolo, avec une corrélation de 87 % dans les réponses). Mais ici, il n'y a toujours pas de pondération présente. Et ces observations de proximité entre les partis peuvent résulter d’une réelle convergence programmatique ou d’un choix de thématiques peu discriminantes. Il n'empêche que cela fait perdre de l'intérêt au test électoral : choisir un parti devient difficile si deux d'entre eux obtiennent systématiquement le même score.

Agrandissement : Illustration 3

Pondérons les résultats (La Libre / RTBF)

Agrandissement : Illustration 4

Le dernier test électoral est proposé par La Libre et la RTBF, en collaboration avec plusieurs universités belges. Pour l’édition 2024, 230 affirmations ont été soumises aux partis, dont une sélection de 35 a été retenue pour constituer le test à destination du grand public. Vous y répondiez par « d’accord » ou « pas d’accord », avec la possibilité de "booster" une ou deux questions (c'est à dire de doubler le score à cette question). Le test n'est plus accessible, mais je l'ai reproduit ici, aussi en explicitant le calcul du score.

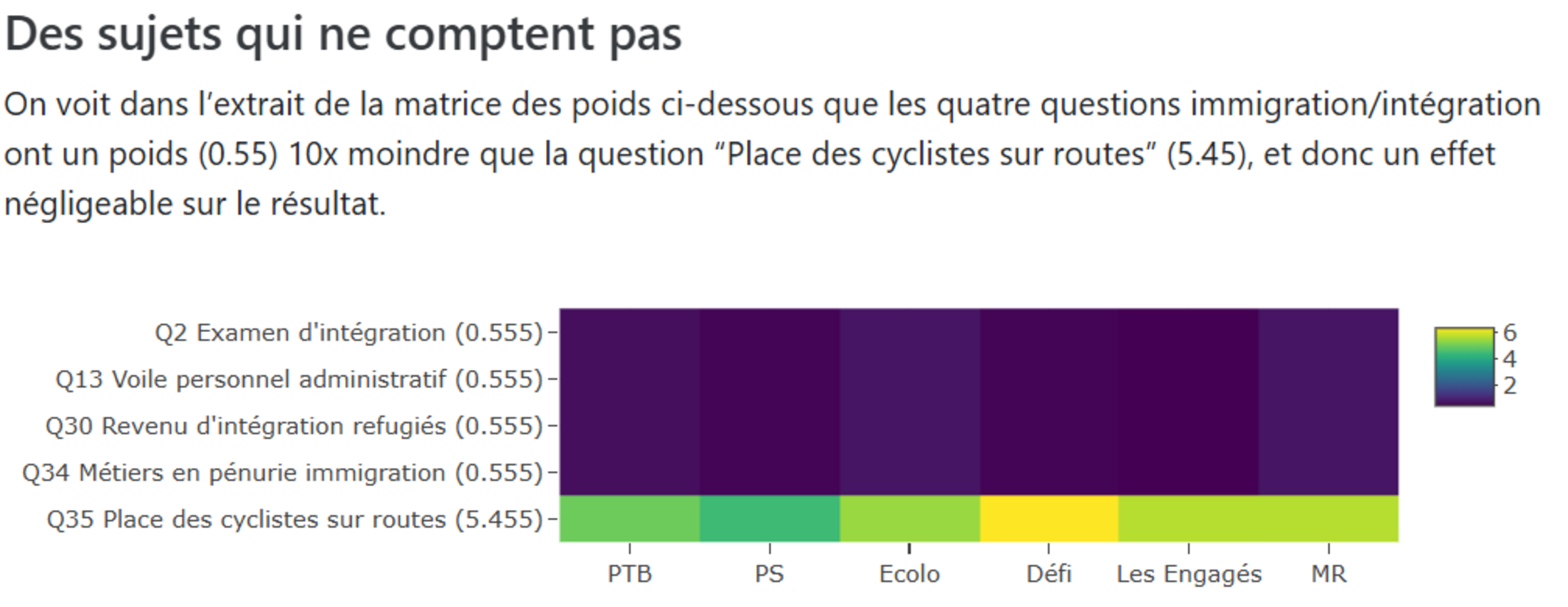

À première vue, ce test ressemble au système simple du Monde. Mais en réalité, il utilise une méthode de score bien plus sophistiquée — et bien plus problématique. Grâce au travail d’Alexandre Irrthum, décrit en détail ici, la méthodologie a pu être reconstruite : chaque question est pondérée de manière variable, en fonction de sa fréquence dans les documents transmis par les partis.

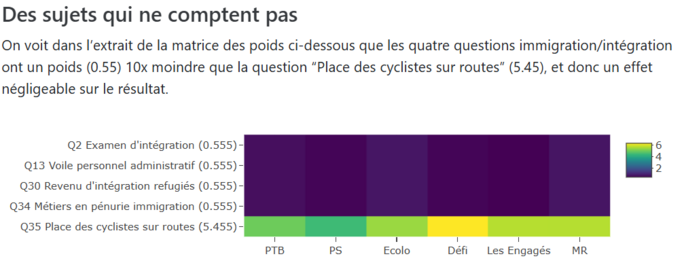

Autrement dit, une thématique évoquée abondamment par un parti dans son programme (ou ses annexes) se verra accorder plus de poids. Une réponse en accord avec le parti sur cette question vous fera donc marquer plus de points que sur une autre. Problème : cela peut aller jusqu’à un rapport de 1 à 10 selon les questions.

Par exemple, la question sur la reconnaissance faciale par la police augmente votre score de 17 points pour le parti politique Défi (34 points en cas de boost), écrasant tout le reste... Et ceci simplement parce que le parti avait fourni un document dense sur la thématique Police/Justice. Ce système introduit une instabilité forte : le classement peut être modifié pour une question pourtant peu présente dans le débat électoral. Aussi, on inverse totalement le phénomène évoqué pour les deux précédents tests électoraux : certains sujets identitaires pouvaient appaître plusieurs fois dans le test et pourtant ne pratiquement pas compter. Et tout cela sans que l’utilisateur·rice n’en soit informé.

Agrandissement : Illustration 5

La méthode de pondération des questions de la Libre et la RTBF est plus sophistiquée mais illustre les dangers d'une automatisation non contrôlée. Si l'intention était de refléter ce que les partis mettent réellement en avant dans leurs programmes, la conséquence est un système facilement manipulable ou sujet à des biais involontaires (par exemple ici, un parti soumettant un document volumineux sur un sujet de niche a influencé de manière disproportionnée son score). Cela met en évidence une lacune critique dans la conception : s'appuyer sur un calcul automatisé sans une surveillance humaine suffisante ou une validation transparente conduit à un "déraillement". De plus, l'opacité de ce test électoral contredit directement l'objectif affiché des AAV en tant qu'outils d'aide à la décision éclairée. Lorsque les utilisateur·rices ne peuvent pas comprendre pourquoi un parti particulier est recommandé, ou comment leurs réponses se traduisent en scores, l'outil perd sa légitimité.

Le papier de Alexandre Irrthum détaille aussi une problématique peu abordée ici encore : la formulation des questions. Cette critique est valide pour les trois tests électoraux présentés et prolonge la critique du choix éditorial des questions : comment considérer qu'un parti politique est d'accord avec une proposition. Parfois, la décision est facile à prendre, parfois elle est bien plus complexe, notamment car répondre "oui" ou "non" a une affirmation est souvent réducteur. Ce problème, indépendant de la pondération des questions, reste primordial lorsque l'accès au programme complet des partis politiques est difficile.

Et les préférences des citoyen·nes ?

Les tests électoraux présentés ici ont été faits du côté du parti politique. Dans les trois situations, hormis avec l'usage du boost (qui doublait le score obtenu pour une question) du dernier test, il n'est pas question ici de préférences des citoyen·nes. Que le sujet de la reconnaissance faciale vous intéresse ou non, le nombre de points attribués aux différents partis politiques sera le même. La seule option ici est de ne pas répondre à la question (je ne sais plus si cela était possible). Un test électoral, conçue pour aider un·e électeur·rice, devrait idéalement refléter les priorités de cet·te électeur·rice. Iel peut se soucier du changement climatique, mais si les partis ne l'élaborent pas de manière extensive dans leurs documents, ce sujet sera sous-pondéré. Inversement, un sujet de niche fortement détaillé par un parti peut acquérir un poids disproportionné. Cela soulève une question lors de la conception des tests : l'outil doit-il principalement refléter l'offre politique (ce que les partis mettent en avant) ou la demande (ce qui intéresse les électeurs)? De ce que je comprends des papiers de recherche sur le sujet, c'est une critique régulière des AAV et les propositions d'amélioration vont dans le sens d'une meilleure prise en compte des préférences individuelles.

Techniquement, cela pourrait impliquer d'indiquer l'importance que l'on donne à chaque sujet (sur une échelle de 1 à 10) avant de répondre, pondérant ainsi la question à la fois selon vos préférences et celles des partis. Néanmoins, cela ne résoudrait pas la problématique du choix éditorial des sujets, ni de formulation des questions ni celle de la classification des positions des partis. Bref, une fois encore, c'est sans doute la transparence, c'est à dire l'accès à toutes les données, agrémenté d'aides à la réflexion, qui rendera ces outils plus robustes. Cela signifie publier non seulement une FAQ générale, mais aussi la méthodologie complète, la matrice de pondération, le code source, et même les réponses brutes des partis. Ce niveau de transparence permettrait aux chercheur·euses indépendant·es et au public de scruter, de valider et de construire la confiance. Étant donné l'usage massif de ces tests électoraux (parfois de manière volontairement orientée), l'enjeu paraît de plus en plus crucial pour les prochaines élections.

Agrandissement : Illustration 6

Conclusion : derrière chaque boussole, une main invisible

La RTBF expliquait en 2024 que le Test Electoral est "un outil démocratique" et "une boussole électorale". En apparence ludiques et simples, ces outils ne sont pas neutres, ils sont traversés de choix méthodologiques qui peuvent changer la hiérarchie des partis selon les règles du jeu choisies. Une question en plus, un poids mal ajusté, un mot-clef mal interprété… et la boussole électorale perd le nord.

Ces tests électoraux ne sont pas sans impact sur les électeur·rices, notamment les plus jeunes. Cela requiert donc un soin tout particulier à chaque étape de leur création. L'absence totale de pondération semble être un choix trop simpliste. À l'inverse, une pondération complexe peut facilement dérailler à cause d'une méthode de calcul automatique non contrôlée, et pourrait aussi à l'avenir être manipulé par les partis politiques eux-mêmes. Le choix des questions, et surtout le choix du positionnement des partis politiques pour chaque question, relève d'un choix éditorial sensible également. Comme le résume Alexandre Irrthum : "il n’y a jamais de méthodologie purement objective". À défaut d’objectivité, la transparence devrait être une exigence minimale, afin que les erreurs soient détectées et corrigées rapidement, notamment avant le scrutin.

Ce n’est pas une raison pour abandonner les tests électoraux. Mais c’est une raison pour les décortiquer, comme on le fait pour un sondage, un taux de pauvreté ou un indicateur économique. Car la question reste la même : qu’est-ce qu’on mesure ? Et comment cela influence-t-il ce que l’on croit savoir ?