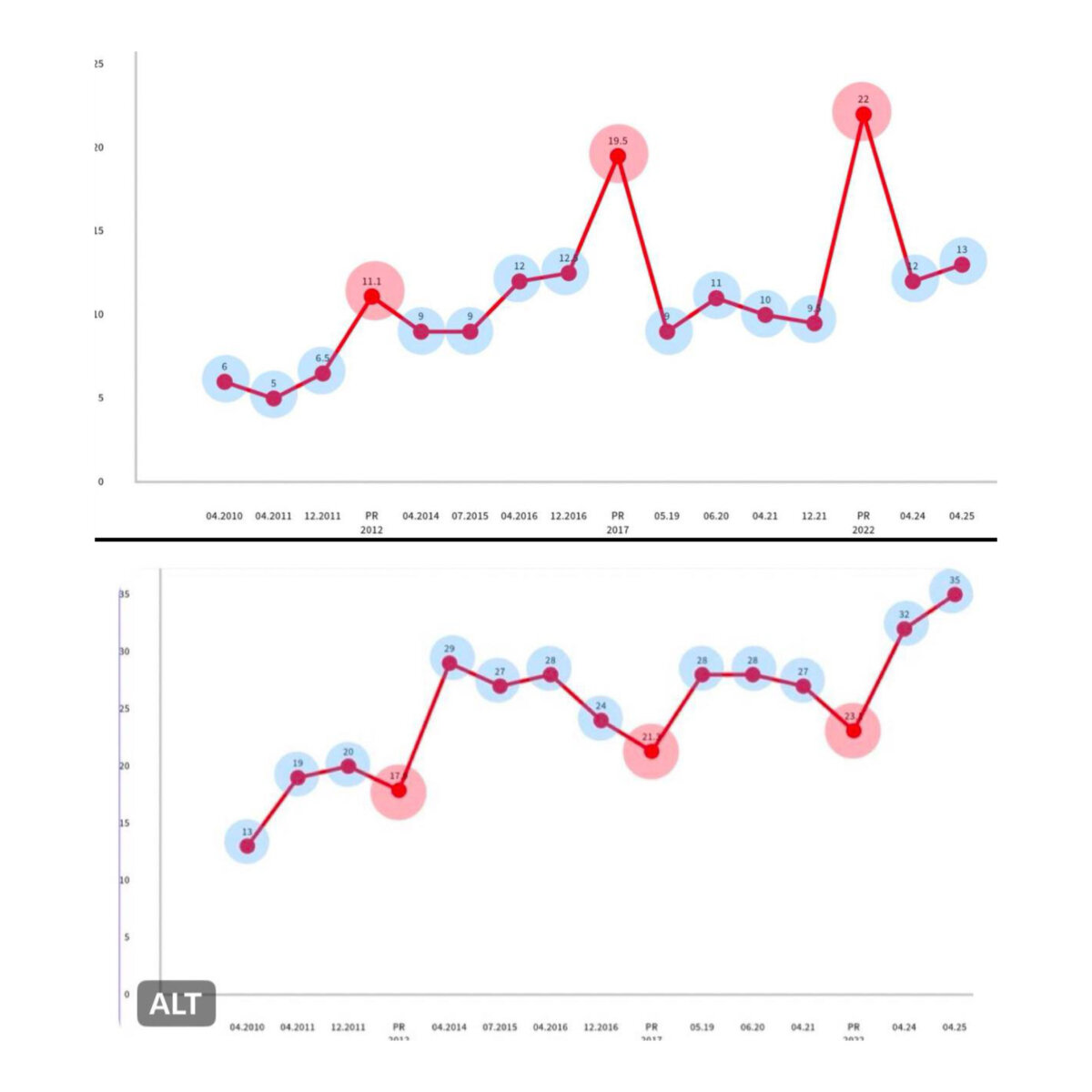

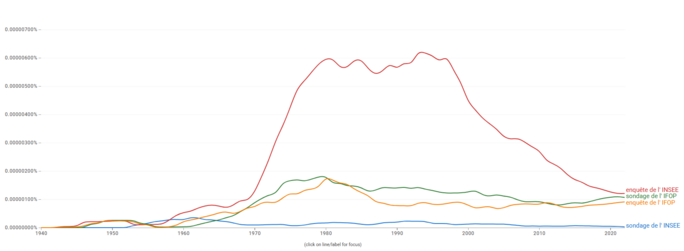

Les sondages d’opinion sont omniprésents dans le débat public et médiatique. À chaque élection ou grande question de société, ils s'imposent médiatiquement avec leurs pourcentages et marges d’erreur, prétendant saisir l’air du temps. Et pourtant, qui n’a pas constaté leur mésaventure récurrente : ces enquêtes se trompent souvent, parfois spectaculairement. Des scrutins majeurs déjouent leurs pronostics, des études affichent des résultats étonnants que la réalité ne vient jamais confirmer. La France Insoumise s'en est d'ailleurs émue récemment en comparant les intentions de votes pour leur parti et celui du Rassemblement National versus la "réalité" des urnes.

Agrandissement : Illustration 1

Ce constat alimente un débat récurrent sur la fiabilité des sondages : erreurs méthodologiques, postulats discutables, voire biais politiques, les critiques fusent. De mon point de vue, il y a un mélange entre les enquêtes, les sondages d'opinion, entre les méthodologies, entre les manières de faire passer le questionnaire. Et tout devient le fameux "1000 personnes pensent que", s'attirant la même popularité médiatique et les mêmes critiques. Avant d'énoncer que « les sondages se trompent tout le temps » (même si je risque de rester sur la même conclusion), il faut toutefois analyser pourquoi et comment ces sondages peuvent se tromper.

Sondage ou enquête ? Un peu de sémantique

Commençons par un petit point qui me semble intéressant pour savoir de quoi on parle, et ce que l'on critique. J'ai le sentiment que l'on parle de « sondage » pour annoncer un chiffre choc, et d’« enquête » pour une analyse plus fouillée, plus sérieuse. Pourtant, ces deux termes ne sont pas interchangeables et la distinction ne se fait pas là.

Techniquement, l’enquête désigne une étude portant sur une population donnée, selon une méthode bien définie. C’est un terme générique, englobant de nombreuses formes de collecte de données : recensement, entretien, observation… ou sondage. Du coup, oui, un sondage est une enquête. Mais une enquête n’est pas nécessairement un sondage. Le sondage est un cas particulier : une méthode d’enquête qui repose sur un échantillon et vise à extrapoler les résultats à l’ensemble d’une population.

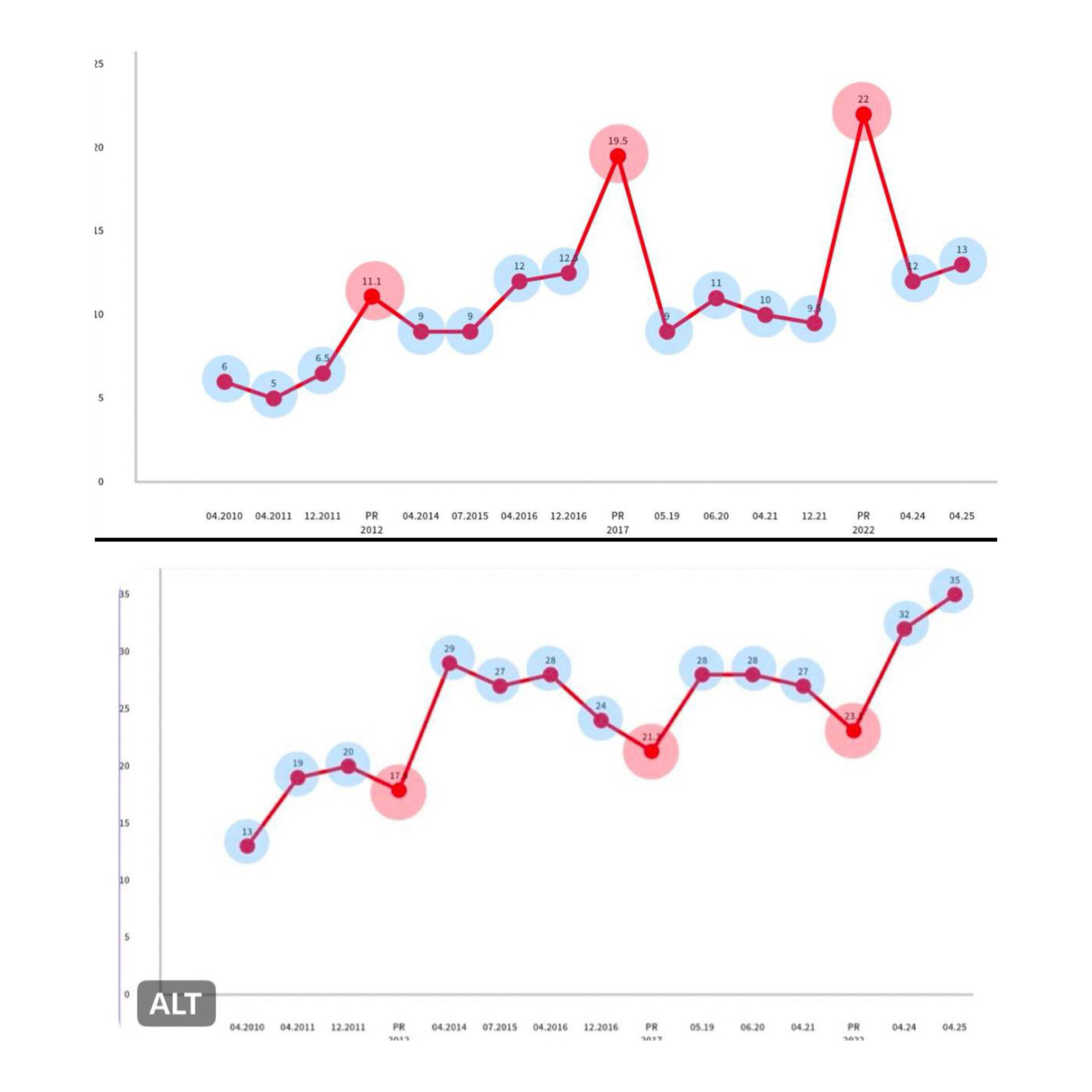

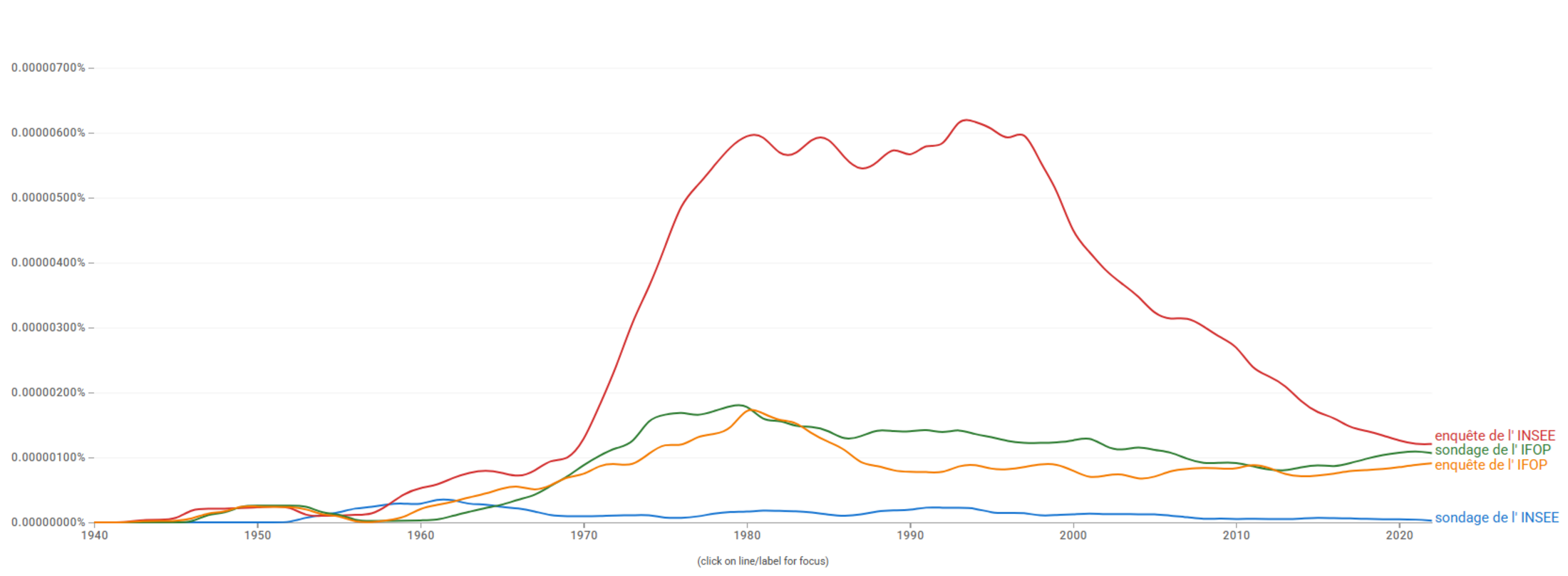

L’INSEE fait des enquêtes. L’IFOP aussi. Les deux font des sondages. Mais dans l’espace médiatique, l’usage révèle autre chose : le mot « sondage » est souvent synonyme d’instantané, d’opinion, de surface. Tandis que le mot « enquête » évoque plus volontiers la profondeur, la durée, la rigueur. Une sorte de noblesse statistique. C’est peut-être pour cela qu’on parle toujours d’un « sondage » quand il s’agit de savoir si les jeunes trouvent acceptable de refuser de s’asseoir là où une personne de l’autre sexe s’est assise. Mais qu’on évoque une « enquête » quand on publie les chiffres de la pauvreté, du chômage ou des inégalités. D'ailleurs, une rapide analyse de google Book ngram donne en effet très peu de résultats pour les sondages avec l'INSEE :

Agrandissement : Illustration 2

Pourtant, les deux reposent parfois sur des techniques similaires — quota, pondération, redressement — et posent les mêmes questions de validité. Ce qui change, ce n’est pas la méthode. Et soit on les distingue pour en valoriser une et décrédibiliser l'autre, soit on les amalgame pour critiquer l'ensemble. Ici, dans ce blog, je continuerai de parler essentiellement des sondages pour ce qu’ils sont : une méthode d’enquête parmi d’autres.

Ce n'est donc pas cela qui fait la distinction entre les bons et les mauvais sondages. Cherchons ailleurs.

Opinion vs. fait : les sondages ne mesurent pas toujours la même chose

Tous les sondages ne mesurent pas les mêmes types de réalités. Un sondage d’opinion vise à capturer un état d’esprit, une intention ou une préférence à un instant donné. Par exemple, demander « Si l’élection avait lieu dimanche prochain, pour qui voteriez-vous ? » relève de l’opinion ou de l’intention, donc d’une donnée volatile par nature. Les opinions évoluent : elles peuvent changer en quelques jours sous l’effet de l’actualité, d’une campagne électorale, d’une conversation, ou même de l'existence d'un autre sondage d'opinion (on reviendra là dessus). À l’inverse, un sondage de faits cherche à mesurer une réalité plus objective ou stable – par exemple « Combien de fois êtes-vous allé au cinéma cette année ? » ou « Possédez-vous une résidence secondaire ? ». Ici, l’information collectée a une existence concrète et ne change pas après coup : si 20 % des personnes interrogées déclarent posséder une résidence secondaire, ce chiffre ne dépend pas de l’actualité du lendemain.

En clair, les sondages d’opinion sont des instantanés mouvants, tandis que les sondages de faits s’apparentent à des photographies figées. En ayant cela en tête, une erreur sur un résultat n'aurait pas la même signification dans les deux cas. Se tromper sur un sondage de faits, c’est généralement un problème d’échantillon ou de sincérité des réponses (par exemple, les gens auraient menti sur leur possession de leur résidence secondaire). Se tromper sur un sondage d’opinion, c’est souvent que l’opinion elle-même a changé entre-temps – ce qui n’est pas vraiment une « erreur » du sondage à proprement parler, mais la traduction d’une dynamique réelle.

Phénomènes invérifiables vs. verdict des urnes

A mon sens, s'arrêter à cela, c'est être très bienveillant envers les sondages. En effet, ici, ce n'est jamais le sondage qui a tort. Au pire, il a été trompé. Si les gens changent d'avis, ce n'est pas de sa faute. On pourrait tout de même questionner son utilité dans ce cas, mais je vais plutôt creuser un autre aspect. Afin de comprendre ces "erreurs", une autre distinction essentielle concerne la vérifiabilité des résultats d’un sondage. Certains sondages portent sur des phénomènes qu’aucune réalité tangible ne viendra jamais confirmer ou infirmer. D’autres, au contraire, prédisent un événement concret dont le résultat servira d'arbitre – c’est typiquement le cas des sondages électoraux confrontés aux urnes, ils se risquent à une prédiction testable.

Parlons d’abord des sondages sur des phénomènes invérifiables. Il s’agit par exemple de sondages mesurant des attitudes profondes, des opinions sans objet concret immédiat, ou des hypothèses. Lorsque, en Belgique, un sondage affichait en une des journaux que « Sept Belges sur dix souhaitent un leader autoritaire », on se trouvait face à un énoncé frappant (repris fortement dans les médias belges) mais impossible à vérifier concrètement. Il n’y aura pas de référendum demandant aux Belges s’ils veulent instaurer une dictature (surtout car le référendum n'existe pas en Belgique). On doit donc se contenter de croire ce que le sondage rapporte, en espérant que la méthode employée soit solide. Le problème, c’est que sans élément de réalité pour valider, le doute plane toujours : que vaut réellement ce « 7 sur 10 » ? Selon la formulation de la question, le contexte de passation, ou l’échantillon interrogé, un autre sondage aurait-il trouvé un résultat différent ? On n’en saura rien de définitif. La seule façon de juger de la fiabilité d’un tel sondage, c’est de le comparer à d’autres enquêtes sur le même sujet (idéalement réalisés par d’autres instituts, avec d’autres méthodes) et de voir si une tendance cohérente se dégage. En somme, pour les phénomènes sans validation factuelle, la convergence des sources, en plus du cadre théorique explicatif, me semble être le seul indicateur : si plusieurs enquêtes indépendantes trouvent des résultats similaires, on gagnera en confiance. Sinon, prudence : un sondage isolé sur un sujet invérifiable doit être pris avec des pincettes.

Petit aparté : en soit, le fait de devoir avoir plusieurs études pour corroborer un résultat est assez antinomique avec la prétention de la théorie des sondages. La loi des grands nombres, et l'extrapolation qu'elle permet, énonce qu'une somme de phénomènes indépendants suit une loi statistique qu'il est possible d'estimer. Ici, un seul sondage, bien mené, serait suffisant pour énoncer un fait. Ici, je propose de confronter un sondage à d'autres (et pas que des sondages justement) pour valider de la qualité de la méthodologie employée. Cela remet en question l'idée que les sondages pourraient, à eux seuls, produire par leur extrapolation une vérité indiscutable. J'essayerai de revenir là-dessus après.

À l’opposé, nous avons les sondages électoraux ou autres sondages prédictifs qui seront tôt ou tard confrontés à une réalité mesurable. Le cas typique est le sondage pré-électoral. Ici, l’institut de sondage prend le risque de publier une estimation de vote avant l’élection, estimation qui sera jugée après coup à l’aune du résultat officiel. On saura dire, le soir du scrutin, si le sondage « s’est trompé » et dans quelle mesure. Par exemple, si un sondage prédisait 52 % pour le Oui et 48 % pour le Non à un référendum, mais que le référendum à des proportions inverses, l’erreur sera évidente et commentée. Ces sondages à verdict différé (élections, référendums, etc.) font du coup l’objet d'analyses a posteriori, et ce n'est pas vraiment en leur avantage. Beaucoup d'erreurs et de biais sont identifié·es pour expliquer que non, les sondages pré-électoraux ne prédisent pas bien l'avenir. Voici les sources d'erreurs et de biais les plus classiques (pour plus d'infos, l'interview de Luc Bronner sur France Inter est très intéressante) :

- Changements d’avis de dernière minute : Un sondage reflète l’opinion au moment où il est réalisé. Or, entre le dernier sondage et le jour du vote, les électeurs peuvent évoluer. Une hésitation se tranche le jour J, un scandale de fin de campagne fait basculer des indécis, ou un candidat crée la surprise lors du dernier débat télévisé. Ces retournements de dernière minute peuvent rendre obsolète une photographie réalisée quelques jours plus tôt. Ainsi, un institut peut avoir prévu juste l’opinion à J-5, et pourtant avoir tort au final parce que l’opinion à J0 (jour du vote) a changé.

- Participation imprévisible : Les sondages d’intentions de vote intègrent toujours une hypothèse sur qui ira voter effectivement. Même s’ils interrogent un échantillon représentatif de la population, encore faut-il savoir quelle part de cette population se déplacera aux urnes. Or, la participation peut varier et surprendre. Un camp très motivé peut se mobiliser plus que prévu (gonflant son score réel par rapport aux sondages), ou au contraire un électorat supposé acquis s’abstenir massivement le jour venu. Pour contrer cela, les instituts de sondages politiques ont pris l'habitude de se limiter aux "personnes sûres d'aller voter". Sur une échelle de 1 à 10 à la question "pensez vous aller voter ?", seules les personnes ayant indiqué le score maximum seront conservées. La variance de l'indicateur est donc plus forte, car il s'agit d'un sous groupe, et l'intervalle de confiance souvent indiqué au début de la notice est donc fausse. On a aucun recul sur ce choix d'être certain d'aller voter. Vont-iels vraiment voter ? Sont-iels représentatives des personnes de l'échantillon ayant répondu 8 ou 9 à cette question de filtre. Nous n'en saurons rien.

- Biais de désirabilité sociale : C’est un phénomène bien documenté des sociologues électoraux : certains électeurs n’osent pas avouer leur véritable choix aux sondeurs, surtout pour les candidatures ou options jugées polémiques ou stigmatisées. Un exemple classique est celui du « vote caché » en faveur de candidats d’extrême droite ou populistes : lors de nombreuses élections, le score réel de ces candidats s’est avéré plus élevé que ne le prédisaient les sondages, suggérant que certains sondés avaient tu leur préférence. D'après les instituts, le passage en enquêtes par web réduirait ce biais, car il serait plus facile d'exprimer sa réelle préférence.

- Échantillon non représentatif ou mal ajusté : C’est la cause plus technique, mais fondamentale, et surtout l'objet régulier de ce blog. Pour qu’un sondage d’intentions de vote colle à la réalité, il faut que l’échantillon interrogé ressemble véritablement à l’électorat. Si certaines catégories de population sont mal représentées, le résultat sera biaisé. Or, nous savons que ces sondages sont toujours effectués avec des access panel, avec un biais de sélection important.

Est-ce que les instituts faisant ce type de sondage réagissent face à ces critiques ? Oui, mais pas forcément comme on pourrait l'imaginer. Actuellement, dans tous les sondages pré-électoraux, une notice méthodologique explique qu'il ne faut pas prendre leurs chiffres comme des prédictions. Il s'agirait d'un instantané de l'opinion publique, et du coup, il rentrerait dans la catégorie des sondages invérifiables ne pouvant pas se tromper. Concernant l'utilité de tels sondages, surtout répétés, surtout médiatisés, on y revient en fin de billet.

Agrandissement : Illustration 3

Et après le scrutin… plus de nouvelles ?

Donc les sondages électoraux seraient des sondages non vérifiables ? En réalité, pas totalement, du moins, il serait possible de tester la qualité d'un tel sondage avec une méthode très simple : recontacter les mêmes personnes sondées avant l’élection, pour leur demander ce qu’elles ont finalement fait et comprendre l’origine précise de l’erreur. "Avez-vous voté A comme vous nous l'aviez énoncé ?", "Êtes vous finalement allé voter ?" Une telle enquête post-électorale, réalisée sur le même panel que le sondage initial, permettrait de s'affranchir totalement de la partie extrapolation. Il n'y aurait plus besoin de parler des français, des belges, mais de se limiter aux panelistes. Et ainsi d'identifier les facteurs d’erreur : changement d’avis, abstention imprévue, mensonge initial, etc. Et éventuellement, s'il n'y a pas de changement de vote, d'imputer la cause de l'erreur à la méthodologie du sondage. Malheureusement, je n'ai jamais trouvé ce genre de validation après coup dans l’industrie des sondages (un collègue me parait récemment de données disponibles avec Science Po, je dois encore aller creuser le sujet). Je peux imaginer la raison : toute erreur non explicable par les changements des panelistes serait alors une erreur d'extrapolation, et je crois que les organismes ne souhaitent pas prendre un tel risque.

Pas de « vérité vraie » hors élections ?

Revenons aux sondages hors contexte électoral, c’est-à-dire tous ces sondages d’opinion pour lesquels il n’y aura jamais de verdict des urnes ou de réalité tranchée. Comme évoqué plus haut, le grand problème est qu’on ne peut jamais savoir avec certitude si ces sondages ont vu juste. Quand un institut annonce que « 65 % des Français pensent ceci » ou « que 14% des Belges sont favorables à cela », on n’a pas de jauge absolue pour valider. Il n’y a pas de grand dépouillement final qui viendra dire "En réalité, c’était 58% et non 65%". Du coup, la seule façon d’évaluer la fiabilité de tels sondages est indirecte et repose sur la comparaison et la cohérence.

Quels conseils donner face à un sondage d’opinion sur un sujet de société ? D’abord, regarder la méthodologie annoncée : taille de l’échantillon, mode de recueil (en ligne, téléphone...), quotas utilisés, date de réalisation, questions posées exactement. Ce sont des indices précieux. Un sondage réalisé sur 2000 personnes via Internet aura, toutes choses égales par ailleurs, une fiabilité moindre qu’un sondage sur 500 personnes avec mix téléphone/terrain. Un questionnaire orienté peut induire des réponses biaisées, et "on ne réduit pas le biais en augmentant la taille de l'échantillon" (Ardilly, 2024).

Ensuite, chercher s’il n’existe pas d’autres sondages ou études sur le même sujet. Si trois sondages récents indiquent tous une tendance proche (par exemple autour de 60-70% d’opinions favorables sur une question donnée), on peut être davantage confiant que l’opinion majoritaire est bien celle-là. En revanche, si un seul sondage sort un chiffre spectaculaire, isolé, il convient d’être prudent : c’est peut-être un outlier, ou un artefact méthodologique. Et encore, si une question débarque dans la sphère médiatique, s'il n'y a pas de réflexion au préalable sur le sujet, l'opinion publique n'existe pas comme le disait Bourdieu, quel que soit le nombre de sondages souhaitant l'attester.

Dans certains cas, on peut croiser les résultats de sondage avec des données observables indirectes. Par exemple, si un sondage prétend que « 80 % des Français s’intéressent à l’écologie », on peut regarder le niveau de participation à des événements liés à l’écologie, le succès des partis écologistes aux élections, etc., pour voir si cela colle plus ou moins. Ce ne sera jamais une validation parfaite, mais cela peut donner du sens. De même, un sondage annonçant « 70 % des Belges veulent un leader autoritaire » peut être mis en perspective avec, par exemple, les scores électoraux des partis autoritaires ou le soutien à la démocratie mesuré par ailleurs (via des études internationales de type Eurobaromètre). Si tout est en contradiction, on peut douter du sondage en question.

L’idée centrale est qu’en l’absence de vérité terrain (comme l’est une élection pour un sondage électoral), il ne faut jamais prendre un sondage pour argent comptant sans un minimum de recul critique. Malheureusement, dans le débat public, ces sondages d’opinion sont souvent brandis comme des arguments d’autorité, sans discussion de leur fiabilité. On voit des responsables politiques ou éditorialistes citer tel ou tel chiffre comme une vérité révélée (« X% des Français pensent comme moi, donc j’ai raison »). Or, sans contrôle possible, ce chiffre n’est qu’une construction statistique reposant sur des hypothèses. D’où l’importance d’insister sur les marges d’erreur et l’humilité dans l’interprétation. Idéalement, chaque sondage d’opinion sur un phénomène invérifiable devrait être accompagné d’une mention en filigrane : « résultat à prendre avec précaution, à confirmer éventuellement par d’autres études ». Cela éviterait de sur-interpréter des variations de quelques points ou de bâtir de grandes théories sur un sondage isolé.

Du coup, seuls les sondages sur les faits sont exacts ?

Après avoir écrit tout cela, on serait en droit de penser que je ne valide "que" les sondages sur des faits, c'est à dire des retours sur les pratiques et actions des personnes interrogées. "Êtes vous parti en vacances l'an passé ?" ou "Quel a été votre revenu net imposable en 2024 ?" seraient les seuls questions susceptibles d'être hors de tout soupçon. En fait, pas vraiment. Même ici, en supposant que la méthodologie du sondage est propre, le sondage peut "se tromper", du moins plusieurs sondages en apparence identiques peuvent donner des résultats bien différents.

Tout récemment, le vidéaste Mr Phi a publié une vidéo sur un dilemme moral ayant secoué le Twitter français. Bien que ce ne soit pas le sujet initial, un résultat très intéressant de son travail porte sur l'impact de la formulation d'une question sur la réponse donnée. En transposant cela aux sondages, on peut craindre qu'aucun chiffre publié ne tienne si on change un peu la manière de poser la question. C'est un des enjeux des instituts de statistiques : conserver des formulations de question similaires ou proches à travers le temps. Ainsi, si l'impact d'une formulation de question est réel, il est aussi supposé être identique à travers le temps. L'évolution d'un indicateur pourrait donc être analysé en ignorant cet effet de cadrage.

Un autre phénomène existe, non dans la formulation de la question, mais dans l'usage de la réponse. Bien souvent, on construit un indicateur à partir de plusieurs réponses, et c'est la proportion de personnes concernées par cet indicateur qui va être analysé. Le taux de pauvreté selon la définition d'Eurostat, c'est d'abord une somme de tous les revenus disponibles par le ménage (déclarés ou non), une division par une taille de ménage (1 point pour le premier adulte, 0.5 pour les adultes suivants, 0.3 pour chaque enfants), un calcul de médiane de ce résultat, un calcul de 60% de cette médiane, et enfin de constater si le revenu équivalent moyen du ménage est inférieur ou non à ce seuil de pauvreté. Ce calcul est discutable (et discuté), et toute modification d'un paramètre vient affecter l'indicateur, donc la réalité sur la pauvreté. De même dans l'enquête sur la volonté des belges d'avoir un leader autoritaire, l'indicateur de "retribalisation" est un agrégat de toute une série de question. L'inconvénient de cette étude (un parmi d'autres) est que la formule de calcul n'est ici pas explicitée. Il est donc impossible d'estimer la sensibilité des résultats à chaque étape de calcul.

Conclusion : Des chiffres à manier avec précaution

En conclusion, affirmer que « les sondages se trompent tout le temps » est volontairement provocateur, mais veut juste porter l'attention sur ce que signifie le fait d'avoir eu raison. L'idée vient de la réflexion que les sondages pré-électoraux sont vérifiables, et le billet est parti après dans beaucoup d'autres direction. Entre la nature même de ce qu’ils mesurent (opinions changeantes vs faits établis), les difficultés méthodologiques (échantillons, quotas, panel en ligne, etc.), la construction des indicateurs pour consolider les réponses et les présupposés qu’ils véhiculent, les sondages sont loin d’être infaillibles. Les sondages réalisés par les instituts de statistiques publiques ne sont en dehors de ces critiques, même si un aspect les rend meilleur à mon sens : la transparence. L'ensemble des résultats sont publiés chaque fois qu'une enquête est réalisée (et pas seulement si les résultats arrangent tel ou tel), la méthodologie est publiée et respecte une série de principe (du moins essaye), et l'ensemble des chercheur·euses universitaires ont un droit d'accès aux données brutes, afin de creuser les résultats et d'en identifier les failles.

La conclusion ne change pas trop des billets précédents, la prochaine fois que vous lirez un gros titre assurant que « X% des Français pensent ceci » ou qu’un sondage prédit le vainqueur de l’élection à venir 4 ans avant, souvenez-vous de tout ce qui précède. Interrogez la méthode, cherchez la marge d’erreur, demandez-vous si une validation est possible ou non, et quel usage on fait de ce chiffre. Et si ce n'est pas bon, le résultat n'a pas besoin d'être discuté ensuite, ou si, pour comprendre pourquoi les sondé·es ont répondu ceci, et non pourquoi les belges pensent ceci.