Cet article s'inscrit dans une série sur l’intelligence artificielle que je publie, faisant suite à ma participation à l'émission « Les Grands Entretiens » sur Mediapart.

Article précédent : # 3 - Mécanismes proto-discriminatoire face aux intelligences artificielles

Dans ce chapitre, je vais essayer de vous présenter un pan idéologique et politique particulier qu'on retrouve autour de l'intelligence artificielle. Il s'agit d'un ensemble de mouvements qui évoluent autour de certains domaines techniques et scientifiques.

Mieux comprendre ce paysage, le comprendre sérieusement, avec ses caractéristiques politiques, ses potentielles erreurs, ses spécificités, son histoire, ses communautés, etc. Ceci, sans réductionnisme, sans le traiter comme une fiction ou le tourner en ridicule...

Tout cela me semble aujourd'hui une étape nécessaire dans une couverture rigoureuse de l'intelligence artificielle.

Voici une liste des points que j'aborderai :

- Un paysage idéologique

Comment s'agencent ces différents mouvements ? Qu'est-ce qui les relie ? Qu'est-ce qui les sépare ?

- Le cadre probabiliste

Introduction du cadre probabiliste

- Les Rationalismes

Analyse de différents mouvements rationalistes

- Les Transhumanismes

Analyse de différents mouvements transhumanistes

- Clivages politiques

Présentation et critique de plusieurs clivages, leurs forces et leurs limites

- La gauche et la droite

Suivre les cheminements de la gauche, les potentielles directions futures

Allons-y !

Le paysage idéologique

Agrandissement : Illustration 1

Il existe dans le domaine des sciences et technologies, plus particulièrement dans le cercle de l'intelligence artificielle et de l'informatique théorique, un ensemble d'idéologies particulières et influentes.

Les comprendre dans leur singularité et sous différents prismes (historique, pratique, leadership, idées, environnement, projection sur la ligne politique usuelle, etc.) est important. Cela nous permettra de mieux appréhender les motivations non capitalistiques de plusieurs acteurs majeurs de l'intelligence artificielle. Ces schémas idéologiques peuvent, dans certains cas, être des motivations plus grandes que celle du profit.

J'explique ici certains chemins qui peuvent amener vers ces idéologies des personnes souvent avec un profil technique, scientifique ou ayant été en contact avec des disciplines dites "quantitatives".

Ceci sera un prisme incomplet, je ne vais pas par exemple traiter en détails les origines historiques ou les profils influents dans les nombreuses communautés autour de ces idéologies. Je vous invite, si le sujet vous intéresse, à lire des sources sur les autres aspects que je n'aurais pas traités ou peu approfondis.

Néanmoins, cet article a, je l'espère, la vertu de donner une vue globale informative sur ce que les personnes appartenant ou sympathisant avec l'une des idéologies traitées pensent, et quel est le chemin intellectuel qui les y a menées.

Dans la suite de ce texte, je vais utiliser le terme imparfait de "profil quantitatif" pour décrire des personnes ayant fait des études sur des sujets scientifiques ou techniques, ou s'y étant intéressées de manière autodidacte. Cela couvre des analystes, techniciens, ingénieurs, professeurs, chercheurs dans des domaines de science, technique, philosophie analytique, épistémologie, etc.

Classification

Je vais commencer par présenter deux groupes d'idéologies. Ils ont ceci de particulier qu'ils sont profondément différents, tout en partageant des voisinages communautaires et en étant pratiquement et sociologiquement proches.

Ces deux groupes n'ont pas le même objectif fondateur, voire leurs objectifs sont relativement opposés dans un certain sens. Alors qu'il y a une intersection importante entre les communautés militantes et dirigeantes de ces deux groupes. Je traiterai dans la suite les idéologies suivantes en me référant à leur groupe comme tel :

- Les transhumanismes :

- le Transhumanisme

- l'Extropianisme

- le Singularitarisme

- le Cosmisme

- Les rationalismes :

- le Rationalisme

- l'Altruisme efficace

- le Long-termisme

Dans les publications qui traitent de ces idéologies, vous trouverez parfois l'ensemble présenté comme une vision unique avec différentes branches. Cela est principalement dû aux liens concrets qui les unissent :

- les sources de financement

- les figures majeures

- les thèmes et les sujets traités

- la sociologie des groupes impliqués

- le contexte communautaire

- les croisements idéologiques

Cet ensemble est ainsi décrit sous le nom de TESCREAL, acronyme anglais de { Transhumanism - Extropianism - Singularitarianism - Cosmism - Rationalism - Effective Altruism - Longtermism } proposé par Timnit Gebru et Émile P. Torres. Néanmoins, il me semble que négliger la dimension idéologique spécifique de chacun de ces mouvements ne nous permettra pas de comprendre leur évolution et leur interaction avec les communautés scientifique et technique non militantes, d'où une approche différente.

Les idéologies transhumanistes sont d'abord un rêve d'évolution orienté vers soi, un ensemble "d'améliorations" qui cherchent à "transcender" la biologie, la génétique, l'intellect, le physique, la condition humaine, voire la mort elle-même. Elles sont ainsi avant tout des idéologies dirigées vers "l'augmentation" de l'individu humain, c'est-à-dire que leur projet commence par une quête individuelle de puissance, de bonheur, d'intelligence, de pouvoir, de jeunesse etc. Cela dit, il faut garder à l'esprit que ces idéologies évoluent dans plusieurs directions. Leur point de départ ne nous dit pas tout.

Les rationalismes, eux, peuvent être vus comme des recherches du "bien" et de la "vérité". Ce sont des mouvements qui ont cherché comment mieux réfléchir, mieux débattre, et surtout mieux faire du "bien", notamment sur des sujets de société, d'environnement, de pauvreté, d'inégalités, de politique, de science, etc. Les rationalismes sont ainsi traversés par des questions sur les prises de décision :

- Vers quoi voulons-nous aller ?

- Comment y aller ?

Le cadre probabiliste

Agrandissement : Illustration 2

Avant de présenter les différentes idéologies rationalistes, je vais commencer par vous placer dans le cadre intellectuel qui est souvent - et actuellement - le point d'entrée de nombreuses personnes, souvent de profil scientifique ou technique, dans les nouvelles idéologies rationalistes, voire aussi transhumanistes.

Supposons que vous avez le choix entre deux possibilités A et B :

- Prioriser le secteur A ou B

- Financer l'énergie A ou B

- Donner une aide au pays A ou B

- allouer un budget pour la cause A ou B

- Lancer des recherches sur le sujet A ou B

- etc.

Pour faire vos choix, vous décidez d'organiser vos pensées ainsi :

Décider de l'alternative à choisir en fonction d'un "objectif" que vous vous êtes fixé qui va concerner des personnes, des êtres vivants, des entités (espèces, écosystèmes, monuments historiques, œuvres artistiques ou scientifiques, etc.). Cet objectif va donc jouer un rôle fondamental dans votre approche, car il est censé résumer et contenir vers quoi vont aller vos actions.

Ce cadre est souvent généralisé à l'ensemble des décisions à prendre pour une personne, chaque "action" est ainsi sélectionnée en fonction de ce "critère".

Dit dans d'autres termes, chaque "action" est "politique", je veux dire par là qu'elle est choisie pour un objectif plus global.

Si vous êtes familier avec les algorithmes d'apprentissage, il ne vous aura pas échappé une certaine analogie avec le cadre usuel de l'apprentissage machine par renforcement :

- une fonction dite "Policy" pour les choix

- un "objectif" à atteindre ou à s'en rapprocher

C'est ainsi que plusieurs modèles de décision peuvent voir le jour, je vais en donner quelques exemples pour mieux vous permettre d'imaginer comment cette vision s'incarne concrètement :

- Minimiser le nombre de morts pour l'ensemble des êtres humains

- Minimiser la souffrance moyenne des êtres humains

- Maximiser la connaissance humaine pour au moins un être humain

- Maximiser la survie de l'espèce humaine

- Maximiser le bonheur des êtres vivants

- Maximiser l'espérance de vie des mammifères

- etc.

Si maintenant vous passez du temps à réfléchir à travers ces prismes - ainsi que d'autres exemples que vous pouvez imaginer de votre côté - vous commencerez à avoir une meilleure intuition des limites et des forces de ces modèles, mais surtout vous aurez une idée des erreurs potentielles qu'une personne peut faire en mal interprétant ce cadre.

Par exemple, il faut garder à l'esprit qu'un objectif comme "minimiser le nombre de morts pour l'ensemble des êtres humains" peut tout à fait conduire à construire une université plutôt qu'un hôpital :

L'université peut, dans certaines conditions - exemple : s'il y a déjà beaucoup d'hôpitaux et peu de médecins - sauver plus de personnes qu'un hôpital, même si cela ne se fait pas de manière aussi directe.

Il n'est donc pas un modèle qui simplifie les choix, ce cadre permet simplement une description générale, floue et incomplète de la réflexion qui permet le choix. Beaucoup des éléments clés restent ouverts.

Parmi ces différents objectifs, il y en a qui peuvent être rattachés à des philosophies particulières, comme par exemple le fait de minimiser la souffrance des plus souffrants parmi les êtres humains, ou des objectifs qui prennent aussi en compte la vie d'autres êtres vivants, la souffrance animale, etc.

Cette manière de penser met au centre plusieurs éléments qui seront par la suite au centre des rationalismes :

- L'incertitude

- La raison

- Le futur

L'incertitude

À travers ce prisme, il est essentiel d'avoir une vision probabiliste du monde, étant donné que les choix sont rarement exacts :

On peut savoir qu'un hôpital sauve approximativement un certain nombre de personnes en moyenne avec une certaine marge d'erreur, mais on ne peut généralement pas savoir combien il va en sauver exactement.

La raison

Ce cadre nous impose aussi de bien manipuler ces mêmes incertitudes (les combiner, les transformer selon les règles de la "raison" / la "logique"), ce qui nous amène vers la théorie des probabilités, et plus particulièrement les inférences statistiques et bayésiennes, avec souvent des estimations des causes à travers les conséquences observées.

Ces théories jouent ici le rôle d'une logique flou, adaptée à tous les sujets qui ne relèvent pas d'une science exacte

Le futur

Ce point complexe sera à l'origine de nombreuses dérives dans ces nouvelles idéologies :

- Comment choisir entre le même objectif au présent et au futur ?

- Comment pondérer des vies sauvées dans 10 ans, 100 ans, voire 10 000 millions d'années, et celles sauvées dans une heure ?

Cette question, malgré sa complexité, trouve une réponse assez convaincante à mon sens. Il nous est possible de donner à la vie la même valeur à travers le temps sans que cela pose un problème clair au sein du modèle, quand la comparaison est exacte. Je vais essayer de mieux expliquer cela.

Le premier point à comprendre est qu'une vie sauvée dans une heure peut elle-même en sauver d'autres par la suite ; si tel est le cas, alors ce n'est pas la question qui est posée.

Ici, on compare deux alternatives : dans l'une, on a une vie sauvée dans une heure (et rien d'autre), dans l'autre, une vie sauvée dans le futur (et rien d'autre). C'est bien sûr une question théorique, dans la pratique, une vie sauvée a d'autres conséquences, mais ce n'est pas la question qui est posée.

Le second point contre-intuitif est que, dans la question, la vie sauvée au présent et au futur est une certitude. En pratique, on est très rarement aussi sûr de sauver une vie dans 10 ans que celle dans une heure.

Là aussi, il faut prendre la question théorique telle qu'elle est, c'est-à-dire que nous comparant des vies sauvées avec la même certitude ; autrement, nous pourrions être induits vers des problèmes majeurs à la fois pour comprendre ces idéologies et surtout au sein même de ces idéologies.

Un "future" particulier ne diffère ainsi du présent dans ces modèles que par les chances d'advenir (en général, plus on s'éloigne du présent, plus elles sont faibles) et par une consécution plus faible que celle du passé (les événements n'affectant que leur futur, plus ils sont loin dans le futur, plus ils ont moins d'impact).

Outillage

Maintenant que nous avons mis en place le cadre et les notions qui lui sont souvent attachées, nous serons mieux équipés pour bien mieux comprendre ces idéologies, ainsi que leurs potentielles failles

Car à travers ce cadre, de nombreuses idéologies se sont développées, les profils scientifiques ou quantitatifs peuvent ainsi porter ces idées sans s'inscrire dans leur histoire. Ils se retrouvent ainsi indirectement "représentés" par les personnes et des structures influentes qu'ils ne connaissent parfois même pas.

Critiques

Ce cadre est souvent critiqué pour de nombreuses raisons, je vais essayer d'en explorer avec vous quelques-unes.

"C'est des opinions déguisées en science"

Parfois, ce cadre est vu comme une justification d'estimations subjectives des probabilités, des opinions déguisées en mathématiques. Il lui est aussi reproché, en ce sens, des prédictions hasardeuses des événements futurs.

En réalité, cela est dû au formalisme mathématique qui accompagne souvent ce cadre, et il est bien évident que les idées ainsi énoncées ne sont en général pas — loin s'en faut — des mathématiques. C'est un modèle suffisamment flou pour discuter en des termes mathématiques de politique, de social, d'économie, etc. Seule la forme ici est mathématique car elle sied aux profils concernés, il ne doit pas être pris pour plus que ce qu'il est.

C'est donc souvent des opinions que je dirais habillées plutôt que déguisées en mathématiques, ce n'est pas vraiment caché, ce sont des estimations sujettes à l'incertitude, aux biais et aux erreurs.

Les personnes qui prétendent que leurs idées sont "correctes" parce que reformulées en "science" trompent indéniablement leur interlocuteur.

En intelligence artificielle, en science ou ailleurs, dire quelque chose dans un langage technique ou particulier ne la rend pas forcément vraie.

"C'est une pensée arriviste"

Le souci relevé ici est que la terminologie "d'objectif" fait en sorte que beaucoup de personnes peuvent penser que c'est une idéologie arriviste sans autre considération.

Or, les objectifs peuvent varier d'une personne à une autre, et cela peut avoir un impact du tout au tout sur les conclusions du modèle.

Si votre objectif cherche à défendre les intérêts d'une "race" contre les autres, vous êtes d'extrême droite.

Si votre objectif cherche à diminuer la souffrance de toutes les espèces, vous êtes probablement antispéciste.

Etc.

Cette critique est donc à prendre comme une critique d'un objectif ou d'un ensemble d'objectifs plutôt que du cadre lui-même.

"C'est une pensée mécanique"

La formulation presque algorithmique de ce cadre est souvent sujette aux critiques ; elle est vue comme une mécanisation de la politique et de la morale, une quantification de la "vie".

Cette critique s'adresse au cœur du modèle, je pense que ce qu'elle pointe est en partie légitime. Ce formalisme peut avoir comme limite fondamentale cette vision de la morale et de la politique, étant donné que c'est une des raisons pour lesquelles des personnes l'utilisent.

En effet, le but est de construire une feuille de route, un "algorithme" suffisamment flou et malléable pour pouvoir traiter de sujets non techniques en opposition aux sciences formelles, ce qui inclut les sujets sociétaux, moraux, politiques, économiques, etc.

Dans un sens, ce cadre est un prisme pour voir le monde et prendre des choix/actions ; il est donc nécessairement incomplet :

- Il permet de mieux séparer les objectifs d'un côté et le chemin pour y arriver de l'autre, de mieux organiser le traitement des incertitudes, des corrélations, etc.

- Cette séparation/dissection peut produire une impression de vide et de manque de goût aux choix politiques ou sociaux, de donner une illusion de mathématisation absolue de la "vie".

À mes lecteurs

Je suis particulièrement curieux d'entendre les autres remarques, critiques ou défenses de ce cadre que je n'aurais pas, peu, ou mal couvert.

J'encourage ceux d'entre vous qui souhaitent me faire ce partage - ou sur autre chose qui vous intéresse - à me contacter soit par message sur Médiapart, soit sur Twitter, ou à travers mon mail :

> ansar.add.contact [ arobase ] gmail [ point ] com

Attrait pour les profils "quantitatifs"

Agrandissement : Illustration 3

Plusieurs caractéristiques justifient la popularité de ce type de modèle chez des profils scientifiques ou techniques à la fois pour les rationalismes, et, dans une moindre mesure, pour les transhumanismes :

- Spécifie les erreurs : les erreurs sont ainsi classées en fonction de la partie du modèle qu'elles couvrent (désaccord sur l'objectif, erreur de probabilité, différence d'information utilisée, mauvaise quantification d'incertitude etc.).

- Les paramètres libres permettent de couvrir/modéliser de nombreux comportements politiques (choix des entités valorisées, choix de l'égalité ou de l'inégalité, etc.), ce qui permet une schématisation générale de la politique.

- Donne une impression d'algorithmiser la politique, de l'automatiser, de la comprendre de manière scientifique.

Cela ressemble à l'attrait que peut avoir la théorie du choix social (théorie mathématique de la décision des groupes et de la démocratie), c'est une modélisation d'une partie de ce qui se fait en politique, ce qui semble à première vue - pour une science formelle - hors d'atteinte.

Cela vient avec son lot d'illusions et d'erreurs communes, analogues à ce qu'on peut voir dans d'autres domaines de modélisation du réel, par exemple :

- Les mauvais usages de modèles, comme on en trouve souvent en économie.

- Une fausse impression de contrôle ou de réductionnisme technique.

À partir d'ici, plusieurs chemins peuvent être pris, dont certains conduisent aux idéologies nouvelles dont nous allons parler par la suite.

J'estime que cette introduction est nécessaire pour comprendre les nouvelles problématiques idéologiques en intelligence artificielle. Ne pas prendre en compte comment concrètement les personnes peuvent porter ces idées si particulières est, à mon sens, une faille importante dans de nombreuses analyses que j'ai pu lire.

Les Rationalismes

Le rationalisme

Agrandissement : Illustration 4

Tout d'abord, je ne parle pas du rationalisme de Kant, Descartes, etc. Ici je parle d'une idéologie plus récente (~ 2009) souvent incarnée par la communauté autour du site lesswrong.com

Les rationalistes sont des personnes qui cherchent à améliorer le raisonnement, à l'instar des zététiciens. Comme souvent, les définitions de ces idéologies sont floues.

Plus concrètement, les rationalistes sont un mouvement qui a réussi à attirer beaucoup de profils quantitatifs qui souhaitaient appliquer des principes de mathématiques, de probabilités, de sciences en général de manière plus approfondie. Ce mouvement est centré autour du moteur de blog lesswrong.com.

Des sujets particuliers sont régulièrement traités comme la conscience, l'épistémologie, les paradoxes de probabilité, la logique, le dialogue, la théorie des jeux, etc.

Si vous explorez le site en question, vous allez vite vous rendre compte que les sujets de biais cognitifs, de théorie des probabilités, de raisonnements bayésiens sont très populaires, avec un autre thème parmi les plus discutés : l'intelligence artificielle.

Vous remarquerez aussi que sur LessWrong, Eliezer Yudkowsky est mis en avant, C'est le créateur du site et la personne qui a écrit un ensemble de textes fondateurs du mouvement ("The Sequences"), il a aussi fondé l'association à qui appartient la plateforme lesswrong.com.

La plateforme de blogging semble être le centre de la communauté. D'autres figures influentes participent aux idées de ce mouvement comme l'autrice du livre "The Scout Mindset" et du podcast "Rationally Speaking" Julia Galef.

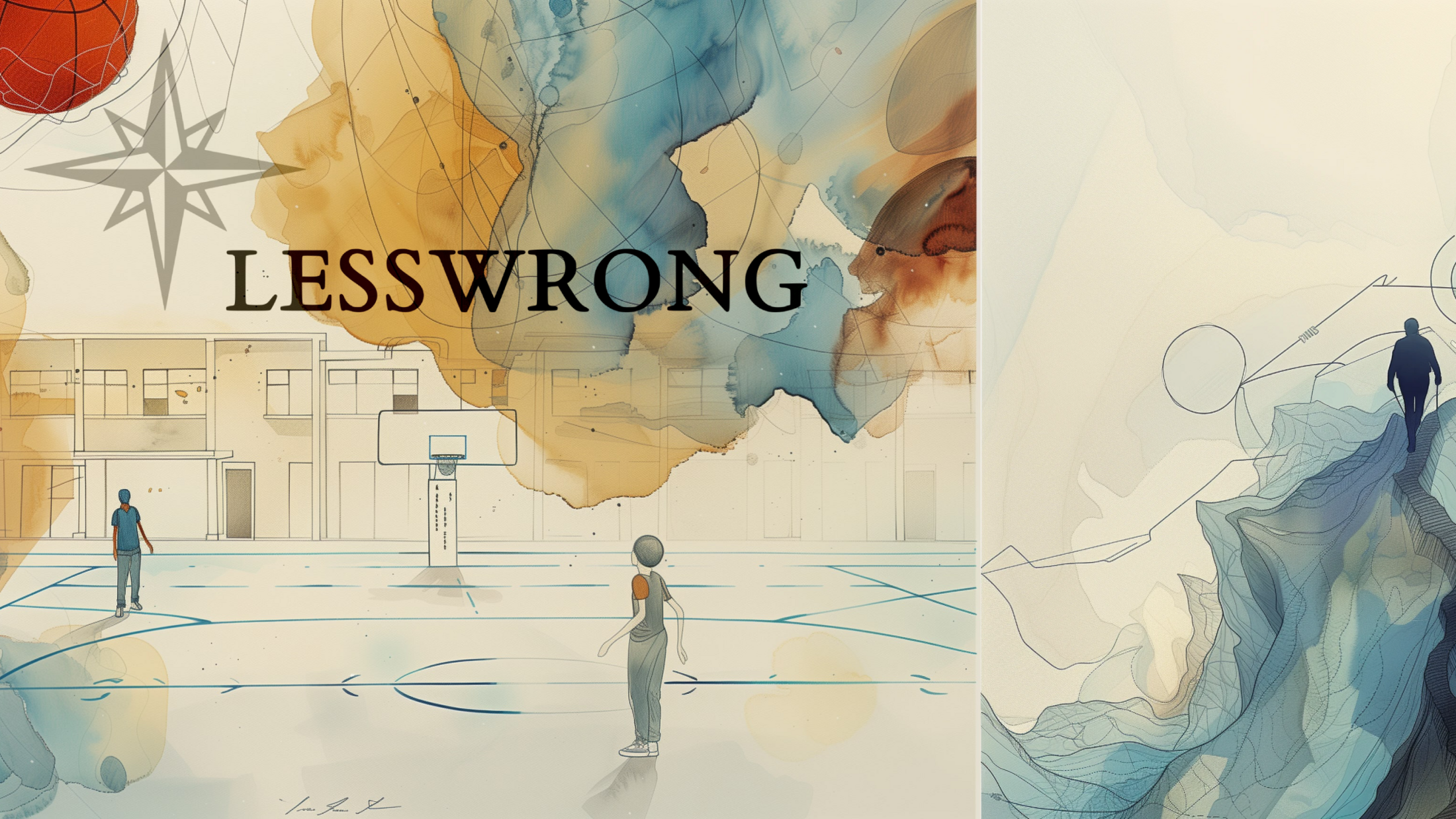

L'altruisme efficace

Agrandissement : Illustration 5

Ce même attrait pour la pensée rationaliste et probabiliste va s'incarner dans un autre mouvement, un mouvement qui essaie d'appliquer ces outils au problème de l'éthique et de la morale. Il va ainsi connecter ces approches théoriques avec des consignes concrètes. Ce qui donnera naissance au mouvement de l'altruisme efficace.

L'altruisme efficace cherche à faire le plus de "bien" possible, pour un grand nombre d'êtres humains, parfois pour des animaux aussi, avec des moyens donnés limités, et dans une approche rationnelle de la morale qui emploie la raison et l'analyse pour prendre de meilleurs choix. Ces principes restent discutés au sein même de ce mouvement.

Je vais illustrer les tiraillements politiques que j'ai pu observer dans ce mouvement avec quelques exemples de positions populaires chez l'altruisme efficace :

- L'argument de la Bugatti (Peter Singer) : équivalence entre acheter une Bugatti et ne pas sauver un grand nombre d'êtres humains d'une mort certaine, condamnation des achats de luxe en général

- Recommandation d'achat de moustiquaires contre les maladies dans les pays qui sont en proie à la malaria.

- Chercher à réduire le risque d'une guerre nucléaire.

- Soutenir une entreprise qui cherche à construire une intelligence artificielle générale pour qu'elle arrive première et obtienne le contrôle du monde à la place d'autres entreprises jugées moins morales. Typiquement OpenAI, dont le C.E.O est lié au mouvement rationaliste et transhumaniste, et à l'altruisme efficace)

- Travailler chez une grande société au lieu de travailler chez une ONG, car avec le salaire obtenu, vous pouvez avoir plus d'impact en le donnant…

- Dans une série d'articles détaillés que je vous invite à lire si vous souhaitez comprendre comment l'altruisme efficace peut s'appliquer au choix de carrière, Benjamin Todd - fondateur de 80000hours.org et appartenant au mouvement de l'altruisme efficace - dit *"... Soyez prudent avec les doctorats en sciences humaines, les emplois caritatifs et les qualifications professionnelles."*

Agrandissement : Illustration 6

J'ai choisi des exemples variés pour montrer que ces mouvements sont hétéroclites, presque paradoxaux, et étant donné le flou du cadre de départ, vous pourrez trouver la chose et son contraire chez deux personnes différentes du même mouvement, voire chez la même personne à travers le temps.

Les conclusions dépendront fortement de l'objectif que vous avez choisi et des erreurs que vous allez éventuellement faire dans votre raisonnement.

Pour un certain nombre d'altruistes efficaces - je ne couvre pas l'ensemble ici, j'essaie de montrer différentes parties - , vous pouvez trouver une certaine déconsidération du militantisme classique comme un mode d'action jugé inefficace et une déconnexion avec l'expérience de lutte pour changer le monde en le mieux. Ces failles sont probablement en lien avec le fait que c'est une sphère technique, scientifique, probablement peu militante.

Cela dit, les réponses qui seront apportées par les différents membres seront de nature radicalement différentes. Si au début la pauvreté était une cause majeure que le mouvement voulait adresser, il s'est par la suite intéressé à l'intelligence artificielle, aux pandémies, et à d'autres considérations plus singulières - et je pense ici plus questionnables - liées à l'idéologie long-termiste.

Le long-termisme

Le long-termisme est une suite relativement contre-intuitive de l'altruisme efficace. Je vais l'introduire à travers deux de ces idées :

La "valeur"

Dans le cadre que nous avons présenté, un des objectifs que j'ai cités était :

- La minimisation de la souffrance de la personne la plus souffrante.

Ce point ne satisfera pas les personnes concernées par la souffrance animale, car je ne l'ai pas intégré dans cet objectif.

De là, de longues discussions peuvent en suivre, étant donné que le monde du vivant couvre un spectre allant des virus aux baleines bleues, voire aux écosystèmes en symbiose, etc.

Est-ce que nous allons donner la même valeur aux humains et aux animaux ? La même aux insectes et aux mammifères ? La même aux cellules et au vivant composé par ces mêmes cellules ? …

Ces questions ont fait en sorte d'introduire un concept flou de "valeur" (qui peut être différente d'un vivant à un autre, voire qui peut être attribuée à des inertes comme à des livres, des monuments, etc.) dont le but est de décrire ce pour quoi on va agir, d'incarner l'"objectif" du cadre probabiliste que nous avons discuté plutôt.

Partant de là, les long-termistes se sont dit que si l'être humain continue son développement, il va faire propager la vie dans d'autres planètes, voire dans le reste de la galaxie ou l'univers…

S'ensuit un passage intellectuellement dangereux. Certains des long-termistes ont décidé de donner de la "valeur" à la "vie" elle-même, pas simplement au "vivant". Par exemple à "l'humanité" plutôt qu'au "humain"...

J'explique :

Dans notre cadre modèle, cela correspond à poursuivre un objectif tel que maximiser le nombre de "vies" par exemple. Si c'est votre choix de poursuivre ce but, vous cherchez pas seulement que des êtres humains ne meurent pas, mais aussi à ce qu'il y ait beaucoup d'êtres humains.

Surtout, vous ne voudrez pas que "l'espèce humaine" s'éteigne, même naturellement.

Certains vont commencer à chercher la pérennité de "l'espèce humaine" (quitte à ce que ça implique d'autres souffrances ou morts humaines par exemple), à avoir plus de naissances etc.

Certains parmi les long-termistes peuvent ainsi discuter et choisir le premier choix parmi :

1. L'humanité perdure des million d'années, tout en ayant des milliards de morts évitables par des guerres ou des maladies, dans des souffrances épouvantables.

2. L'extinction de l'humanité dans 1000 ans, une extinction naturelle, sans mort évitable, sans souffrance, par exemple par une décroissance du nombre d'êtres humains.

La prise en compte du futur lointain

Agrandissement : Illustration 7

Maintenant, nous allons passer par la seconde gymnastique dangereuse, certains long-termistes ont estimé avec une grande certitude que le futur très lointain - des milliards et des milliards d'années dans le futur - contiendra plein de "valeurs" : pensez par exemple à une galaxie peuplée par plein d'êtres humains, de forêts, ou de créatures qui auraient apparu par la suite, dans ce "futur".

D'ici s'ensuit la volonté des (très) long-termistes de faire en sorte que ce futur (très) lointain soit, et que l'on évite l'ensemble des perturbations qui pourraient nous tuer avant.

Si par ailleurs vous êtes confiant de comment vos actions pourront affecter un futur lointain, par exemple dans 10 000 millions d'années ans — ce qui, je pense, est en soi questionnable et probablement une des erreurs fondamentales de cette idéologie — vous allez devoir le prendre en compte, et par conséquent, vos conclusions peuvent être très particulières…

Ces deux points peuvent produire des conclusions arbitraires, voire dangereuses :

- Être confiant sur comment les conséquences d'actions présentes affectent un futur lointain.

- La valorisation de l'existence de l'espèce humaine en soi, pas seulement la vie humaine.

Dans les mouvements rationalistes, le long-termisme reste discuté, ce n'est pas aussi consensuel que l'effective altruisme ou le rationalisme de base. Vous pouvez trouver sur le site 80000hours.org dédié au choix des métiers "qui permettent le plus de bien" (appartenant au mouvement de l'altruisme efficace), des références contre le long-termisme au sein même d'un article qui le défend

Les transhumanismes

J'ai préféré commencer par les rationalismes, même si ce n'est pas l'ordre historique, car aujourd'hui, il me semble que beaucoup de personnes intègrent l'une des idéologies transhumanistes après avoir été dans l'une des idéologies rationalistes.

Cette classe d'idéologies veut aller vers une évolution des êtres humains à travers les sciences et la technologie.

Il existe davantage de courants et d'incarnations des transhumanismes que celles présentées ici. Je vais donc présenter celle qui en est l'origine à la fois historique et idéologique : le transhumanisme, puis je vais décrire quelques idéologies filles comme l'extropianisme, le singularitarisme et le cosmisme.

Le transhumanisme

Agrandissement : Illustration 8

Le transhumanisme est né de la volonté d'augmenter les possibilités humaines, sur des caractéristiques qui n'étaient pas forcément envisagées auparavant, particulièrement à travers une plus grande intelligence et une plus grande longévité.

Les fondateurs du transhumanisme présentent ces augmentations comme des choix libres d'individus, reposant souvent sur des avancées scientifiques et techniques, imaginant ainsi des futurs sans maladie, avec une intégration entre le corps humain et les objets techniques comme des puces ou des membres bioniques.

L'imaginaire et les incarnations visuelles du transhumanisme sont très liés aux différentes œuvres de science-fiction. Vous trouverez de nombreuses similitudes entre le futur souhaité ou prédit par le transhumanisme de nombreuses œuvres d'anticipation, comme par exemple s'augmenter à travers des implants dans le cerveau, des membres bioniques, des outils cognitifs, la possibilité de fusionner avec la machine, de télécharger ses pensées, de soigner son corps de toutes les maladies à travers une armée de nanorobots, etc.

Cela dit, le transhumanisme n'est pas un rêve théorique, ces prometteurs cherchent à l'appliquer concrètement. Certains expliquent que la vie actuelle est déjà transhumaniste de par les interactions profondes avec internet ou avec les objets de technologie comme les ordinateurs, téléphones portables, etc.

Un point historique important, qui continue d'avoir des conséquences jusqu'à aujourd'hui, est que des liens entre le transhumanisme et l'eugénisme ont existé et continuent d'avoir un effet : le transhumanisme est né dans une sphère influencée par l'eugénisme. Julian Huxley, président de la société britannique eugénique dans les années soixante, a été parmi les premiers transhumanistes. Le concept du transhumanisme a été souvent utilisé dans ses débuts par d'anciens eugénistes.

L'eugénisme est une idéologie qui cherche à sélectionner des caractéristiques génétiques particulières en application des théories biologiques génétiques, de manière techniquement proche de ce qui est aujourd'hui fait avec des animaux pour "construire" un certain type de chien à travers une sélection génétique.

Cette sélection peut se faire soit en rendant la reproduction des caractéristiques non "souhaitable" difficile - eugénisme dit "négatif" - soit en encourageant la reproduction des porteurs de caractéristiques "souhaitables" - eugénisme dit "positif" . Tout ceci a trouvé dans des idéologies racistes, validistes et xénophobes des incarnations politiques.

Si l'eugénisme a eu cette vision génétique des caractéristiques humaines, le transhumanisme lui inclut la génétique, avec par exemple la défense de la possibilité de choisir des modifications des gènes avec des techniques plus modernes que la sélection naturelle, mais ne s'y restreint pas, en utilisant d'autres vecteurs "d'augmentation" comme la science et la technologie.

Cet héritage eugénique a aussi affecté certains outils que ce mouvement utilise régulièrement, comme la mesure controversée du quotient intellectuel.

Cela dit, aujourd'hui, le transhumanisme regroupe des personnes qui ne sont pas forcément en lien avec l'eugénisme ; des personnes au sein de ce mouvement peuvent porter des idées radicalement différentes, voire contradictoires, de l'anarcho-transhumanisme anticapitaliste à l'immortalisme ou le transbiologisme avec la recherche d'une évolution provoquée des autres espèces non humaines vers un niveau "d'intelligence" humain…

L'extropianisme

Agrandissement : Illustration 9

Le mouvement extropian est l'une des premières incarnations structurées du transhumanisme. Ce mouvement va préciser davantage la vision vers laquelle le transhumanisme doit aller, et fondera des organisations et un journal, entre autres. Vous trouverez par exemple l'ensemble suivant des principes qui forment l'actuel — il est mis à jour — manifeste extropian :

- Extension sans fin

- Transcender les restrictions

- Dépasser la propriété

- L'intelligence

- Les machines intelligentes

Ils sont mus par une volonté de "croissance" perpétuelle dans tous les aspects de "l'épopée humaine".

Les idées présentées couvrent le concept d'"augmentation humaine", avec un refus des "limites", le refus de la propriété, de la monnaie, des brevets, etc.

Ils cherchent aussi la création d'une "Intelligence Artificielle Amie", et refusent ce qui pourrait entraver ce but, notamment les législations. En ce sens, ils se définissent aujourd'hui — leur manifeste a évolué avec le temps — comme appartenant au "singularitarisme", c'est-à-dire qu'ils souhaitent et œuvrent pour la construction de l'intelligence artificielle générale.

Le singularitarisme

Agrandissement : Illustration 10

C'est un mouvement qui est centré sur la considération d'une rupture de la croissance technologique. L'idée est qu'une accélération du progrès scientifique et technologique provoquera une rupture majeure. Cette accélération est particulièrement incarnée chez les singularitariens par la progression de l'intelligence artificielle.

Les singularitariens voient ainsi que la progression des performances de l'intelligence artificielle sera exponentielle et provoquera une rupture une fois qu'un niveau analogue à l'intelligence humaine sera atteint.

Un point fondamental est que les singularitariens cherchent à atteindre ce futur avec des intelligences artificielles surhumaines, et œuvrent pour cela.

Le cosmisme

Agrandissement : Illustration 11

Le cosmisme est une idéologie qui a des racines dans un courant religieux apparu en Russie, mais dont les évolutions et les interactions on intégré certaine de ces variation au sein du mouvement transhumaniste.

Le consmisme au lieu de s'arrêter à l'augmentation de l'être humain, regarde ce "progrès" comme affectant beaucoup d'autres choses comme la nature, le monde, la réalité, la physique, l'univers, la vie et les vivants, etc.

En ce sens, c'est une idéologie de transformation radicale et futuriste de tout ce qui est existant, encore plus générale et globale que le transhumanisme de base.

Les cosmistes discutent ainsi des futurs qui pourraient selon eux devenir réels, où l'être humain pourra se remodeler, télécharger ses pensées, être immortel, réingénierer l'espace et le temps, se téléporter, transformer son corps, etc.

Clivages politiques

Le prisme TESCREAL et ses limites

Agrandissement : Illustration 12

Les dernières années ont vu apparaître un clivage différent, réfléchi et structuré par des figures majeures de la gauche tech, principalement Timnit Gebru et Émile Torres.

Ce clivage critique l'ensemble de ces idéologies comme étant un problème en soi, les considérant comme des idéologies fondamentalement eugéniques (en lien avec l'histoire du transhumanisme au 20ᵉ siècle). Ces idéologies sont ainsi désignées sous l'acronyme que j'ai cité au début de cet article TESCREAL : { Transhumanism - Extropianism - Singularitarianism - Cosmism - Rationalism - Effective Altruism - Longtermism }.

Si je pense que des liens existent sur plusieurs plans entre ces idéologies, il me semble réducteur de traiter l'ensemble comme un tout, surtout dans des contextes politiques où il peut arriver que des personnes appartenant à la même idéologie soient d'extrême droite ou d'extrême gauche.

Je crois qu'il faut regarder d'autres marqueurs, d'autres prismes de lecture qui permettent de mieux scinder les différentes branches et pratiques concrètes de ces idéologies si l'on souhaite faire un bon traitement intellectuel et politique de ces idées.

Leaders et communauté tech

Cela dit, il est important de comprendre qu'il y a au moins deux "groupes" de personnes qui doivent être traités différemment. Les profils que je vais citer ne sont que des stéréotypes, dont je pense qu'ils sont relativement communs au sein des deux groupes dont je veux parler :

- Groupe A : les personnes impliquées dans les mouvements, militants, idéologues, financeurs, cercles d'entrepreneurs étatsuniens, fondateurs d'associations ou de fondations autour des idéologies, etc.

- Groupe B : étudiants dans des disciplines scientifiques, étudiants en philosophie des sciences ou épistémologie, doctorants en intelligence artificielle, chercheurs en informatique théorique, développeurs, philosophes analytiques, etc.

Si le groupe A est composé de personnes qui ont structuré leur pensée et sont parfois inspirées par les racines idéologiques historiques des idéologies futuristes, le second groupe a plusieurs particularités qu'il est important d'analyser spécifiquement.

D'abord, certaines personnes peuvent développer des idées qui s'inscrivent dans l'une des idéologies rationalistes ou transhumanistes sans avoir été en contact avec les grandes figures ou "leaders" du milieu. C'est très souvent le cas pour des étudiants dans les domaines de l'informatique théorique ou des différentes sciences connexes à l'intelligence artificielle. Décrire ce milieu avec - uniquement - les notions TESCREAL devient réducteur.

Cela sera la base du clivage que je vais proposer par la suite, qui me semble plus politiquement adapté.

De la même manière, vous trouverez des étudiants qui espèrent que tout le monde ait la même quantité d'argent sans même connaître le nom d'aucune figure socialiste ou communiste de l'histoire ; parfois, cela peut même arriver avec un élève en primaire.

Certes, dans toutes les idéologies, vous allez trouver des différences entre les personnes qui portent des idées en question comparées aux théoriciens ou aux soutiens concrets. Cela dit, je pense que dans le cas présent, il y a une différence de nature entre les deux groupes :

Étant donné que ces idéologies ont des bases floues, les applications concrètes font toute la différence. Cela signifie que vous pouvez obtenir des idées d'extrême gauche ou d'extrême droite dans la même idéologie.

Il se trouve que le groupe A a convergé vers une vision globalement de droite et d'extrême droite, avec des racines eugéniques, parfois racistes, et un culte de l'intelligence et des tests de QI. Le groupe B reste hétérogène, avec beaucoup d'idées de gauche et d'extrême gauche.

Négliger le groupe B, à un moment où l'extrême droite n'a peut-être jamais été aussi puissante dans la sphère technologique, est à mon sens une profonde erreur.

Aujourd'hui, la séparation des deux futurismes

Agrandissement : Illustration 13

Aujourd'hui, il y a un nouveau clivage émergent :

- Ceux qui seront plus prudents, plus incertains, plus enclins à partager l'expérience militante classique, plus critiques envers les dérives ou erreurs partagées par d'autres membres de la même idéologie.

- Ceux qui vont promouvoir plus de technologie et de science, avec une grande considération pour un avenir lointain qui éclipse tout présent, et une déconsidération des luttes classiques, en ignorant ou acceptant les risques, en particulier de l'intelligence artificielle

Ce nouveau clivage se dessine autour du comportement à adopter face au risque de la conception d'une intelligence artificielle générale. Le premier groupe correspond à ceux qui souhaitent un arrêt ou un ralentissement important de la recherche, souvent désignés comme appartenant au mouvement Pause AI / Decel (en anglais "Decelerate", freiner). Les seconds sont dans le mouvement E/ACC (Effective Accelerationism).

Beaucoup de sympathisants, voire de militants et personnes influentes au sein du mouvement de l'effective altruisme ont aujourd'hui choisi d'être contre le mouvement de l'accélérationnisme efficace (pause ai, stop ai, decel, etc.).

Le conflit qui a eu lieu chez OpenAI a en partie été lié à ces divergences idéologiques. Sam Altman, le C.E.O. a été contraint de quitter sa position avant de rapidement la reprendre.

Si des figures majeures du mouvement de décélération sont toujours problématiques, ce n'est à mon sens pas le cas de la base des nouveaux profils qui adhèrent aux idées de ce mouvement.

J'ai décidé de mettre en avant ce clivage car il me semble fondamentalement se ramener au clivage usuel gauche-droite de manière plus juste que si l'on essaie de placer les mouvements associés aux nouvelles idéologies futuristes floues et non définies. Ici, on a un objectif concret, clair et clivant qui permet de savoir en pratique ce qui doit ou ne doit pas être fait face à un risque proche dans le temps.

Les figures E/ACC sont aujourd'hui ce que l'on peut appeler la droite ou l'extrême droite technique. Les figures qui s'opposent à l'intelligence artificielle générale représentent la gauche tech.

Agrandissement : Illustration 14

Un texte qui me semble porter cette idéologie E/ACC est le manifest du techno-optimisme, je cite un exemple qui me semble faire le lien avec la pensée capitalistique et concurrentielle "Les Techno-Optimistes croient que la société, comme les requins, croît ou meurt. Nous croyons que la croissance est le progrès". Ce texte a été qualifié de "futurisme réactionnaire" par le journaliste Ezra Klein, qui a lui-même couvert positivement un des livres long-termistes majeurs "What We Owe The Future" de William MacAskill.

Les cheminements de la gauche

Agrandissement : Illustration 15

Face à ces idéologies regroupant des personnes aux idées politiquement opposées, la gauche s'est posé beaucoup de questions. Elle a, à mon sens, plusieurs erreurs à corriger dans son rapport à ces nouvelles idéologies scientifiques et techniques.

L'opposition entre la morale concrète — pratique de l'aide, du partage, du militantisme associatif, etc. — et les théories de la morale ou d'éthique, particulièrement chez les rationalistes — analyse de situations théoriques, dilemmes théoriques, analyse d'hypothèses futuristes, modélisation théorique, etc. — ne me semble pas productive dans sa forme actuelle.

Il est important de reconnaître que les modèles sont utiles, à condition de prendre en compte leurs limites et les effets secondaires qu'ils peuvent engendrer, que les expériences de pensée peuvent être une source de réflexion.

Ce sont un prisme qui peut être éclairant s'il est bien utilisé, aveuglant si on n'utilise rien d'autre.

Le conflit avec les rationalistes, par exemple avec l'altruisme efficace, doit être porté davantage sur les incarnations politiques questionnables (le choix des causes à prioriser, par exemple).

La confusion entre les outils quantitatifs (qui sont parfois vus comme le problème en soi) et les prémisses d'objectifs que peuvent porter certains longtermistes, nécessite une clarification.

Il ne faut pas ignorer les problèmes soulevés par ces hypothèses ou prédictions, même si elles ne sont pas communes ou qu'elles semblent délirantes dans leur forme, tant que leur raisonnement ne comporte pas d'erreurs (ce qui est pour moi le cas dans beaucoup de réflexion long-termiste). Il est essentiel de traiter le fond de ces questions pour éviter des incompréhensions et des préjugés infondés.

Une opposition entre le bien présent et le bien futur me semble être une erreur de diagnostic des fails du long-termisme. Il est crucial de travailler sur les horizons futurs sans négliger les enjeux actuels, car aujourd'hui et demain méritent nos efforts, à condition de ne pas supposer des certitudes là où il n'y en a pas, ou d'oublier que le présent a un effet sur le futur.

Prévoir des stratégies à 20, 40, voire peut-être même 100 ans ne semble pas absurde. Ce n'est pas le cas de 3 millions d'années.

L'horizon des égalités doit rester ouvert, l'humanisme n'est pas sa fin. Si aujourd'hui la considération des autres vivants comme les animaux n'est plus marginale, nous devons rester ouverts à ce qui pourrait être considéré comme vivant à l'avenir. Il est important de ne pas ignorer ces questions, notamment en ce qui concerne les intelligences artificielles.

Les préoccupations immédiates comme la survie quotidienne — "fin du mois" — et les enjeux globaux tels que les risques de grande ampleur — "fin du monde" — sont liés et doivent être abordés conjointement, l'un enrichi et corrige l'autre.

Comme dans le climat, la fin du monde nous éclairera sur les solutions au long court à ne pas prendre (investir dans le charbon pour réindustrialiser), la fin du mois imprègnera nos réflexions théoriques et nous empêchera de nous perdre en gardant contact avec la source même des altruismes et de L'éthique : l'empathie pour son prochain.

Dans le flou et la spécificité de ces idéologies, il est essentiel de ne pas se tromper d'ennemis : les accélérationnistes, les capitalistes, l'extrême droite, les idéologies de discrimination, etc.

Comprendre leurs positions, mieux les caractériser, ne pas généraliser les communautés des domaines qui nous sont étrangers, permet de mieux contrer et de défendre efficacement ce qui nous tient à cœur.

Mail pour contact

ansar.add.contact [ at ] gmail [ point ] com

Références

Plateforme de blogging lesswrong.com

Article de blog sur l’altruisme efficace

Guide de carrière de 80000hours.org

Publication sur les TESCREAL par Timnit Gebru et Émile P. Torres

Manifeste du techno-optimisme publier sur le site du fond d'investissement a16z