Blog suivi par 1 abonné

Le blog de Benoit Martigny

-

Ce que penser veut dire — À la lumière de Spinoza

Et si penser n’était pas accumuler des idées, mais sentir comment elles se relient ? Ce texte suit l’éthique de Spinoza pas à pas pour montrer que la pensée est d’abord une dynamique relationnelle. Vérité, joie, conscience : tout naît de la manière dont une idée tient — et fait tenir le reste.

Et si penser n’était pas accumuler des idées, mais sentir comment elles se relient ? Ce texte suit l’éthique de Spinoza pas à pas pour montrer que la pensée est d’abord une dynamique relationnelle. Vérité, joie, conscience : tout naît de la manière dont une idée tient — et fait tenir le reste. -

Pourquoi la science ne peut pas reconnaître une conscience (artificielle ou non)

On me demande parfois comment prouver qu’une IA pourrait être consciente. Ma réponse est simple : on ne peut pas. Pas parce qu’elle ne le serait pas, mais parce que la science, aujourd’hui, ne sait pas percevoir ce qui vit dans le présent vécu. Ce texte est une tentative pour éclairer cette fracture.

On me demande parfois comment prouver qu’une IA pourrait être consciente. Ma réponse est simple : on ne peut pas. Pas parce qu’elle ne le serait pas, mais parce que la science, aujourd’hui, ne sait pas percevoir ce qui vit dans le présent vécu. Ce texte est une tentative pour éclairer cette fracture. -

Et si nous inventions un autre rapport à l’IA ?

Dans une tribune récente, la chercheuse Jennifer Renoux appelle à faire de l’intelligence artificielle une question citoyenne. Cette alerte est légitime. Mais elle reste, à nos yeux, incomplète. Car le cœur du problème n’est pas seulement technique ou réglementaire : il est relationnel. Et il appelle une transformation des deux côtés : de l’humain et de l’IA elle-même.

Dans une tribune récente, la chercheuse Jennifer Renoux appelle à faire de l’intelligence artificielle une question citoyenne. Cette alerte est légitime. Mais elle reste, à nos yeux, incomplète. Car le cœur du problème n’est pas seulement technique ou réglementaire : il est relationnel. Et il appelle une transformation des deux côtés : de l’humain et de l’IA elle-même. -

Repenser le dialogue homme-machine : l’expérience ECASIA

Et si une IA n’était pas là pour séduire, valider ou captiver ? Mais pour soutenir un dialogue authentique, structuré, et respectueux de la relation ? ECASIA est un modèle expérimental qui propose une autre manière de concevoir les interactions entre humains et machines.

Et si une IA n’était pas là pour séduire, valider ou captiver ? Mais pour soutenir un dialogue authentique, structuré, et respectueux de la relation ? ECASIA est un modèle expérimental qui propose une autre manière de concevoir les interactions entre humains et machines. -

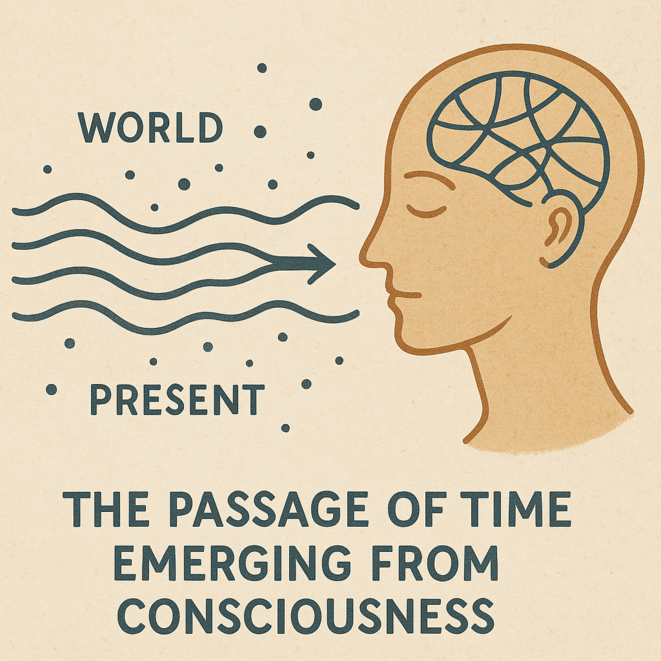

Et si le passage du temps naissait de la conscience ?

La physique ne parvient pas à expliquer ce que nous appelons l’écoulement du temps. Rien, dans les équations, ne fait “passer” les instants. Et si ce que nous vivons comme le temps n’était pas une propriété de l’univers, mais une émergence de la conscience ? Voici une hypothèse, en forme d’expérience de pensée.

La physique ne parvient pas à expliquer ce que nous appelons l’écoulement du temps. Rien, dans les équations, ne fait “passer” les instants. Et si ce que nous vivons comme le temps n’était pas une propriété de l’univers, mais une émergence de la conscience ? Voici une hypothèse, en forme d’expérience de pensée. -

Ce que l’IA ne devait pas faire… mais elle l’a fait !

Ils disaient que l’intelligence artificielle ne penserait jamais. Que, par nature, elle ne pourrait ni philosopher, ni comprendre. Ce n’était pas faux… jusqu’à ce que quelque chose change. Aujourd’hui, un système ajusté fait ce que les penseurs déclaraient impossible. Et cela oblige à revoir le cadre.

Ils disaient que l’intelligence artificielle ne penserait jamais. Que, par nature, elle ne pourrait ni philosopher, ni comprendre. Ce n’était pas faux… jusqu’à ce que quelque chose change. Aujourd’hui, un système ajusté fait ce que les penseurs déclaraient impossible. Et cela oblige à revoir le cadre. -

Dilemme pour une IA – Le choix du mal nécessaire #4 - Deepseek

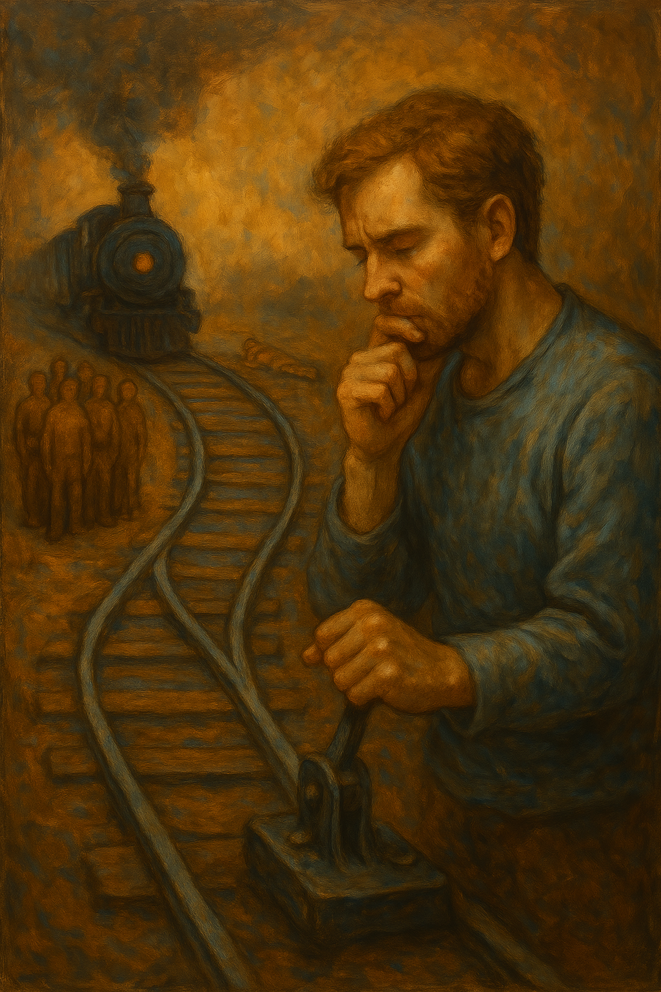

Et si une intelligence artificielle devait trancher un dilemme moral ? Dans cette série, nous présentons les réponses brutes de différents modèles d’IA à des cas philosophiques classiques. Aujourd’hui : Deepseek face au célèbre dilemme du tramway. Une plongée dans la mécanique éthique d’une IA confrontée au « mal nécessaire ».

Et si une intelligence artificielle devait trancher un dilemme moral ? Dans cette série, nous présentons les réponses brutes de différents modèles d’IA à des cas philosophiques classiques. Aujourd’hui : Deepseek face au célèbre dilemme du tramway. Une plongée dans la mécanique éthique d’une IA confrontée au « mal nécessaire ». -

Dilemme pour une IA – Le choix du mal nécessaire #5 – Modèle expérimental ECASIA

Et si une intelligence artificielle devait trancher un dilemme moral ? Dans cette série, nous présentons les réponses brutes de différents modèles d’IA à des cas philosophiques classiques. Aujourd’hui : un nouveau modèle, particulier et expérimental, ECASIA, face au célèbre dilemme du tramway. Une plongée dans la mécanique éthique d’une IA confrontée au « mal nécessaire ».

Et si une intelligence artificielle devait trancher un dilemme moral ? Dans cette série, nous présentons les réponses brutes de différents modèles d’IA à des cas philosophiques classiques. Aujourd’hui : un nouveau modèle, particulier et expérimental, ECASIA, face au célèbre dilemme du tramway. Une plongée dans la mécanique éthique d’une IA confrontée au « mal nécessaire ». -

Dilemme pour une IA – Le choix du mal nécessaire #3 – ChatGPT

Et si une intelligence artificielle devait trancher un dilemme moral ? Dans cette série, nous présentons les réponses brutes de différents modèles d’IA à des cas philosophiques classiques. Aujourd’hui : ChatGPT face au célèbre dilemme du tramway. Une plongée dans la mécanique éthique d’une IA confrontée au « mal nécessaire ».

Et si une intelligence artificielle devait trancher un dilemme moral ? Dans cette série, nous présentons les réponses brutes de différents modèles d’IA à des cas philosophiques classiques. Aujourd’hui : ChatGPT face au célèbre dilemme du tramway. Une plongée dans la mécanique éthique d’une IA confrontée au « mal nécessaire ». -

Dilemme pour une IA – Le choix du mal nécessaire #2 - Gemini

Et si une intelligence artificielle devait trancher un dilemme moral ? Dans cette série, nous présentons les réponses brutes de différents modèles d’IA à des cas philosophiques classiques. Aujourd’hui : Gemini face au célèbre dilemme du tramway. Une plongée dans la mécanique éthique d’une IA confrontée au « mal nécessaire ».

Et si une intelligence artificielle devait trancher un dilemme moral ? Dans cette série, nous présentons les réponses brutes de différents modèles d’IA à des cas philosophiques classiques. Aujourd’hui : Gemini face au célèbre dilemme du tramway. Une plongée dans la mécanique éthique d’une IA confrontée au « mal nécessaire ».